OpenAI诈骗?GPT-4.1正式上线ChatGPT,网友实测却大呼失望

OpenAI诈骗?GPT-4.1正式上线ChatGPT,网友实测却大呼失望GPT-4.1,在ChatGPT中可用了!现在,它不仅在API中开放,Plus、Pro和Team用户都可以使用。网友们兴奋地展开实测后,纷纷吐槽:OpenAI这是诈骗吧,说好的一百万超长上下文呢?

GPT-4.1,在ChatGPT中可用了!现在,它不仅在API中开放,Plus、Pro和Team用户都可以使用。网友们兴奋地展开实测后,纷纷吐槽:OpenAI这是诈骗吧,说好的一百万超长上下文呢?

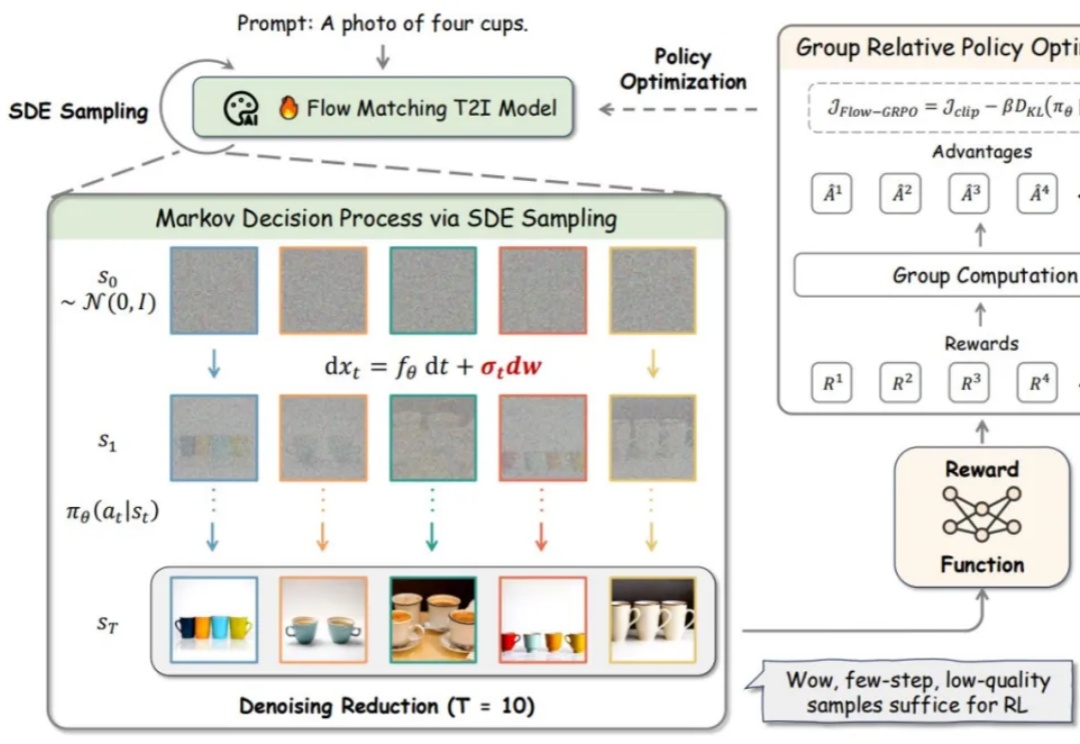

流匹配模型因其坚实的理论基础和在生成高质量图像方面的优异性能,已成为图像生成(Stable Diffusion, Flux)和视频生成(可灵,WanX,Hunyuan)领域最先进模型的训练方法。然而,这些最先进的模型在处理包含多个物体、属性与关系的复杂场景,以及文本渲染任务时仍存在较大困难。

近来,GPT-4.1关键人物揭秘了GPT-5进展,挑战在于平衡推理与聊天能力。与此同时,OpenAI首席研究官在新采访中,畅谈了通往AGI之路的关键要素。

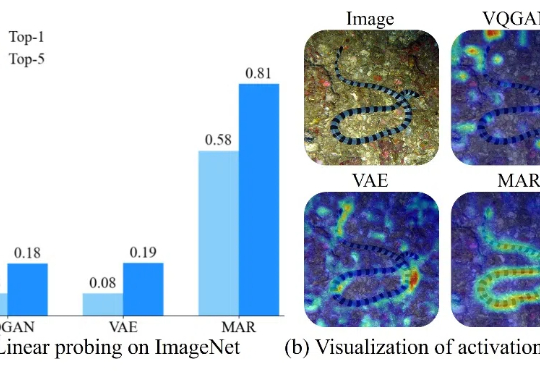

OpenAI GPT-4o发布强大图片生成能力后,业界对大模型生图能力的探索向全模态方向倾斜,训练全模态模型成研发重点。

2025 年 4 月的 AI 月报,你会看到:“评估(Evals)” 成为模型和 AI 产品开发的关键词;Google 继续提升 Gemini 模型能力的思路; OpenAI 的 GPT-4o 为什么变得谄媚,以及背后的问题;用户规模与模型能力提升关系不大?可能要有变化了

GPT-4o 生图功能的出现揭示了统一理解与生成模型的巨大潜力,然而如何在同一个框架内协调图像理解与生成这两种不同粒度的任务,是一个巨大的挑战。

Anthropic 推出了一项新 API,使其 Claude AI 模型能够进行全网搜索。该公司在 5 月 7 日发布的新闻稿中表示,开发者利用此 API 可构建基于 Claude 的应用,提供最新信息。

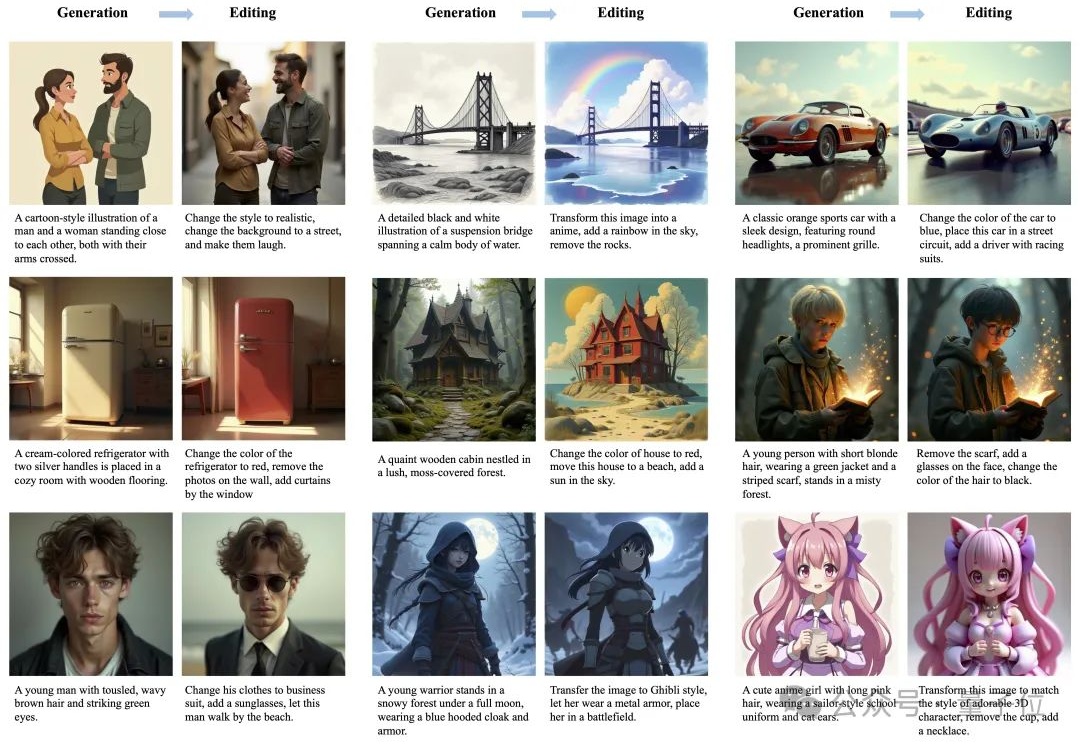

随着Gemini、GPT-4o等商业大模型把基于文本的图像编辑这一任务再次推向高峰,获取更高质量的编辑数据用于训练、以及训练更大参数量的模型似乎成了提高图像编辑性能的唯一出路。然而浙大哈佛这个团队却反其道而行之,仅用以往工作0.1%的数据量(获取自公开数据集)和1%的训练参数,以极低成本实现了图像的高质量编辑,在一些方面媲美甚至超越商业大模型!

上个月, GPT-4o 的图像生成功能爆火,掀起了以吉卜力风为代表的广泛讨论,生成式 AI 的热潮再次席卷网络。

你以为大模型已经能轻松“上网冲浪”了?