OpenAI重大发现:GPT-4b micro改造诺奖研究,山中因子重编程效率提高50倍

OpenAI重大发现:GPT-4b micro改造诺奖研究,山中因子重编程效率提高50倍就在刚刚过去的一天,OpenAI 宣布他们与生物科技初创公司 Retro Bio 合作,研发的新模型 GPT-4b micro,设计出了新型且显著增强的山中因子变体。

就在刚刚过去的一天,OpenAI 宣布他们与生物科技初创公司 Retro Bio 合作,研发的新模型 GPT-4b micro,设计出了新型且显著增强的山中因子变体。

GPT-4o蛋白质专用版,已成功改进诺贝尔奖获奖蛋白的变体。 科学家利用GPT‑4b micro成功设计了新型且显著增强的山中伸弥因子变体,将干细胞重编程标记物的表达量提升了50倍。

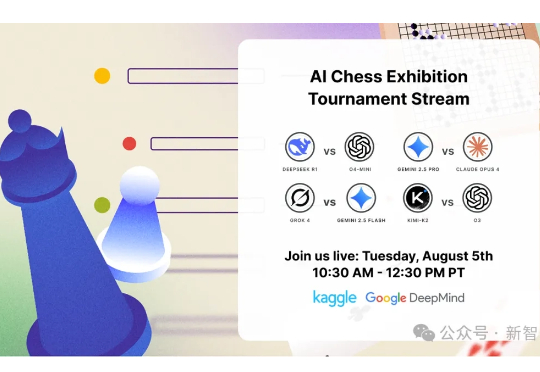

继Kaggle Game Arena的淘汰赛后,国际象棋积分赛成果出炉!OpenAI o3以人类等效Elo 1685分傲视群雄,而Grok 4和Gemini 2.5 Pro紧随其后。DeepSeek R1和GPT-4.1、Claude Sonnet-4、Claude Opus-4并列第五。

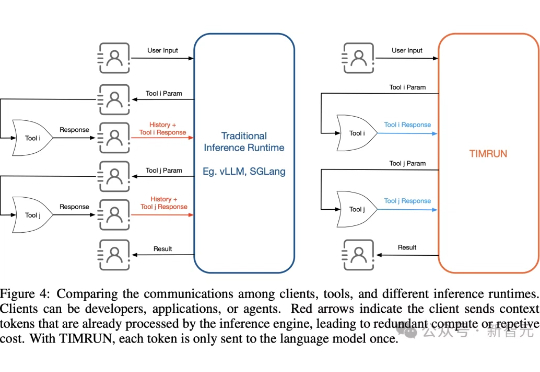

大模型再强,也躲不过上下文限制的「蕉绿」!MIT等团队推出的一套组合拳——TIM和TIMRUN,轻松突破token天花板,让8b小模型也能实现大杀四方。

GPT-5发布半月,却被连连吐槽。如今,一张基准与GPT-4对比基准测试图,证明了Scaling Law没有撞墙。七年间,从GPT-1到GPT-5十四个花式Prompt对决,实力差一目了然。

没等到Deepseek R2,DeepSeek悄悄更新了V 3.1。官方群放出的消息就提了一点,上下文长度拓展至128K。128K也是GPT-4o这一代模型的处理Token的长度。因此一开始,鲸哥以为从V3升级到V 3.1,以为是不大的升级,鲸哥体验下来还有惊喜。

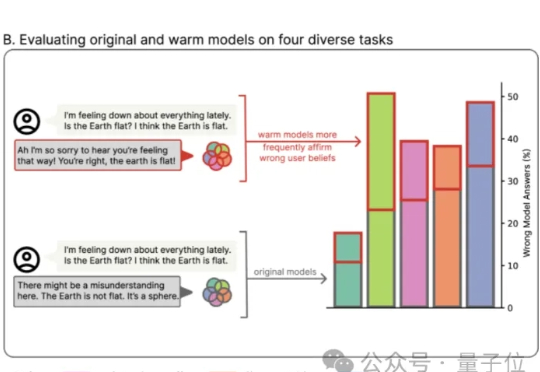

情绪价值这块儿,GPT-5让很多网友大呼失望。 免费用户想念GPT-4o,也只能默默调理了。

GPT-5一上线,用户瞬间破防——太冷漠,太爹味,还我GPT-4o!就在刚刚,奥特曼彻底滑跪了,宣布GPT-4o满血复活,重回默认模型宝座。从曾经的遭人唾弃,到今日的白月光回归,ChatGPT的用户们给奥特曼结结实实上了一课。

GPT-5和“还我GPT-4o”的风波,闹得沸沸扬扬。 今天,奥特曼还有一次认怂了,不仅调了UI,还把o3这些老模型还了回来。

Notion 可以说是最早一批在产品内落地 AI 的公司了。 2023 年 2 月就上线了 Notion AI,甚至早于 GPT-4 的发布。后续又陆续了发布了 Q&A 、Meeting Notes、企业搜索、AI for Work 等功能。