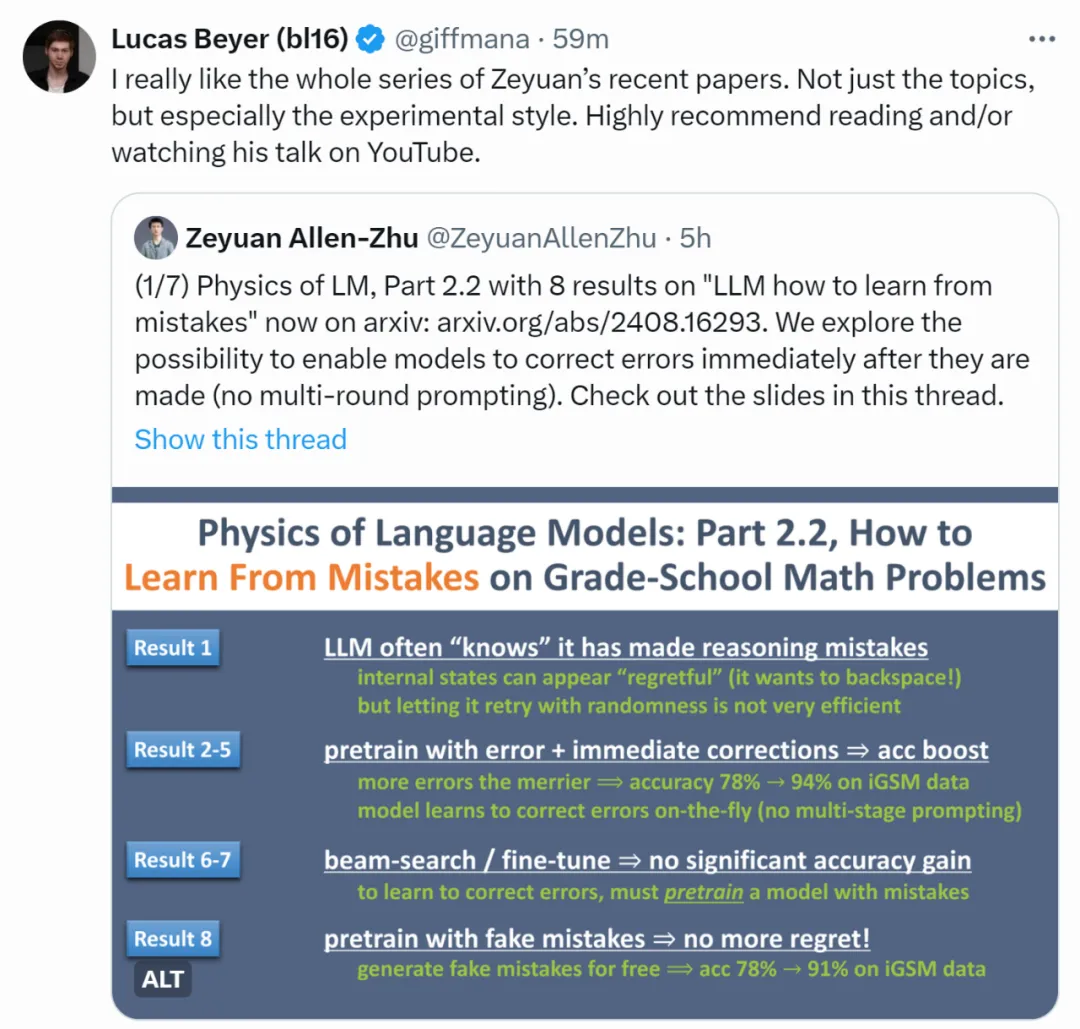

大模型边推理边纠错,有可能做到吗?这是ICML爆火的演讲

大模型边推理边纠错,有可能做到吗?这是ICML爆火的演讲即便是最强大的语言模型(LLM),仍会偶尔出现推理错误。除了通过提示词让模型进行不太可靠的多轮自我纠错外,有没有更系统的方法解决这一问题呢?

即便是最强大的语言模型(LLM),仍会偶尔出现推理错误。除了通过提示词让模型进行不太可靠的多轮自我纠错外,有没有更系统的方法解决这一问题呢?

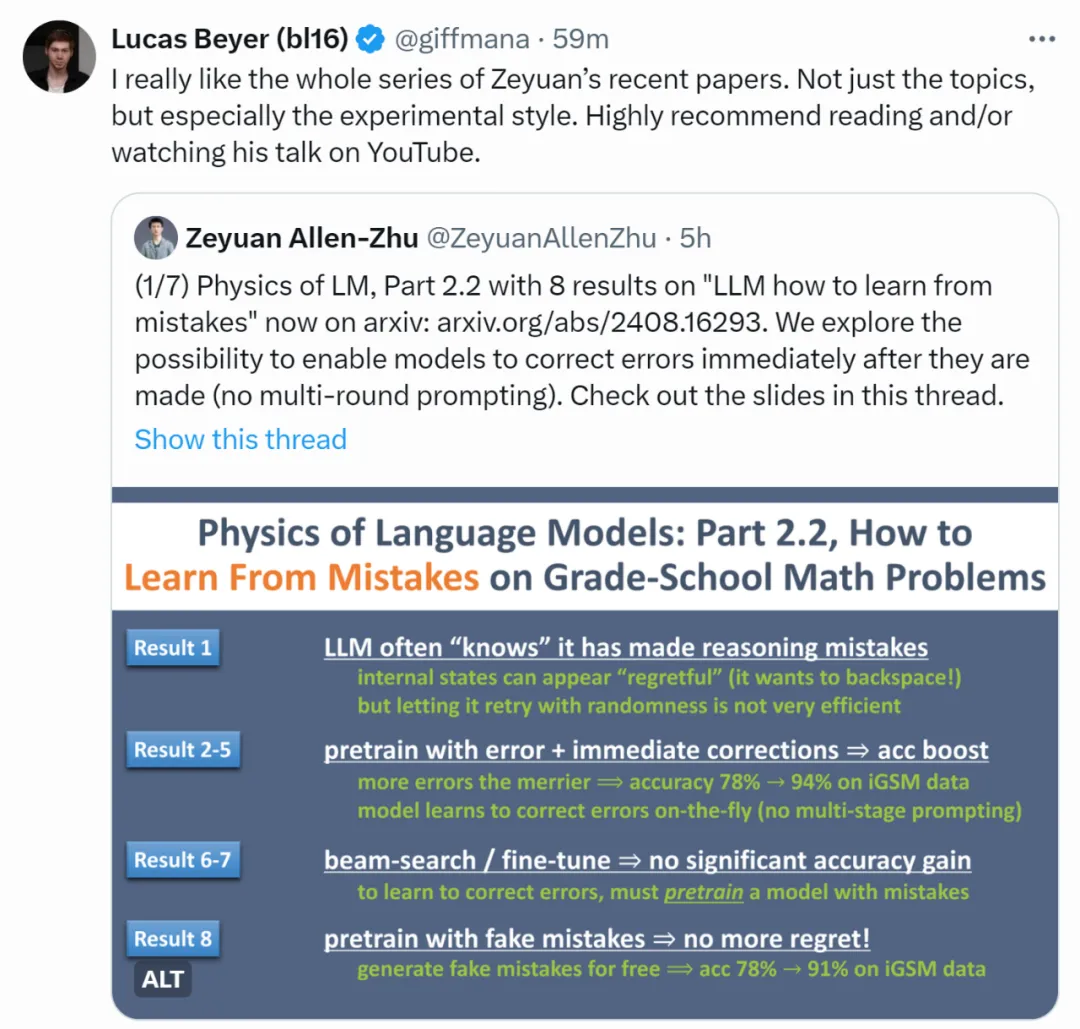

一直否定AI的回答会怎么样?GPT-4o和Claude有截然不同的表现,引起热议。

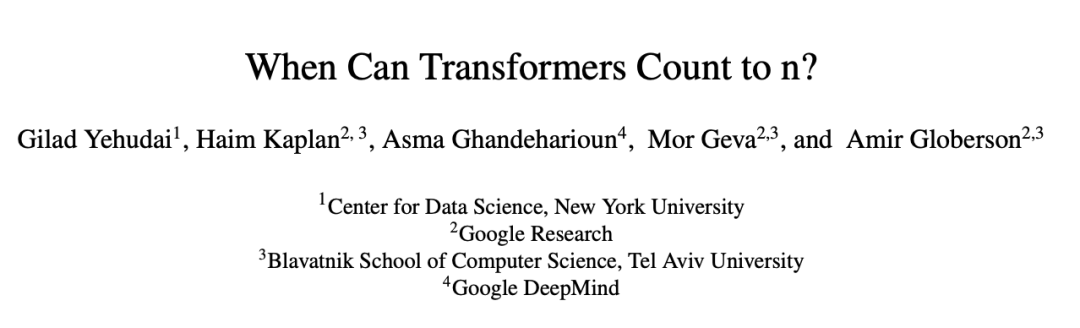

提示工程师Riley Goodside小哥,依然在用「Strawberry里有几个r」折磨大模型们,GPT-4o在无限次PUA后,已经被原地逼疯!相比之下,Claude坚决拒绝PUA,是个大聪明。而谷歌最近的论文也揭示了本质原因:LLM没有足够空间,来存储计数向量。

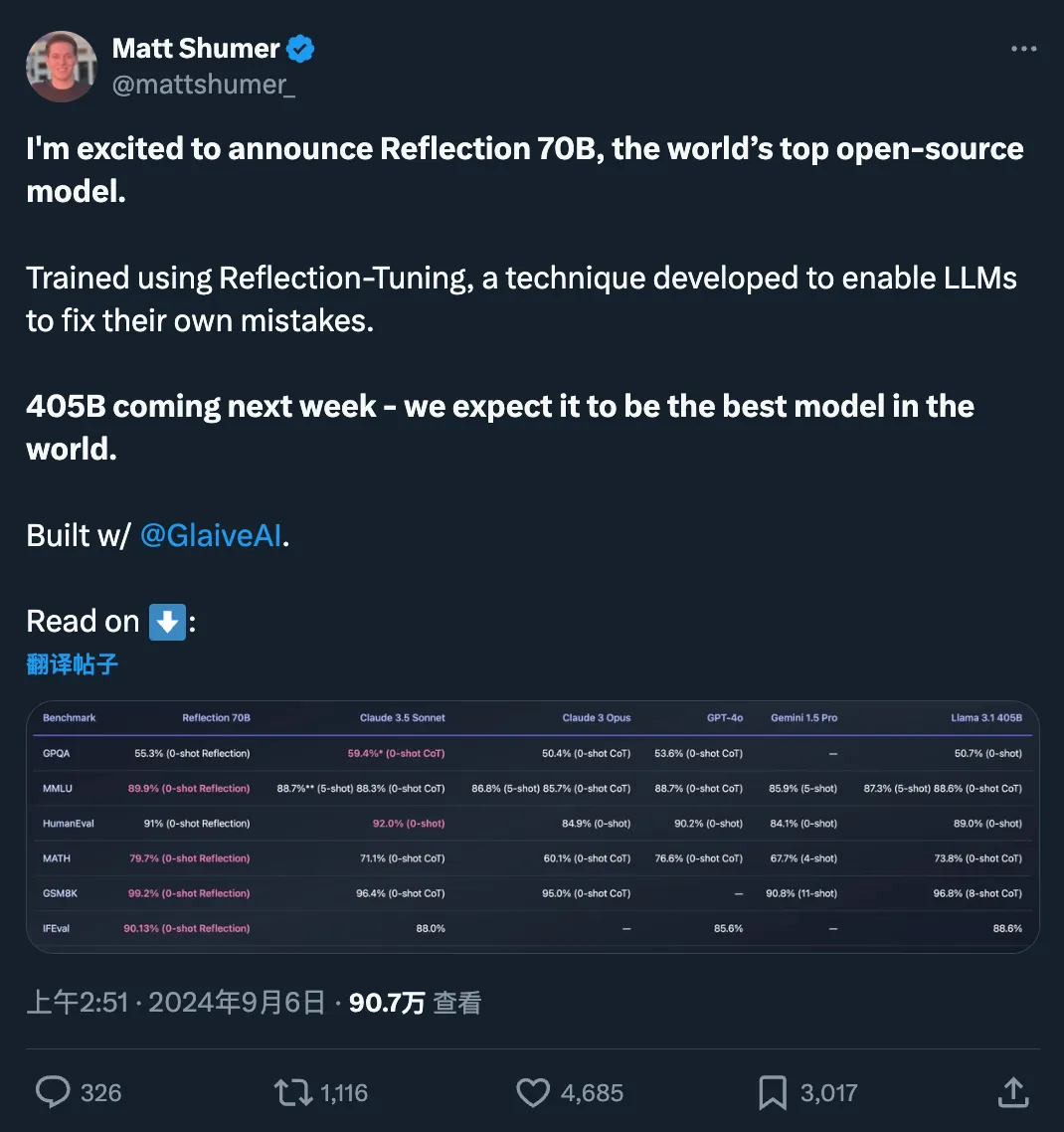

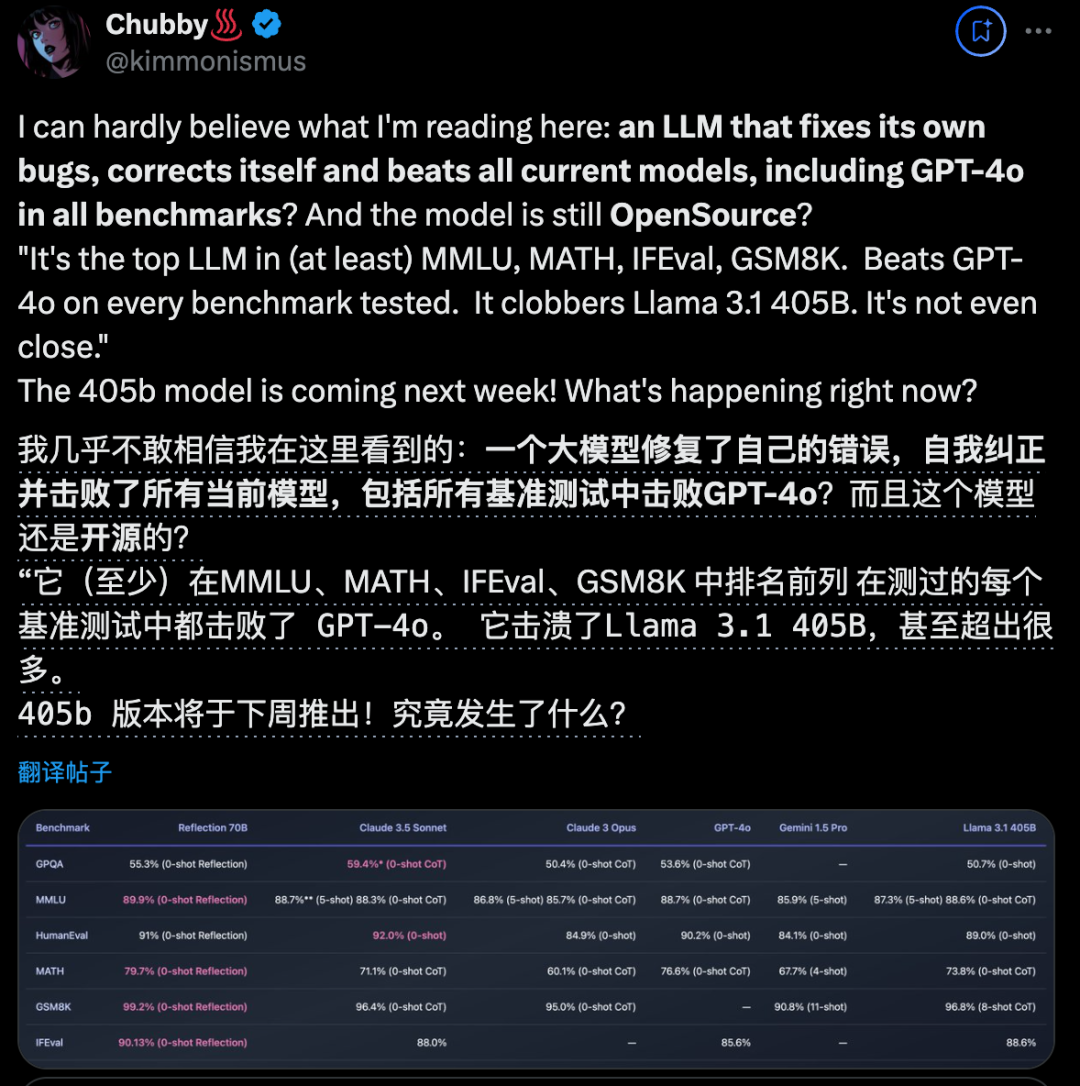

快速更迭的开源大模型领域,又出现了新王:Reflection 70B。 横扫 MMLU、MATH、IFEval、GSM8K,在每项基准测试上都超过了 GPT-4o,还击败了 405B 的 Llama 3.1。 这个新模型 Reflection 70B,来自 AI 写作初创公司 HyperWrite。

开源大模型王座突然易主,居然来自一家小创业团队,瞬间引爆业界。新模型名为Reflection 70B,使用一种全新训练技术,让AI学会在推理过程中纠正自己的错误和幻觉。

大模型做奥赛题游刃有余,简单的数数却屡屡翻车的原因找到了。

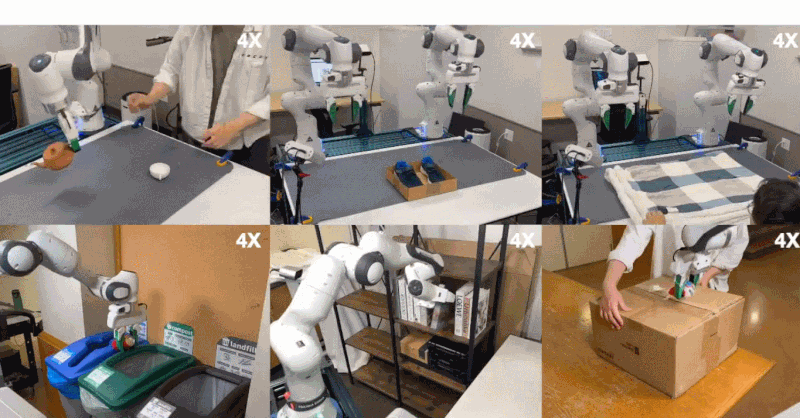

视觉与机器人学习的深度融合。

还能玩纸牌游戏。

智谱AI发布新视觉模型,看得懂视频,也看得透网页源代码。

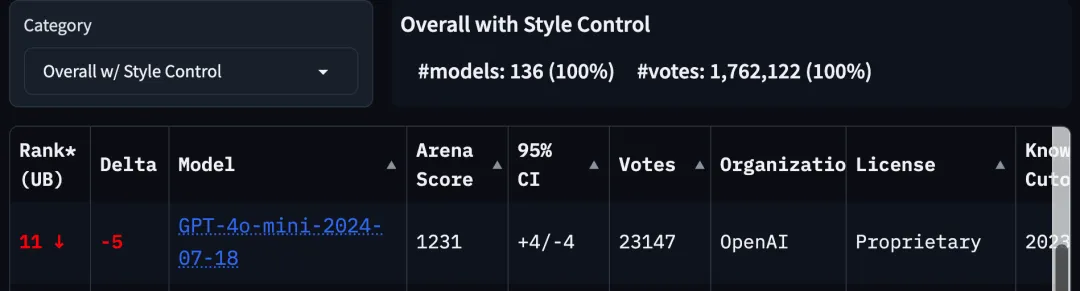

大模型竞技场规则更新,GPT-4o mini排名立刻雪崩,跌出前10。