为什么要纯C语言手搓GPT-2,Karpathy回应网友质疑

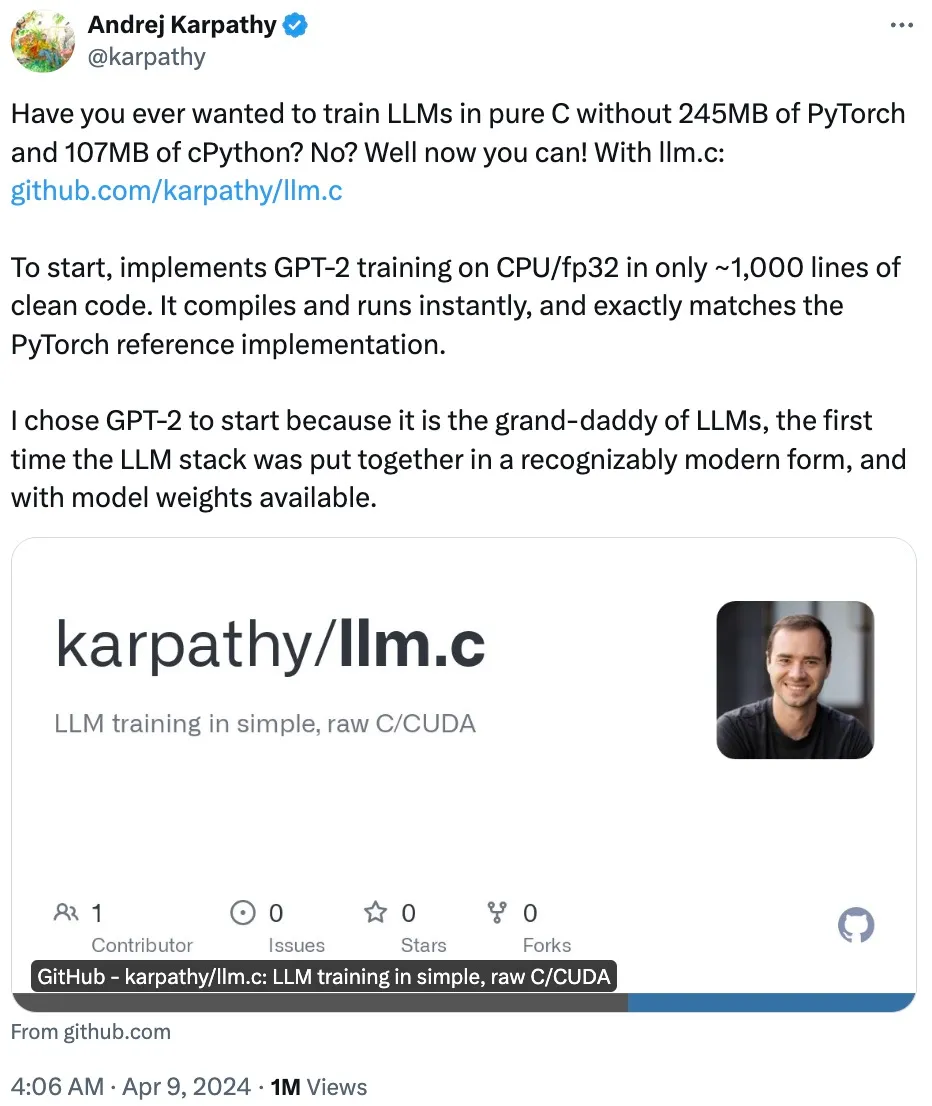

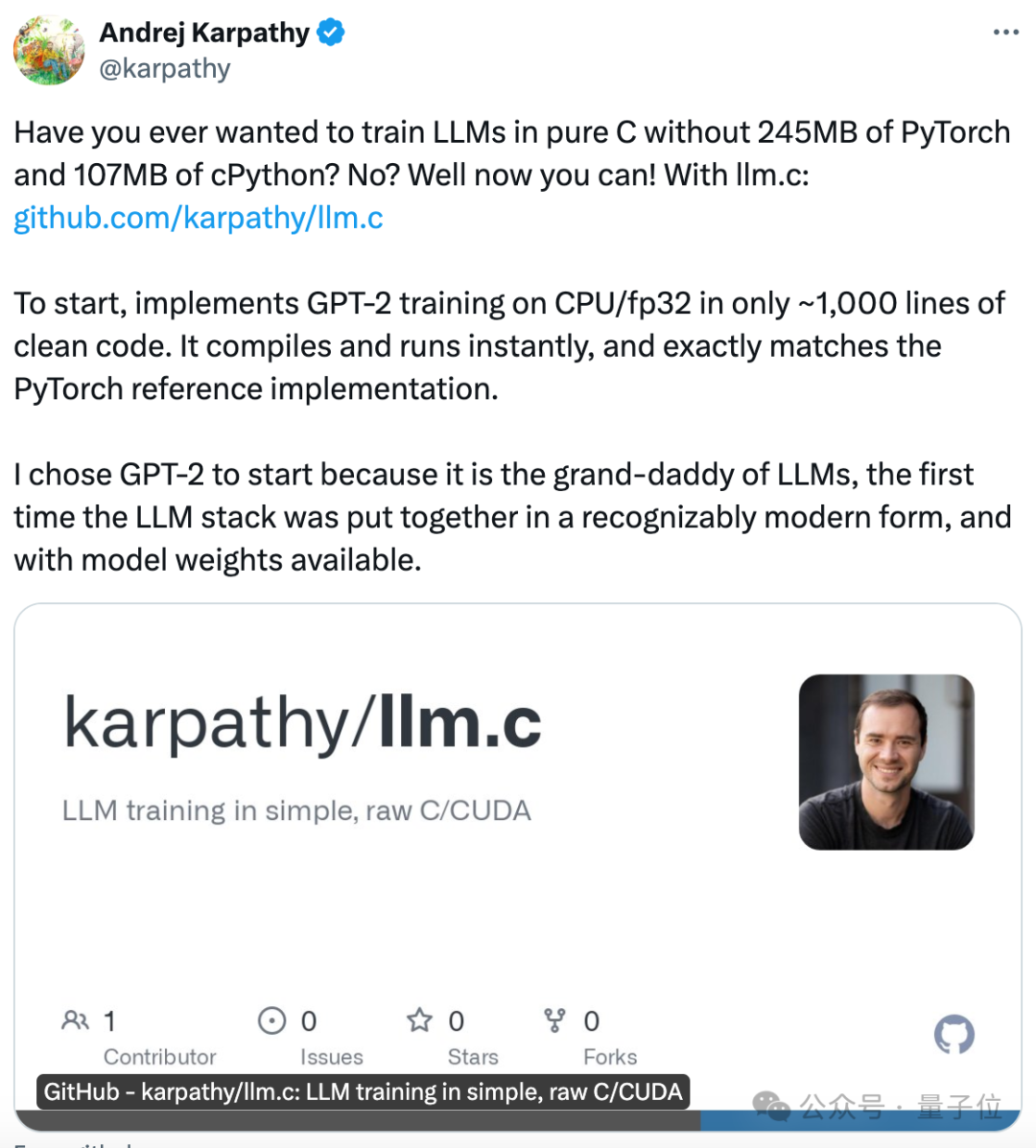

为什么要纯C语言手搓GPT-2,Karpathy回应网友质疑一个仅用 1000 行代码即可在 CPU/fp32 上实现 GPT-2 训练的项目「llm.c」

一个仅用 1000 行代码即可在 CPU/fp32 上实现 GPT-2 训练的项目「llm.c」

许多创新公司正在创建人工智能工具来实现这些结果。今天和大家分享 10 款实用的教育 AI 工具

AIGC新应用,到底将重塑怎样的一个新世界? 现在,只需一天的时间,你就能感受到它们正在引领的科技新范式。

一句话Siri就能帮忙打开美团外卖下订单的日子看来不远啦!

趁着谷歌开大会,OpenAI果然又来定向狙击了。 谷歌前脚刚官宣一系列更新,OpenAI立马跟着抛出重大消息—— GPT-4 Turbo迎来「重大升级」!

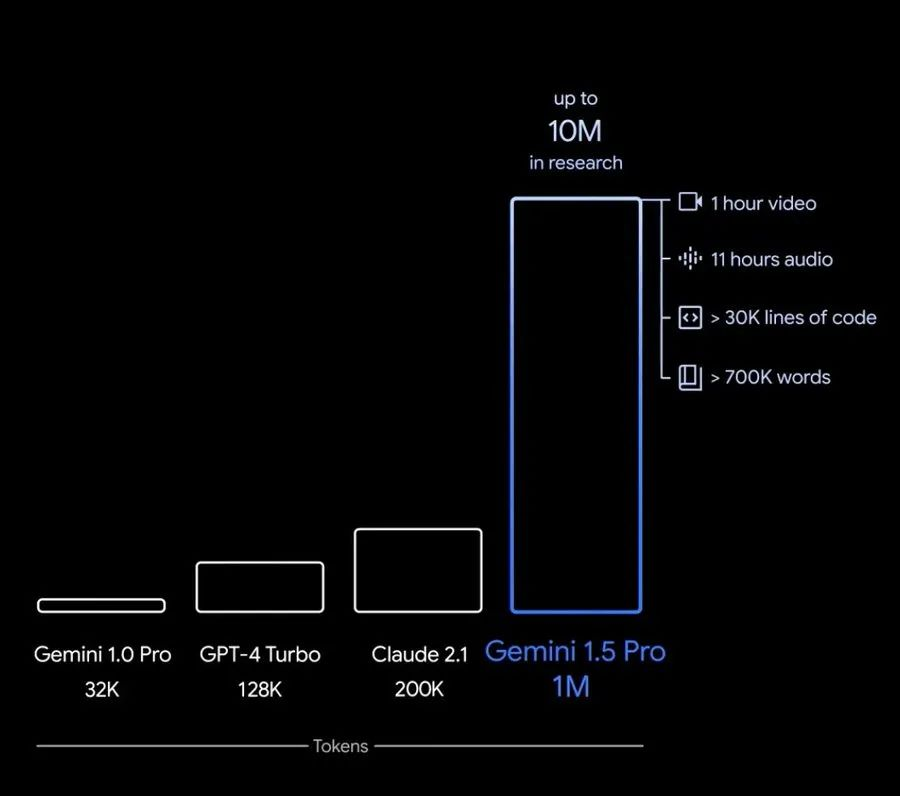

不得不感叹,国外AI大模型的迭代速度,就像是坐火箭????。

GPT-4问世一年后,全世界已经到处都是GPT-4级别的大模型了。 尤其是最近几个月,这些模型以越发密集的频率现身

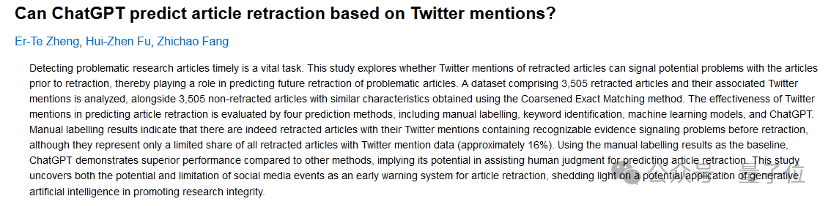

来自人大与浙大学者团队的研究者们把涉及数千篇SCI/SSCI的期刊论文的10000多条推文喂给了GPT-4,让它根据推文回答“这篇论文是否有可能被撤稿”,然后和人类预测的结果相比较。

纯C语言训练GPT,1000行代码搞定!,不用现成的深度学习框架,纯手搓。 发布仅几个小时,已经揽星2.3k。

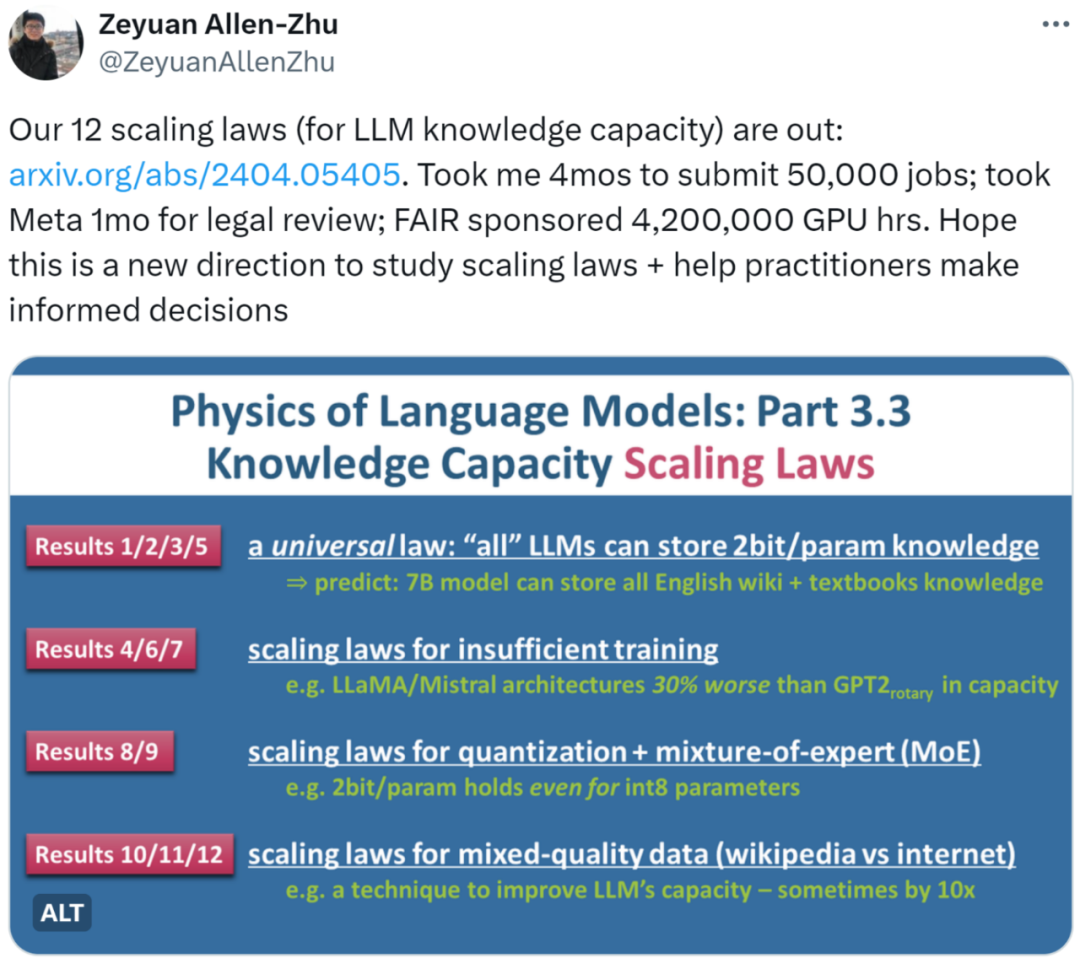

近日,朱泽园 (Meta AI) 和李远志 (MBZUAI) 的最新研究《语言模型物理学 Part 3.3:知识的 Scaling Laws》用海量实验(50,000 条任务,总计 4,200,000 GPU 小时)总结了 12 条定律,为 LLM 在不同条件下的知识容量提供了较为精确的计量方法。