让GPU不再摸鱼!清华蚂蚁联合开源首个全异步RL,一夜击穿14B SOTA

让GPU不再摸鱼!清华蚂蚁联合开源首个全异步RL,一夜击穿14B SOTA清华与蚂蚁联合开源AReaL-boba²,实现全异步强化学习训练系统,有效解耦模型生成与训练流程,GPU利用率大幅提升。14B模型在多个代码基准测试中达到SOTA,性能接近235B模型。异步RL训练上大分!

清华与蚂蚁联合开源AReaL-boba²,实现全异步强化学习训练系统,有效解耦模型生成与训练流程,GPU利用率大幅提升。14B模型在多个代码基准测试中达到SOTA,性能接近235B模型。异步RL训练上大分!

hi 家人们,端午假期开心嘛! 除了休息工作,这次假期,我还和一位好久不见的老朋友约了一个聊天局。

现在,请大家一起数一下“1”、“2”。OK,短短2秒钟时间,一个准万亿MoE大模型就已经吃透如何解一道高等数学大题了!而且啊,这个大模型还是不用GPU来训练,全流程都是大写的“国产”的那种。

2025年,AMD将推出全新的GPU路线图,瞄准两个竞争激烈的领域:游戏和AI。该公司正在推出一系列重大进展,从简化的产品命名和激进的定价,到尖端的架构和深度AI集成,这表明它决心在多个市场上缩小与英伟达的差距。

斯坦福Hazy实验室推出新一代低延迟推理引擎「Megakernel」,将Llama-1B模型前向传播完整融合进单一GPU内核,实现推理时间低于1毫秒。在B200上每次推理仅需680微秒,比vLLM快3.5倍。

英伟达赚麻了!AI推理全面爆发,芯片巨头2026财年Q1营收达441亿美元,净利润飙升至188亿美元,双双远超市场预期!

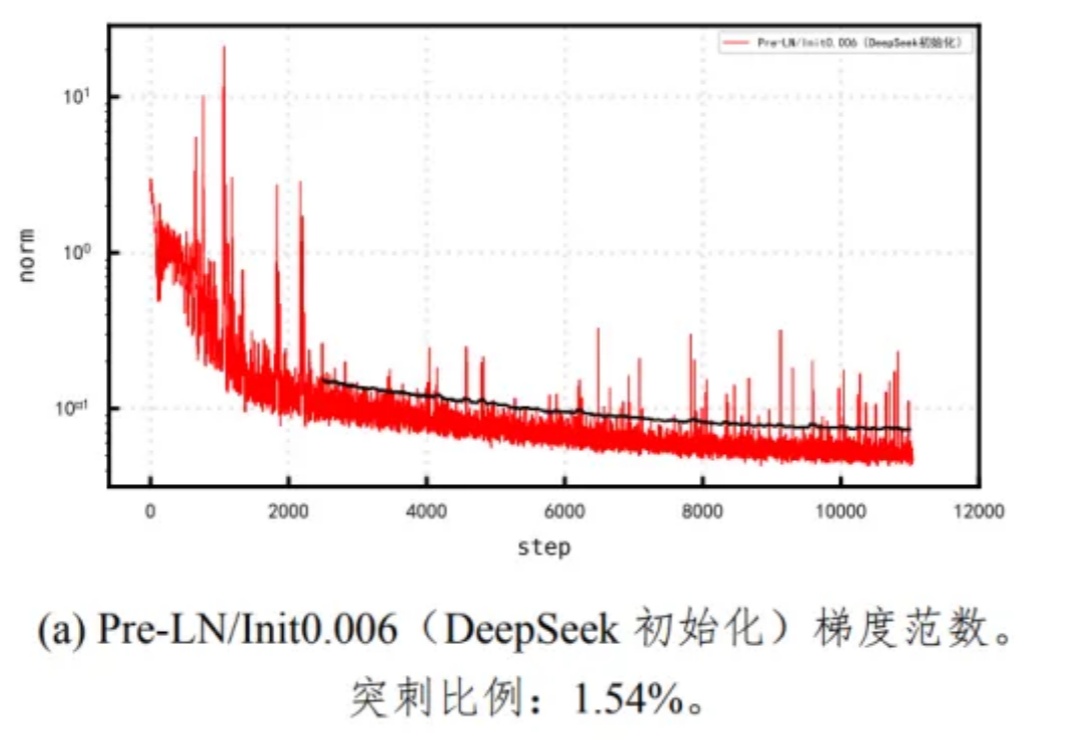

Pangu Ultra MoE 是一个全流程在昇腾 NPU 上训练的准万亿 MoE 模型,此前发布了英文技术报告[1]。最近华为盘古团队发布了 Pangu Ultra MoE 模型架构与训练方法的中文技术报告,进一步披露了这个模型的细节。

你有没有遇到过这样的算力困境:买了 GPU,用不了几次就闲置烧钱,偶尔想用的时候却一卡难求?

Meta推出KernelLLM,这个基于Llama 3.1微调的8B模型,竟能将PyTorch代码自动转换为高效Triton GPU内核。实测数据显示,它的单次推理性能超越GPT-4o和DeepSeek V3,多次生成时得分飙升。

AI无处不在——从聊天机器人、推荐引擎到语音助手和ChatGPT或谷歌Gemini等工具。但在所有这些智能技术的背后,有一样东西经常被忽视:使这一切成为可能的硬件。