深度|如何最大化 GPU 利用效率,让 ROI 最大化?

深度|如何最大化 GPU 利用效率,让 ROI 最大化?前不久在人工智能的帮助下,两位科学家获得了诺贝尔物理学奖。可以说人工智能已经在很多领域被广泛应用了。随着大语言模型(LLM)和深度学习的广泛应用,GPU 也已成为机器学习工程师和研究人员最重要的计算资源之一。

前不久在人工智能的帮助下,两位科学家获得了诺贝尔物理学奖。可以说人工智能已经在很多领域被广泛应用了。随着大语言模型(LLM)和深度学习的广泛应用,GPU 也已成为机器学习工程师和研究人员最重要的计算资源之一。

科技巨头如亚马逊、微软、谷歌和Meta每年在AI相关的投资上花费300亿至600亿美元。

就在昨天,微信群里出现了一个消息,迅速攀升至热榜第二名:一名字节实习生攻击GPU集群。

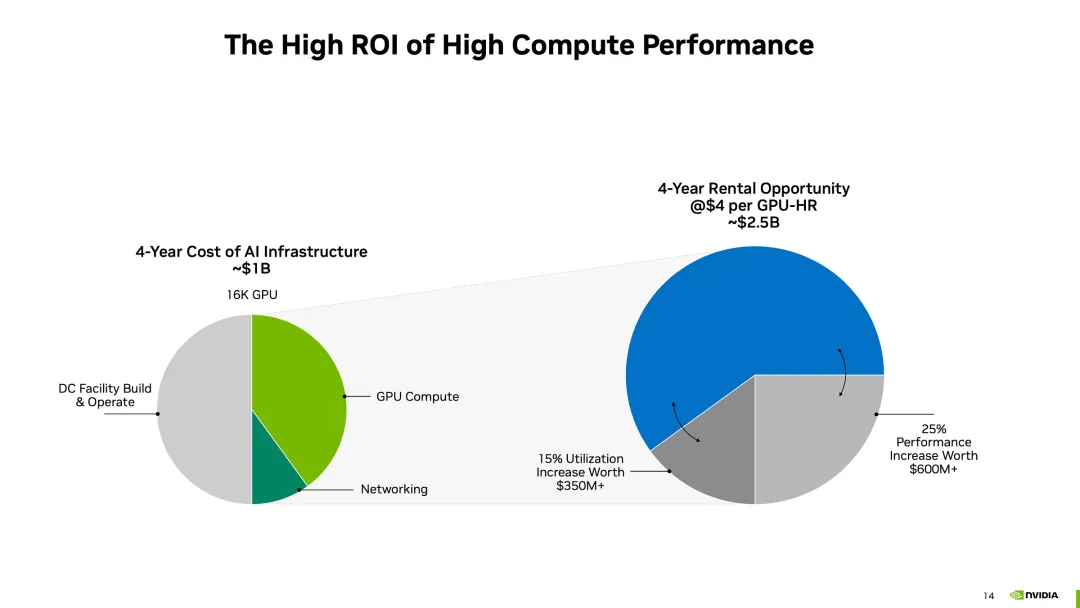

红杉资本的报告曾指出,AI产业的年产值超过6000亿美元,才够支付数据中心、加速GPU卡等AI基础设施费用。而现在一种普遍说法认为,基础模型训练的资本支出是“历史上贬值最快的资产”,但关于GPU基础设施支出的判定仍未出炉,GPU土豪战争仍在进行。

「算力」堪称是AI时代最大的痛。在国外,OpenAI因为微软造GPU集群的速度太慢而算力告急。在国内,企业则面临着「模型算力太多元、产业生态太分散」这一难题。不过,最近新诞生的一款「AI神器」,令人眼前一亮。

Crusoe数据中心预计明年投入使用,2026年电力容量达到1吉瓦。 智东西10月16日消息,10月15日,数据中心公司Crusoe签署了价值34亿美元的合资协议。

H100租赁价格下跌,真的能和“GPU泡沫破灭”画上等号吗? 一则有关“2美元/小时出租H100:GPU泡沫破灭前夜”的报道引发国内市场高度关注。

GPU计算驱动AI。

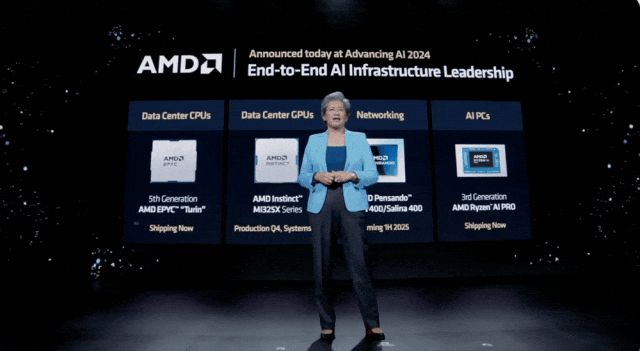

未来的大模型,或许都是 A 卡来算的? 从 PC 端到服务器,AMD 一次发布就完成了对 AI 计算的全覆盖。 今天凌晨,AMD 首席执行官苏姿丰(Lisa Su)在旧金山举行的 Advancing AI 2024 活动上发布了全新一代 Ryzen CPU、Instinct AI 计算卡、EPYC AI 芯片等一系列产品。

猛,实在是猛!就在今日,老牌芯片巨头AMD交出了一份令人印象深刻的AI答卷。