仅用4块GPU、不到3天训练出「开源版GPT-4o」,这是国内团队最新研究

仅用4块GPU、不到3天训练出「开源版GPT-4o」,这是国内团队最新研究LLaMA-Omni能够接收语音指令,同步生成文本和语音响应,响应延迟低至 226ms,低于 GPT-4o 的平均音频响应延迟 320ms。

LLaMA-Omni能够接收语音指令,同步生成文本和语音响应,响应延迟低至 226ms,低于 GPT-4o 的平均音频响应延迟 320ms。

有经销商称已无法下单英伟达H20芯片,有终端厂商称部分国内经销商不再接H20订单。H20或将遭停售的传闻早已在业内传开,其命运走向受关注。业内多方反馈称,H20年内到货已超出全年预期。

活久见,英特尔要被高通收购了?如果成功收购,全球半导体行业将掀起滔天巨浪。而这桩半导体行业有史以来最大规模并购案,也将改变全球科技产业格局。GPU崛起,CPU成受害者。网友直呼:倒反天罡!

群雄逐鹿AI计算。

既然要扬长避短,选择自然也就只剩下了一个。

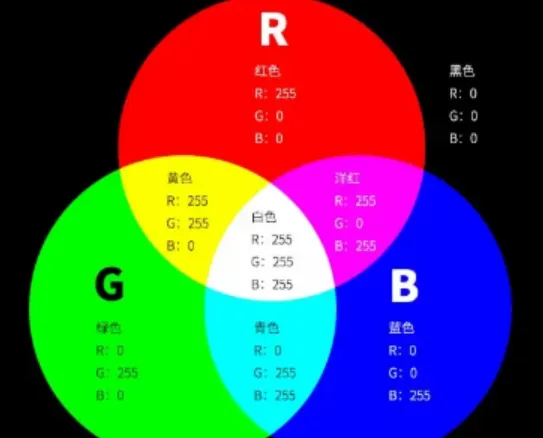

《2024 年全球人工智能趋势报告》:GPU、数据架构依然是巨大挑战

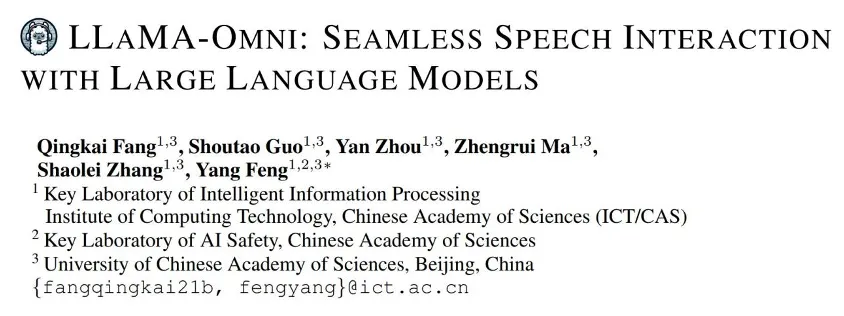

最近一直在想一个问题。为什么我们的图像 AI 模型那么耗算力?比如,现在多模态图文理解 AI 模型本地化部署一个节点,动不动就需要十几个 G 的显存资源。

前些天,OpenAI 发布了 ο1 系列模型,它那「超越博士水平的」强大推理性能预示着其必将在人们的生产生活中大有作为。但它的使用成本也很高,以至于 OpenAI 不得不限制每位用户的使用量:每位用户每周仅能给 o1-preview 发送 30 条消息,给 o1-mini 发送 50 条消息。

哪里有最多GPU?哪里又是GPU荒漠?

今年毫无疑问是AI应用层的创业元年。