老黄一口气解密三代GPU!粉碎摩尔定律打造AI帝国,量产Blackwell解决ChatGPT全球耗电难题

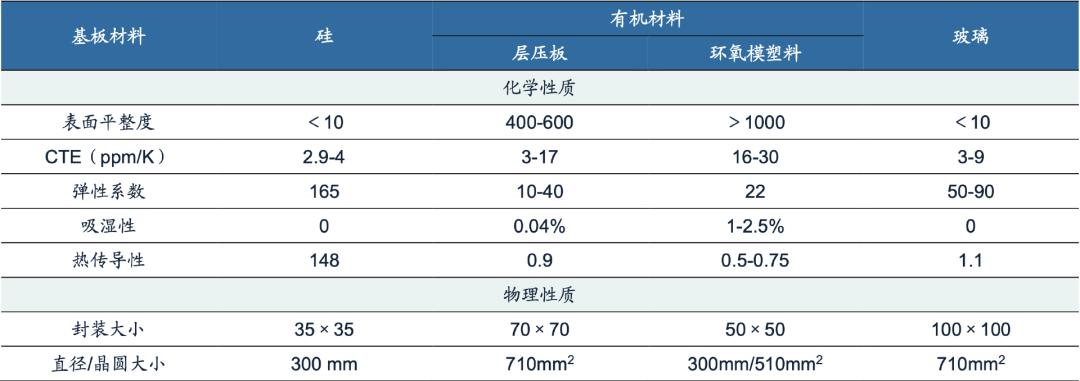

老黄一口气解密三代GPU!粉碎摩尔定律打造AI帝国,量产Blackwell解决ChatGPT全球耗电难题刚刚,老黄又高调向全世界秀了一把:已经量产的Blackwell,8年内将把1.8万亿参数GPT-4的训练能耗狂砍到1/350;英伟达惊人的产品迭代,直接原地冲破摩尔定律;Blackwell的后三代路线图,也一口气被放出。

刚刚,老黄又高调向全世界秀了一把:已经量产的Blackwell,8年内将把1.8万亿参数GPT-4的训练能耗狂砍到1/350;英伟达惊人的产品迭代,直接原地冲破摩尔定律;Blackwell的后三代路线图,也一口气被放出。

从谷歌离职一年之际,「人工智能教父」Hinton接受了采访。半退休的Hinton向我们讲述了时光积累下来的智慧,以及那些年和徒弟Ilya在一起的日子。

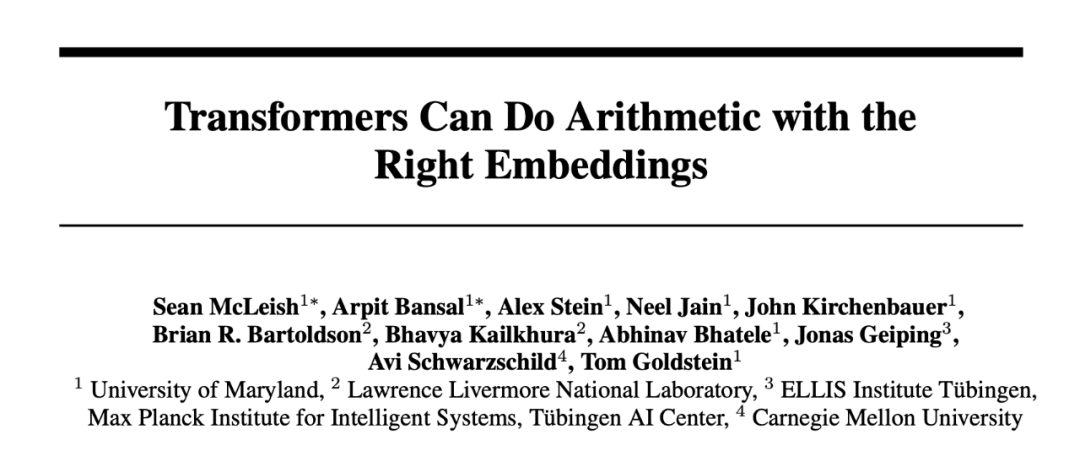

乘法和排序也有效。

这一把火,似乎烧得有点太猛烈。

离普通人用上还要再等等。

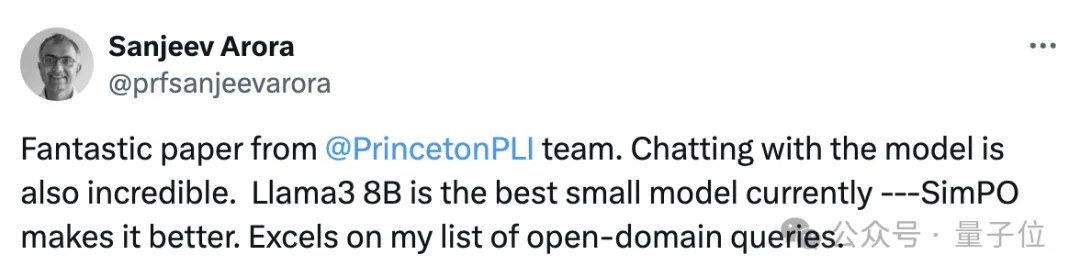

比斯坦福DPO(直接偏好优化)更简单的RLHF平替来了,来自陈丹琦团队。 该方式在多项测试中性能都远超DPO,还能让8B模型战胜Claude 3的超大杯Opus。 而且与DPO相比,训练时间和GPU消耗也都大幅减少。

最近,许久没有新动向的马斯克放出了大消息——他旗下的人工智能初创公司xAI将投入巨资建造一个超算中心,以保证Grok 2及之后版本的训练。这个「超级计算工厂」预计于2025年秋季建成,规模将达到目前最大GPU集群的四倍。

最近几年,随着大语言模型的飞速发展与迭代,科技巨头们都竞相投入巨额财力打造超级计算机(或大规模 GPU 集群)。他们认为,更强大的计算能力是实现更强大 AI 的关键。

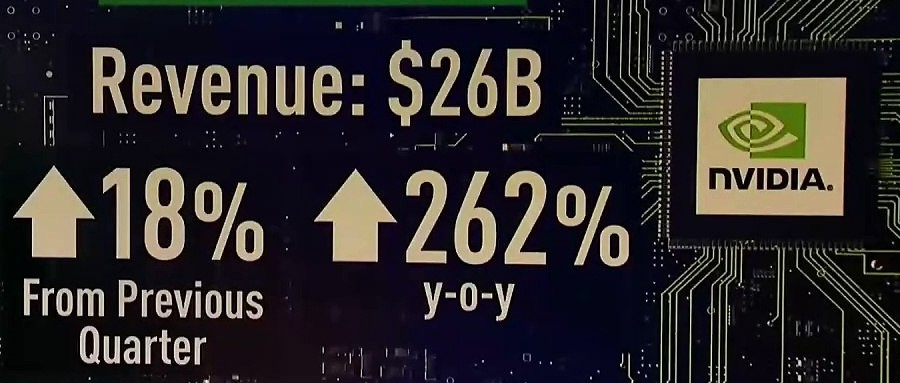

英伟达表现再超预期,但竞争和市场大环境的变化或给英伟达未来增长带来隐忧。

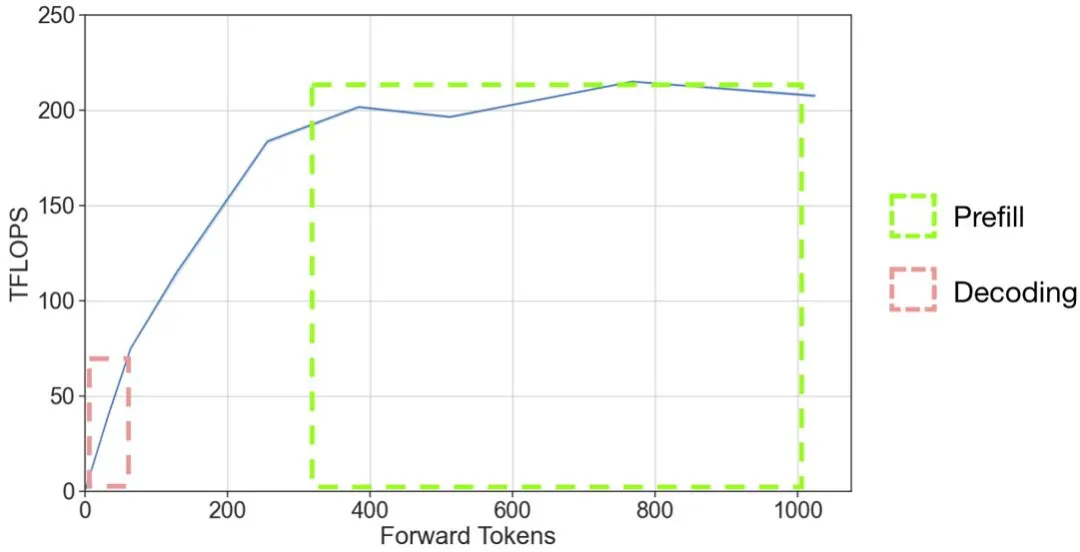

以 OpenAI 的 GPT 系列模型为代表的大语言模型(LLM)掀起了新一轮 AI 应用浪潮,但是 LLM 推理的高昂成本一直困扰着业务团队。