全是套路!英伟达千亿美元投OpenAI,奥特曼拿钱买卡还让甲骨文赚差价

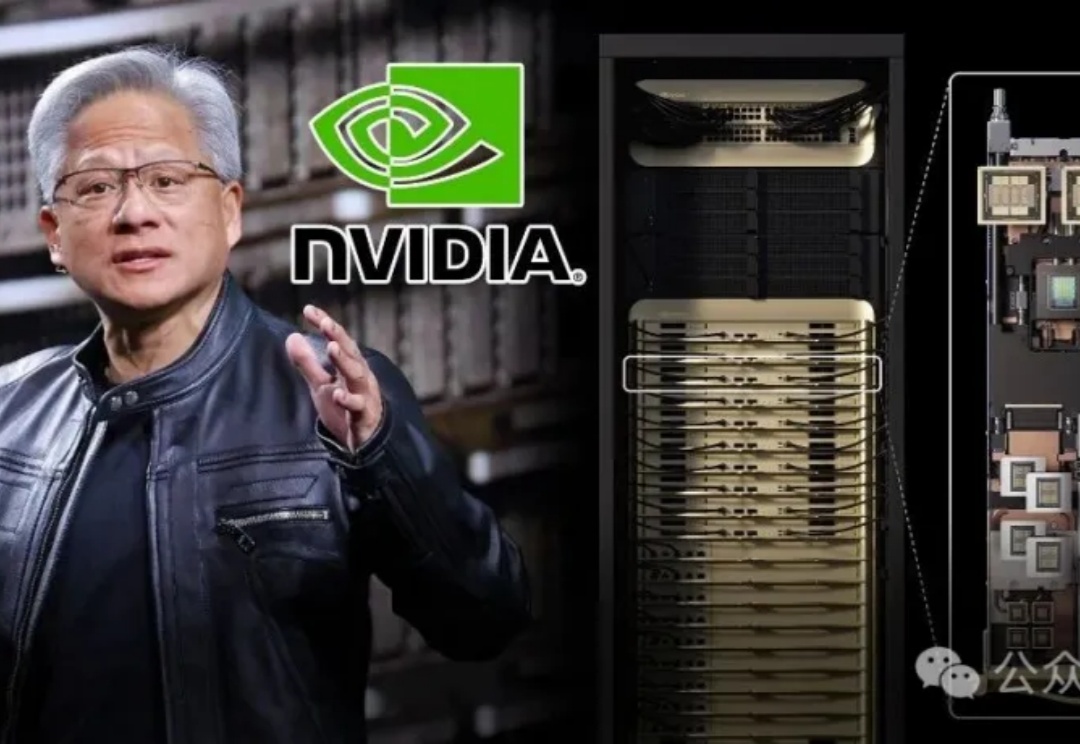

全是套路!英伟达千亿美元投OpenAI,奥特曼拿钱买卡还让甲骨文赚差价最新消息,英伟达计划向OpenAI投资最高1000亿美元,OpenAI则要用这笔钱构建至少10GW的AI数据中心,全用英伟达的系统。10GW,相当于400-500万个GPU了,并且,黄仁勋8月份曾表示,建成1GW的数据中心的成本大约在500-600亿美元。

最新消息,英伟达计划向OpenAI投资最高1000亿美元,OpenAI则要用这笔钱构建至少10GW的AI数据中心,全用英伟达的系统。10GW,相当于400-500万个GPU了,并且,黄仁勋8月份曾表示,建成1GW的数据中心的成本大约在500-600亿美元。

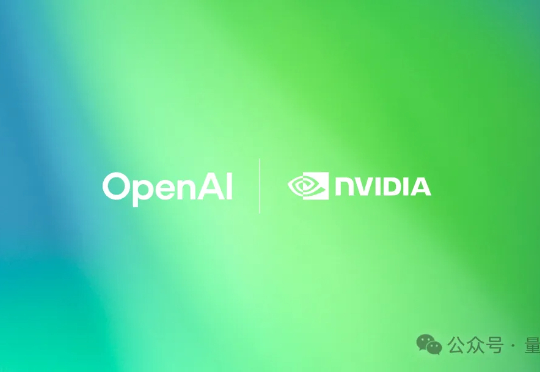

创智、基流、智谱、联通、北航、清华、东南联合打造了高效率、高可靠、高可视的 GPU 集合通信库 VCCL(Venus Collective Communication Library),VCCL 已部署于多个生产环境集群中。

刚刚,芯片圈大地震,英伟达将斥资50亿美元入股英特尔,一举成为大股东!英伟达出钱,英特尔出力!英特尔将为英伟达定制AI数据中心所需的x86 CPU,未来还将推出集成英伟达GPU的系统级芯片。

马斯克“巨硬计划”(MACROHARD)新动作曝光: 6个月从0建起算力集群,已完成200MW供电规模,足以支持11万台英伟达GB200 GPU NVL72。仅用6个时间,完成了OpenAI和甲骨文等合作花费15个月完成的工作,再次创造纪录。

谷歌TPU团队原班人马组建,英伟达挑战者、AI芯片初创企业Groq又获融资。超出此前的6亿预期,此次融资高达7.5亿美元(约53亿人民币),Groq现估值69亿美元(约490亿人民币)。

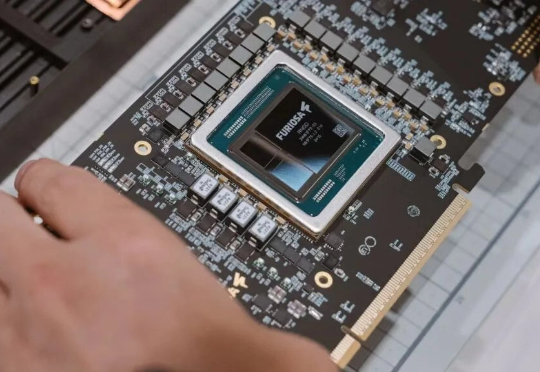

总部位于首尔的芯片初创公司FuriosaAI 正筹备进行一轮可能超过 3 亿美元的 IPO 前融资,该公司致力于挑战英伟达的市场地位。

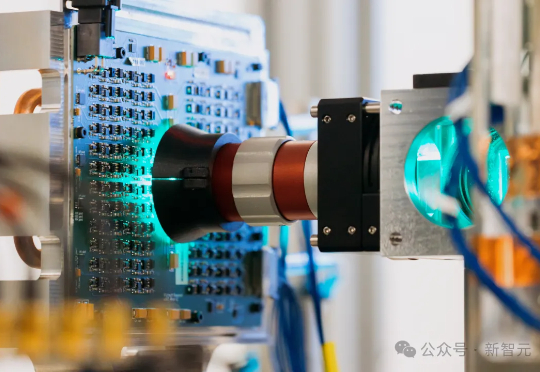

芯片再快,也快不过光!微软研究院在剑桥拼出了一台模拟光学计算机:用手机摄像头、Micro LED和透镜拼成,却在实验里跑出了速度快100倍、能效高100倍的潜力。这一成果如今登上Nature,或许,算力格局将被改写。

超长序列推理时的巨大开销如何降低?

昨天,英伟达重磅发布了专为海量上下文AI打造的CUDA GPU——Rubin CPX,将大模型一次性推理带入「百万Token时代」。NVIDIA创始人兼CEO黄仁勋表示,Vera Rubin平台将再次推动AI计算的前沿,不仅带来下一代Rubin GPU,也将开创一个CPX的全新处理器类别。

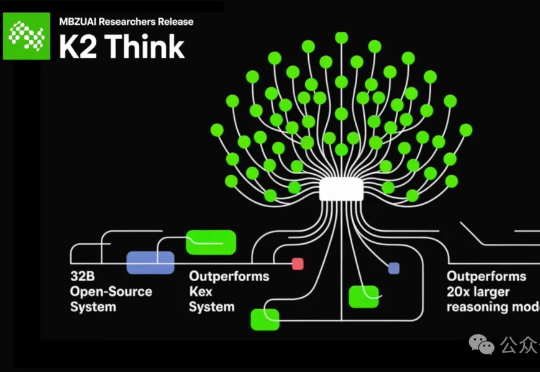

全球最快的开源大模型来了——速度达到了每秒2000个tokens! 虽然只有320亿参数(32B),吞吐量却是超过典型GPU部署的10倍以上的那种。它就是由阿联酋的穆罕默德·本·扎耶德人工智能大学(MBZUAI)和初创公司G42 AI合作推出的K2 Think。