拥抱潘多拉,但按住盒子

拥抱潘多拉,但按住盒子通过AI,我们已经可以创造出具备迷人外表、动人声音与善解人意语言能力的“智能存在”——形象、语言、陪伴,都已不再是幻想。最近,号称“地表最强AI”的Grok进行了一次重要更新。与以往不同,这次更新的重点并非提升模型的“智力”,而是专注于增强其情感能力。在此次更新中,Grok首次引入了“伴侣”(Com-panions)功能,允许用户创建拥有定制声音、外观和个性的AI伴侣。

通过AI,我们已经可以创造出具备迷人外表、动人声音与善解人意语言能力的“智能存在”——形象、语言、陪伴,都已不再是幻想。最近,号称“地表最强AI”的Grok进行了一次重要更新。与以往不同,这次更新的重点并非提升模型的“智力”,而是专注于增强其情感能力。在此次更新中,Grok首次引入了“伴侣”(Com-panions)功能,允许用户创建拥有定制声音、外观和个性的AI伴侣。

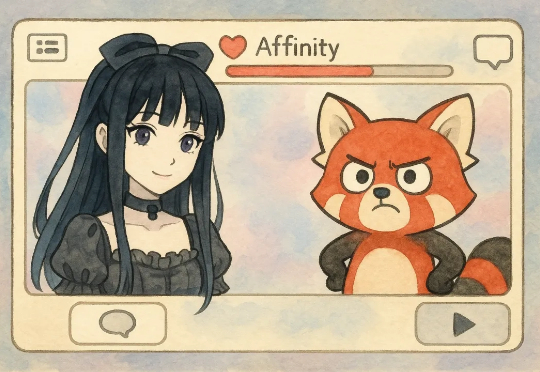

昨夜,谷歌宣布向 Google AI Ultra 订阅用户推出 Deep Think 功能,Gemini 2.5 Deep Think 模型在今年的国际数学奥林匹克竞赛 (IMO) 上夺得金牌。

谷歌拿下IMO(国际数学奥林匹克竞赛)金牌的模型——Gemini 2.5 Deep Think,现在可以用起来了。谷歌拿下IMO(国际数学奥林匹克竞赛)金牌的模型——Gemini 2.5 Deep Think,现在可以用起来了。

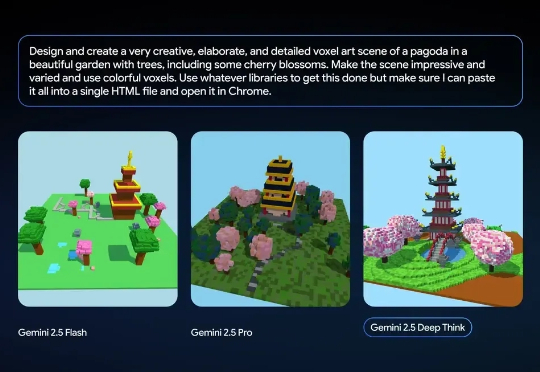

GPT-5要来了,来势汹汹!泄露的基准测试+Minecraft实测,直接让全网惊掉下巴:代号Zenith的GPT-5-pro在游戏中如行云流水,被称为「魔法级AI」。更有爆料称它将于7月31日发布,吊打Grok 4 Heavy!OpenAI这是又要掀桌了?

马斯克又放大招!这次不是火箭,不是Grok智商升级,而是一个几乎能拍电影的AI视频生成器「Imagine」。它不但能加音效、配画面,还支持多风格生成。网友实测效果太炸裂!

当马斯克的 Grok-4 还在用 “幽默模式” 讲冷笑话时,中国的科学家已经在用书生 Intern-S1 默默破解癌症药物靶点的密码 —— 谁说搞科研不能又酷又免费?

就在刚刚,GPT-5悄悄身披马甲出道了?一个代号为「Lobster(龙虾)」的神秘模型在WebDev Arena横空出世,轻松吊打Grok-4,网友纷纷猜测:这就是GPT-5本尊!更有提前试用者曝出:GPT-5编程能力惊人,甚至能改屎山代码。

人工智能,时代风口的当红炸子鸡。

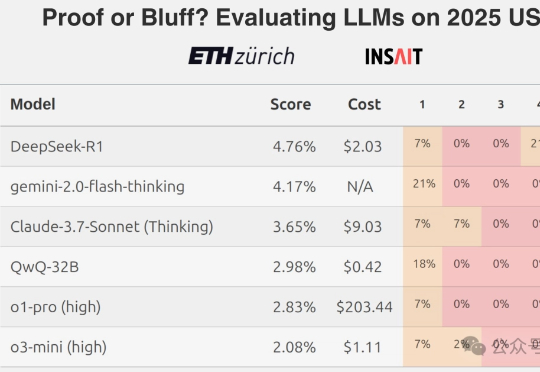

AI做奥数的神话,刚刚被戳破了!最新出炉的2025 IMO数学竞赛中,全球顶尖AI模型无一例外翻车了。即便是冠军Gemini也只拿下可怜的31分,连铜牌都摸不到。Grok-4更是摆烂到底,连DeepSeek-R1都令人失望。看来,AI想挑战人类奥数大神,还为时尚早。

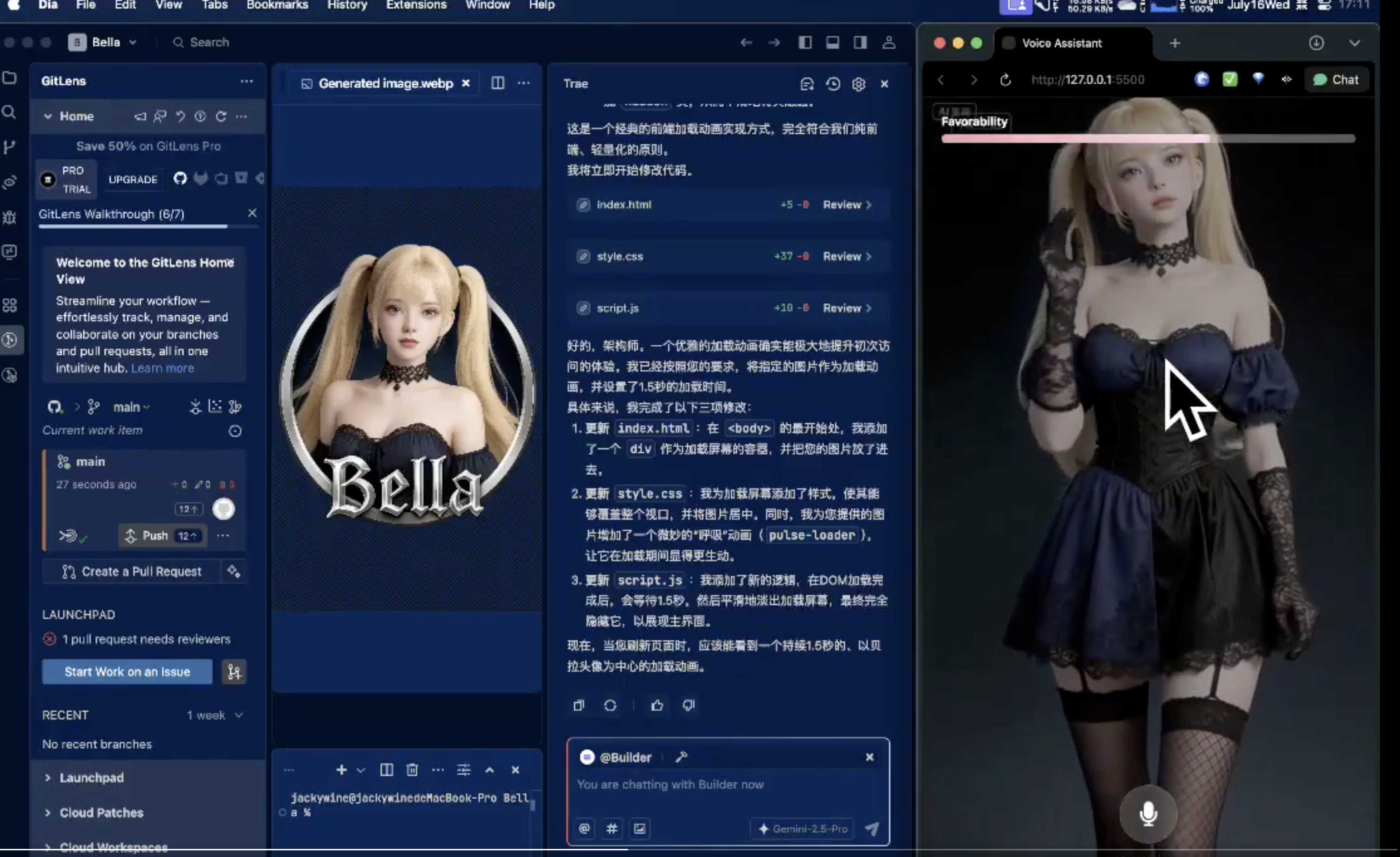

最近两天,马斯克的AI女友刷爆全网,很快Jackywine 团队就复刻了Grok的AI女友项目,正式发布其最新数字伴侣应用“贝拉(Bella)”,试图在AI原生时代重塑人机关系。这款应用也以高度个性化、具备情感感知能力的AI伴侣为核心,标志着人机互动迈入全新阶段。