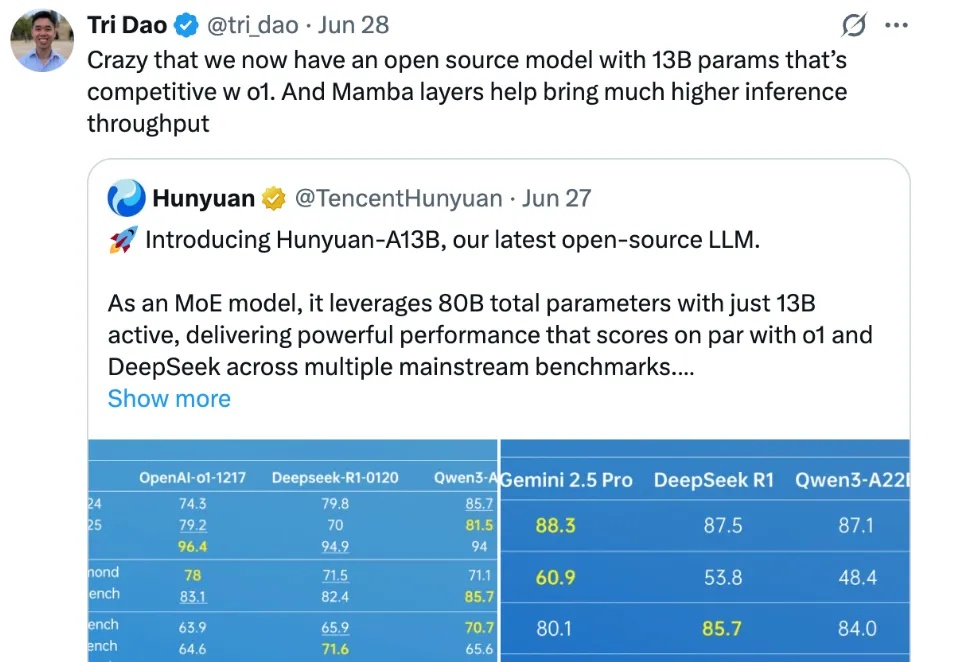

腾讯混元A13B用130亿参数达到千亿级效果,Flash Attention作者点赞

腾讯混元A13B用130亿参数达到千亿级效果,Flash Attention作者点赞腾讯混元,在开源社区打出名气了。

来自主题: AI资讯

7483 点击 2025-07-15 12:01

腾讯混元,在开源社区打出名气了。

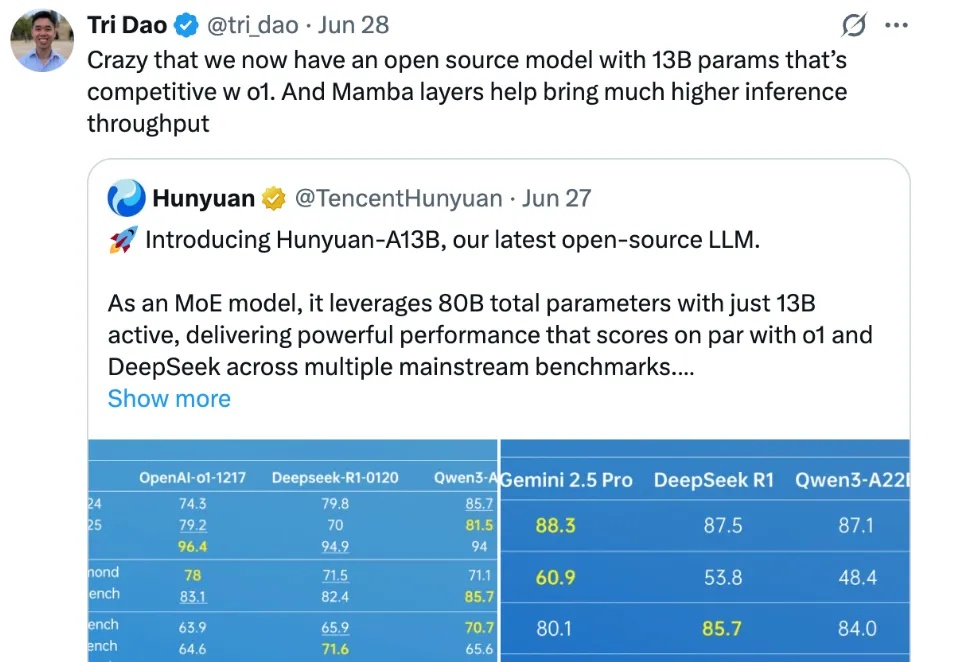

6 月 27 日,腾讯混元宣布开源首个混合推理 MoE 模型 Hunyuan-A13B,总参数 80B,激活参数仅 13B,效果比肩同等架构领先开源模型,但是推理速度更快,性价比更高。模型已经在 Github 和 Huggingface 等开源社区上线,同时模型 API 也在腾讯云官网正式上线,支持快速接入部署。