小红书等给AI图像检测上难度!数据集均通过人类感知“图灵测试” | ICLR 2025

小红书等给AI图像检测上难度!数据集均通过人类感知“图灵测试” | ICLR 2025AI生成内容已深度渗透至生活的方方面面,从艺术创作到设计领域,再到信息传播与版权保护,其影响力无处不在。

AI生成内容已深度渗透至生活的方方面面,从艺术创作到设计领域,再到信息传播与版权保护,其影响力无处不在。

过去一年,3D 生成技术迎来爆发式增长。在大场景生成领域,涌现出一批 “静态大场景生成” 工作,如 SemCity [1]、PDD [2]、XCube [3] 等。这些研究推动了 AI 利用扩散模型的强大学习能力来解构和创造物理世界的趋势。

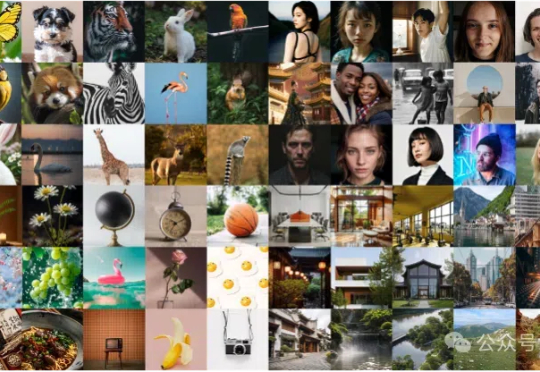

Transformer 架构在过去几年中通过注意力机制在多个领域(如计算机视觉、自然语言处理和长序列任务)中取得了非凡的成就。然而,其核心组件「自注意力机制」 的计算复杂度随输入 token 数量呈二次方增长,导致资源消耗巨大,难以扩展到更长的序列或更大的模型。

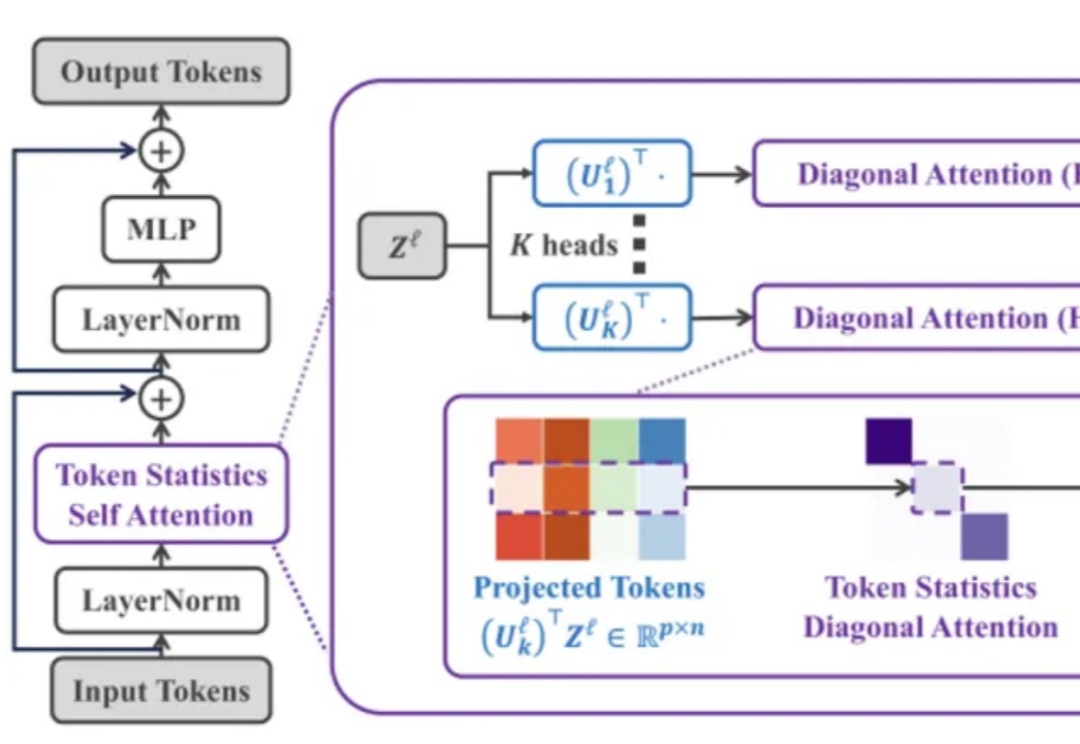

兔子通过两只耳朵可以准确感知捕食者的一举一动,造就了不同品种广泛分布在世界各地的生命奇迹;同样人也需要通过双耳沉浸式享受电影视听盛宴、判断驾驶环境和感知周围活动状态。

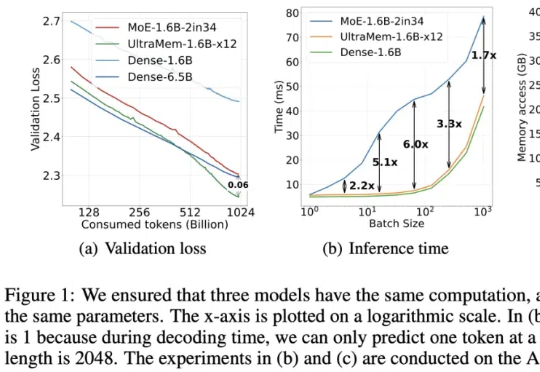

字节出了个全新架构,把推理成本给狠狠地打了下去!推理速度相比MoE架构提升2-6倍,推理成本最高可降低83%。

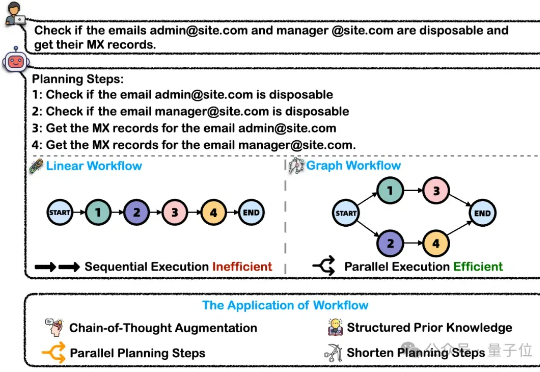

在处理这类复杂任务的过程中,大模型智能体将问题分解为可执行的工作流(Workflow)是关键的一步。然而,这一核心能力目前缺乏完善的评测基准。为解决上述问题,浙大通义联合发布WorfBench——一个涵盖多场景和复杂图结构工作流的统一基准,以及WorfEval——一套系统性评估协议,通过子序列和子图匹配算法精准量化大模型生成工作流的能力。

新一代 Kaldi 团队是由 Kaldi 之父、IEEE fellow、小米集团首席语音科学家 Daniel Povey 领衔的团队,专注于开源语音基础引擎研发,从神经网络声学编码器、损失函数、优化器和解码器等各方面重构语音技术链路,旨在提高智能语音任务的准确率和效率。

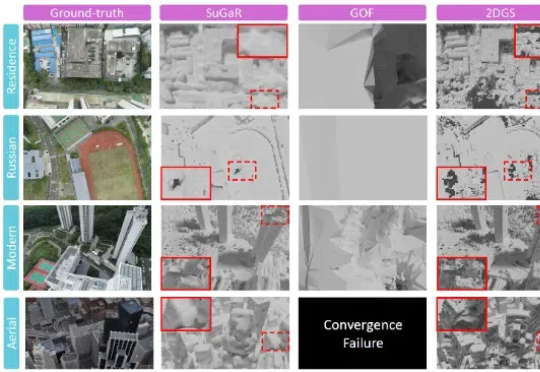

来自中科院自动化所的研究团队提出了用于大规模复杂三维场景的高效重建算法 CityGaussianV2,能够在快速实现训练和压缩的同时,得到精准的几何结构与逼真的实时渲染体验。该论文已接受于 ICLR`2025,其代码也已同步开源。

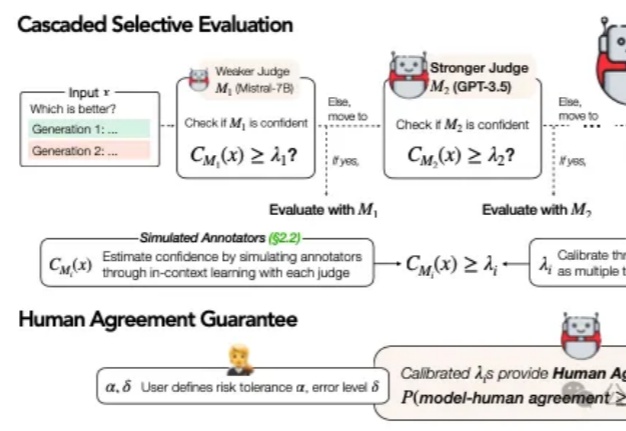

在当今AI技术迅猛发展的背景下,大语言模型(LLM)的评估问题已成为一个不可忽视的挑战。传统的做法是直接采用最强大的模型(如GPT-4)进行评估,这就像让最高法院的大法官直接处理所有交通违章案件一样,既不经济也不一定总能保证公正。

今天,ICLR 2025的discussion phase的ddl已经截止。回看过去14天的讨论过程,可太精彩了!