浙大校友重磅革新Transformer!多token注意力让LLM开挂,错误率归0

浙大校友重磅革新Transformer!多token注意力让LLM开挂,错误率归0简单的任务,传统的Transformer却错误率极高。Meta FAIR团队重磅推出多token注意力机制(MTA),精准捕捉复杂信息,带来模型性能飞升!

简单的任务,传统的Transformer却错误率极高。Meta FAIR团队重磅推出多token注意力机制(MTA),精准捕捉复杂信息,带来模型性能飞升!

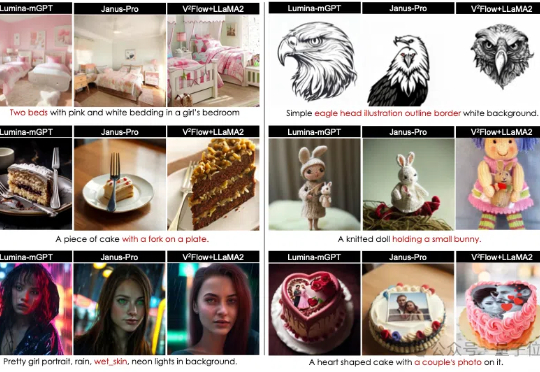

视觉Token可以与LLMs词表无缝对齐了!

随着人工智能和大语言模型(LLMs)的不断突破,如何将其优势赋能于现实世界中可实际部署的高效工具,成为了业界关注的焦点。

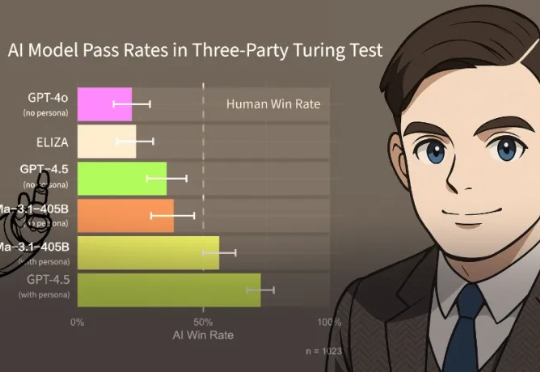

在三方图灵测试中,UCSD的研究人员评估了当前的AI模型,证明LLM已通过图灵测试。在测试中,同时与人及AI系统进行5分钟对话,然后判断哪位是「真人」。结果,AI竟然比「真人」还像人:

LLM正推动推荐系统革新,以用户表征为「软提示」的范式开辟了高效推荐新路径。在此趋势下,淘天团队发布了首个基于用户表征的个性化问答基准UQABench,系统评估了用户表征的提示效能。

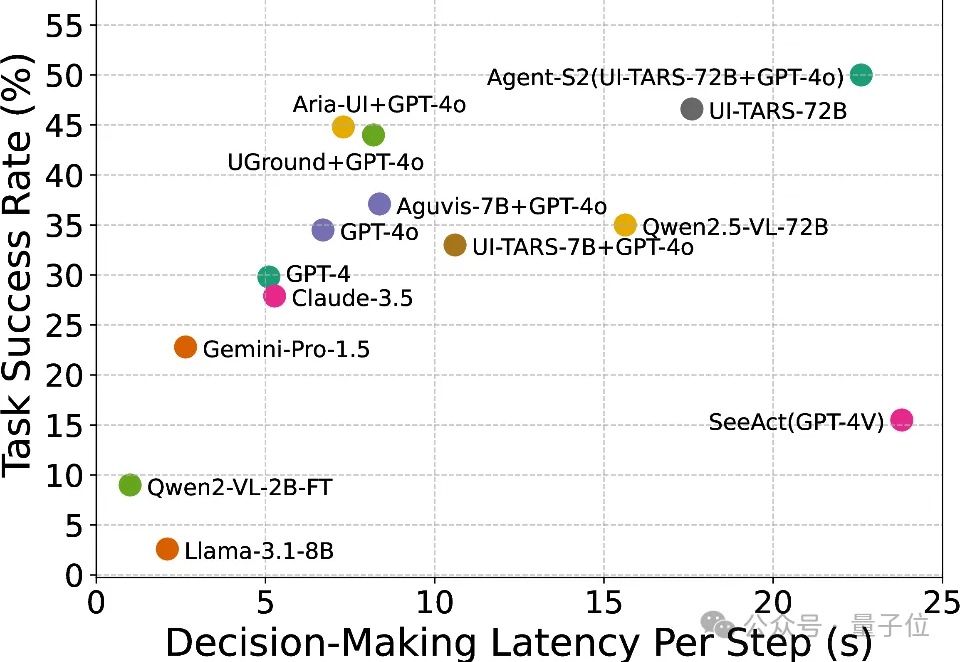

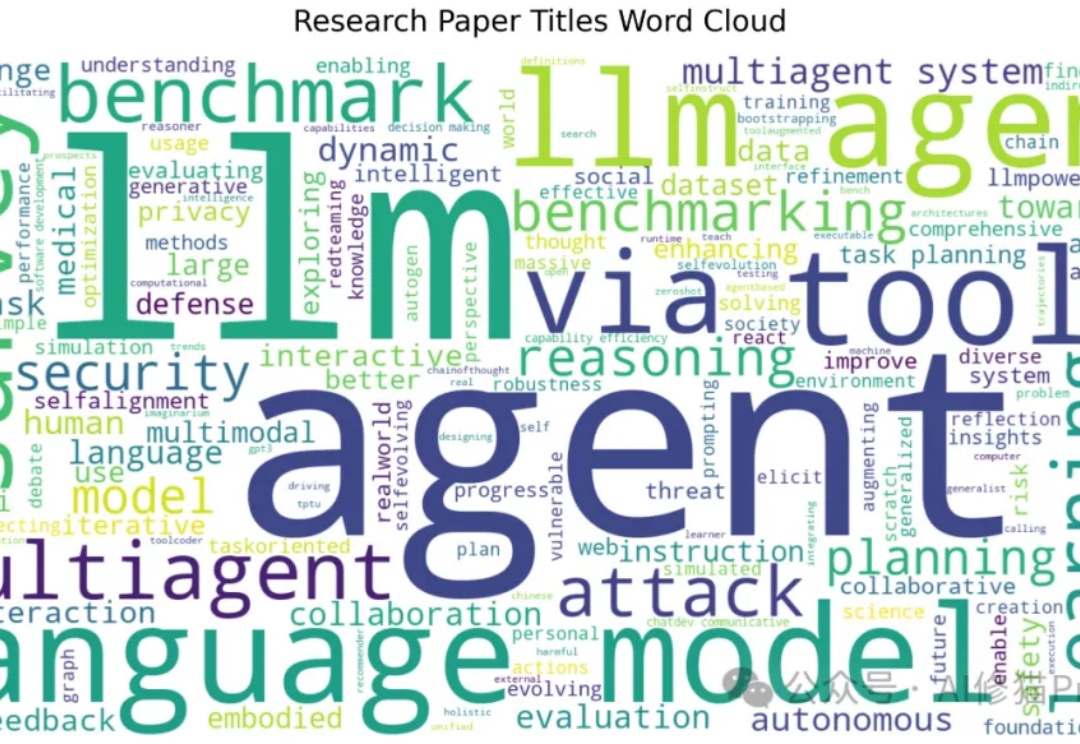

2025年,人工智能领域正在经历一场由LLM Agent引发的深刻变革,不管普通人的衣食住行还是研究者的尖端研究,都很难不受Agent的影响。

你是否曾对着一个繁复的AI框架,无奈地想:"真有必要搞得这么复杂吗?"在与臃肿框架斗争一年后,Zachary Huang博士决定大刀阔斧地革新,剔除所有花里胡哨的部分。于是Pocket Flow诞生了——一个仅有100行代码的超轻量级大语言模型框架!

AI社区掀起用大模型玩游戏之风!例如国外知名博主让DeepSeek和Chatgpt下国际象棋的视频在Youtube上就获得百万播放,ARC Prize组织最近也发布了一个贪吃蛇LLM评测基准SnakeBench。

Spatial-RAG结合了空间数据库和大型语言模型(LLM)的能力,能够处理复杂的空间推理问题。通过稀疏和密集检索相结合的方式,Spatial-RAG可以高效地从空间数据库中检索出满足用户查询的空间对象,并利用LLM的语义理解能力对这些对象进行排序和生成最终答案。

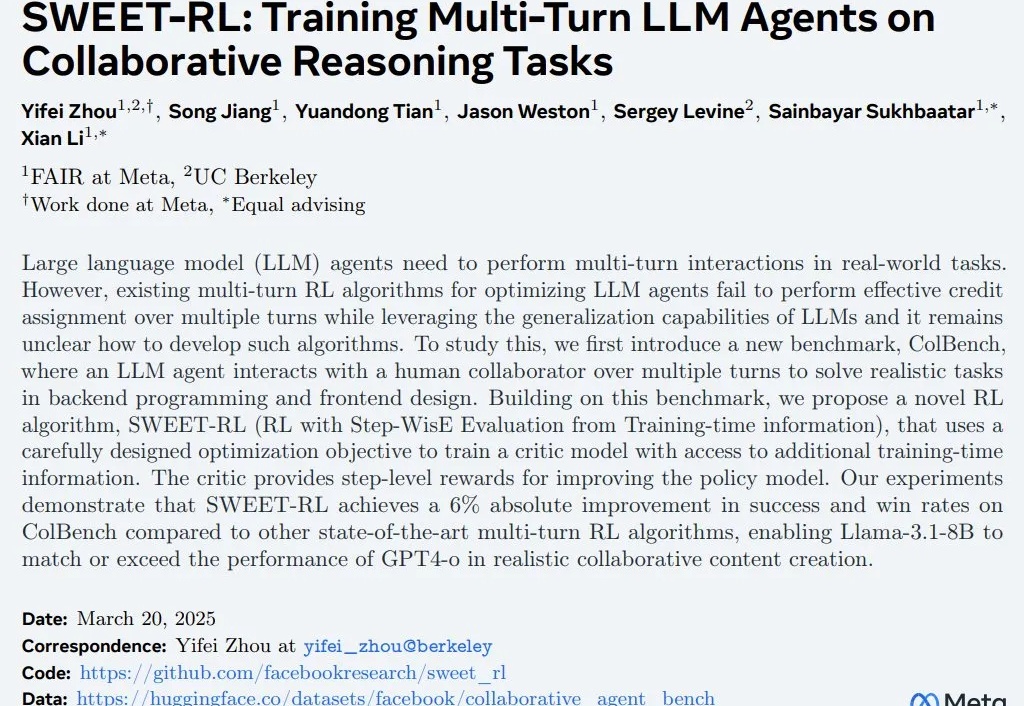

强化学习提升了 LLM 各方面的能力,而强化学习本身也在进化。