RLHF与RLVR全都要,陈丹琦团队最新力作将推理能力拓展到通用智能

RLHF与RLVR全都要,陈丹琦团队最新力作将推理能力拓展到通用智能一个月前,我们曾报道过清华姚班校友、普林斯顿教授陈丹琦似乎加入 Thinking Machines Lab 的消息。有些爆料认为她在休假一年后,会离开普林斯顿,全职加入 Thinking Machines Lab。

一个月前,我们曾报道过清华姚班校友、普林斯顿教授陈丹琦似乎加入 Thinking Machines Lab 的消息。有些爆料认为她在休假一年后,会离开普林斯顿,全职加入 Thinking Machines Lab。

在大模型训练时,如何管理权重、避免数值爆炸与丢失?Thinking Machines Lab 的新研究「模块流形」提出了一种新范式,它将传统「救火式」的数值修正,转变为「预防式」的约束优化,为更好地训练大模型提供了全新思路。

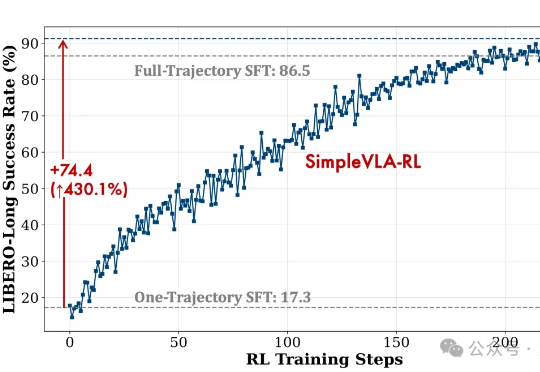

视觉-语言-动作模型是实现机器人在复杂环境中灵活操作的关键因素。然而,现有训练范式存在一些核心瓶颈,比如数据采集成本高、泛化能力不足等。

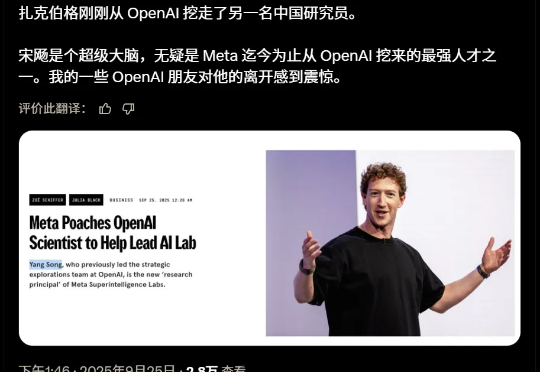

刚刚,Meta又从OpenAI挖来一员猛将——宋飏,扩散模型领域的核心人物,DALL·E 2技术路径的早期奠基者。他已正式加入Meta Superintelligence Labs,担任研究负责人,直接向他的师兄赵晟佳汇报。

一家仅成立9个月的新公司——奇妙拉比MarveLab,在2025年8月推出的首款AI潮玩RAGUS&WHITE,凭借超过5000单的预售成绩,超200万的首发营收,迅速成为行业内的讨论热点。

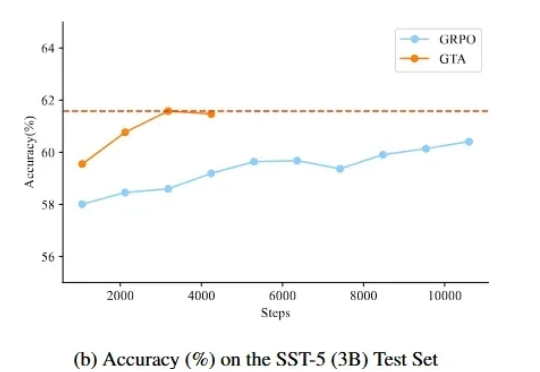

监督微调(SFT)和强化学习(RL)微调是大模型后训练常见的两种手段。通过强化学习微调大模型在众多 NLP 场景都取得了较好的进展,但是在文本分类场景,强化学习未取得较大的进展,其表现往往不如监督学习。

靠电商和云计算席卷全球的亚马逊,正在借这一波Gen AI浪潮,续写新的故事—— 大家可能不知道,去年9月,它在旧金山成立了自己的AI实验室,Amazon AGI SF Lab(以下简称亚马逊AGI实验室)。

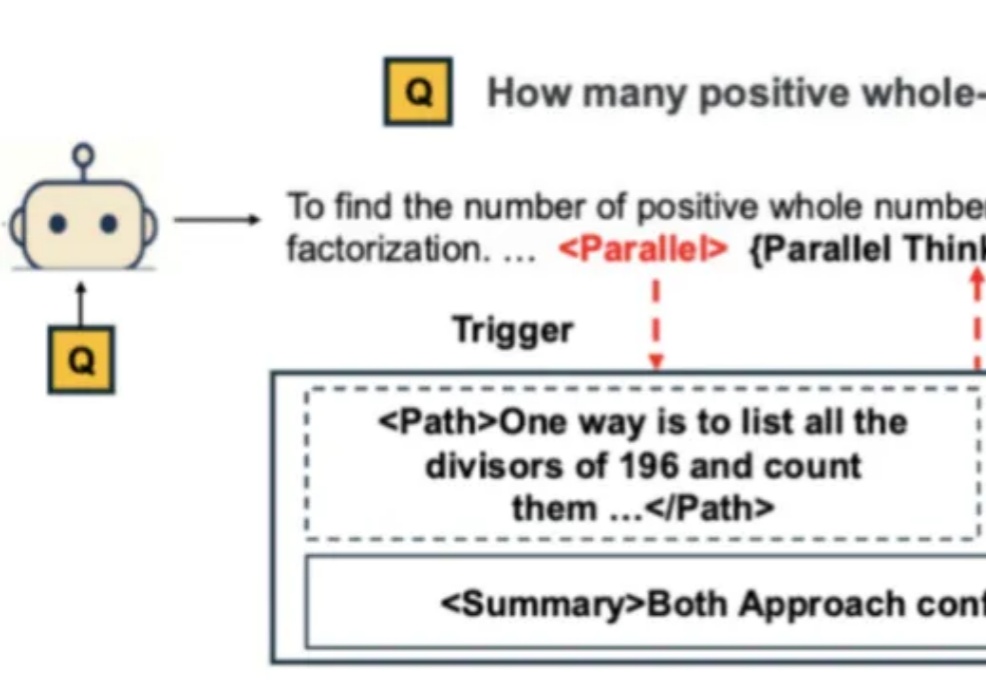

自从 Google Gemini 将数学奥赛的成功部分归功于「并行思维」后,如何让大模型掌握这种并行探索多种推理路径的能力,成为了学界关注的焦点。

这听起来像科幻电影,但Phota Labs正在让这一切成为现实。这家由前Adobe AI研究员创立的公司刚刚获得了由Andreessen Horowitz领投的560万美元种子轮融资,他们正在用个性化的视觉AI技术彻底重新定义摄影的边界。

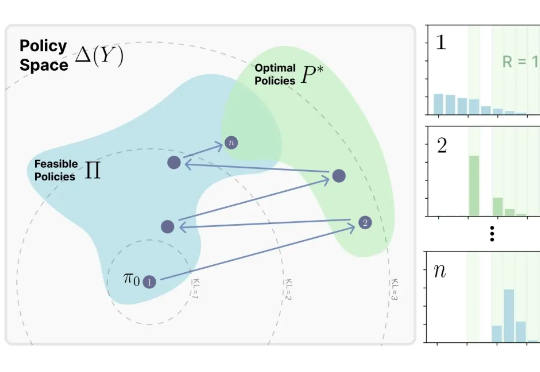

来自MIT Improbable AI Lab的研究者们最近发表了一篇题为《RL's Razor: Why Online Reinforcement Learning Forgets Less》的论文,系统性地回答了这个问题,他们不仅通过大量实验证实了这一现象,更进一步提出了一个简洁而深刻的解释,并将其命名为 “RL's Razor”(RL的剃刀)。