MIT教授NeurIPS歧视言论炸雷,中国女学生霸气反击!AI大佬集体痛斥,道歉信来了

MIT教授NeurIPS歧视言论炸雷,中国女学生霸气反击!AI大佬集体痛斥,道歉信来了MIT教授侮辱中国学生的言论,彻底掀翻了整个学术圈!在NeurIPS受邀演讲中,她大放厥词「中国学生不诚实」,并在一张PPT明确提到中国国籍。这一恶性事件,引来Jeff Dean等业界大佬怒斥。

MIT教授侮辱中国学生的言论,彻底掀翻了整个学术圈!在NeurIPS受邀演讲中,她大放厥词「中国学生不诚实」,并在一张PPT明确提到中国国籍。这一恶性事件,引来Jeff Dean等业界大佬怒斥。

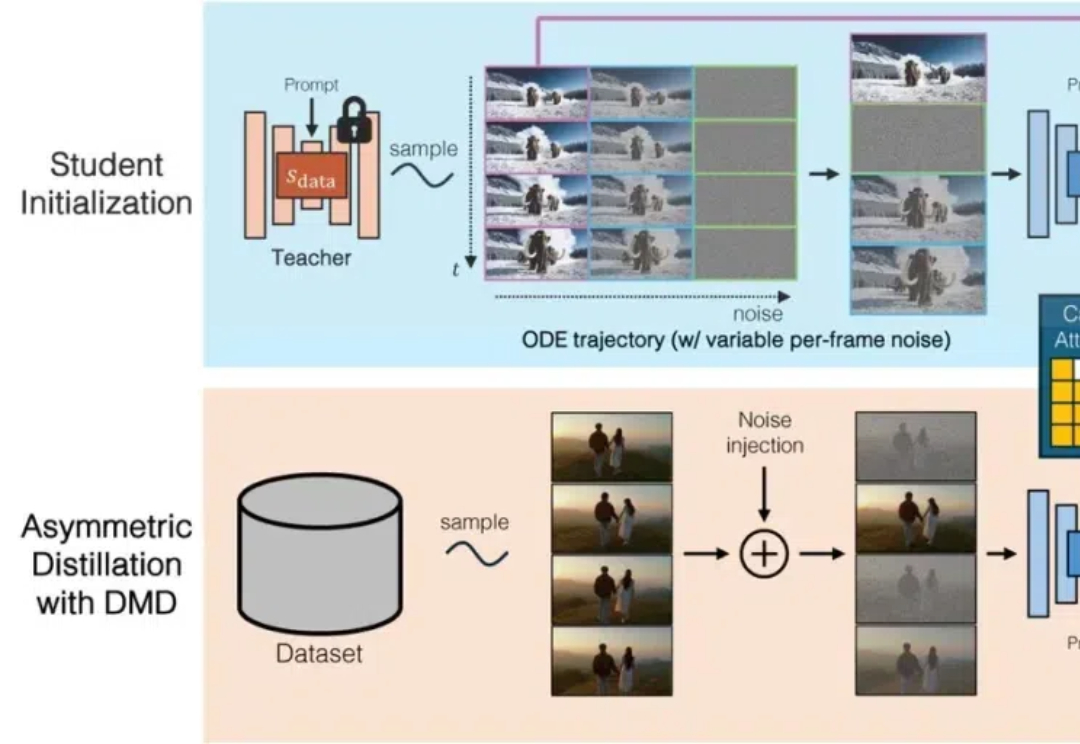

AI生成视频,边生成边实时播放,再不用等了! Adobe与MIT联手推出自回归实时视频生成技术——CausVid。

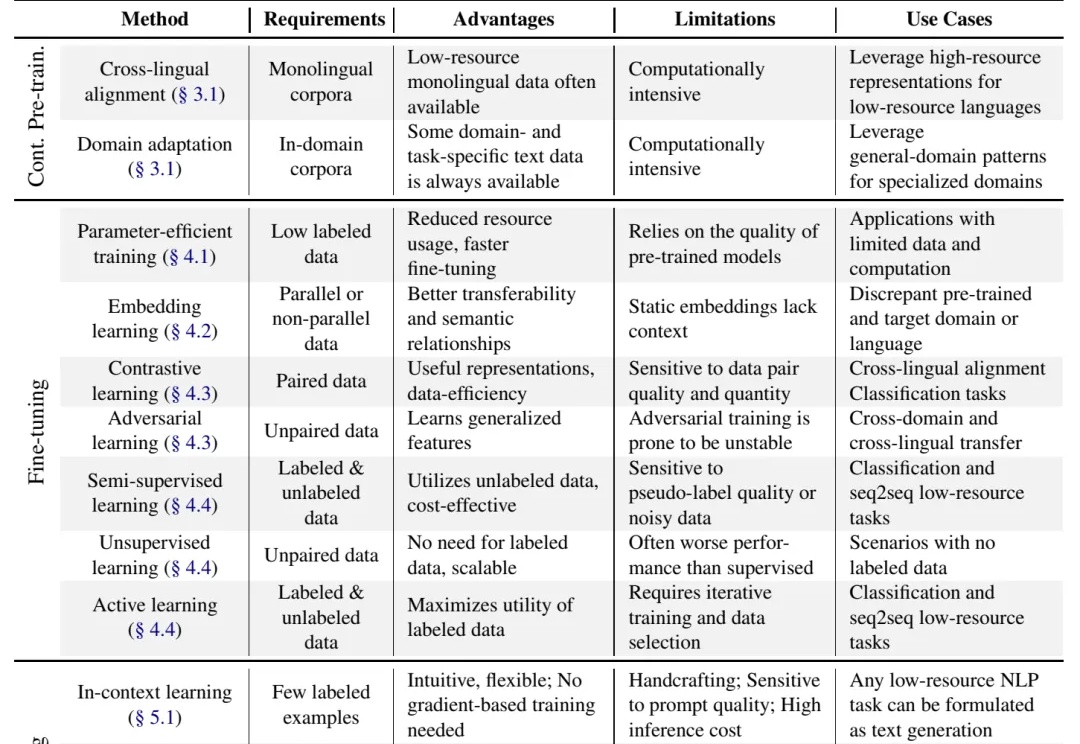

别说什么“没数据就去标注啊,没钱标注就别做大模型啊”这种风凉话,有些人数据不足也能做大模型,是因为有野心,就能想出来稀缺数据场景下的大模型解决方案,或者整理出本文将要介绍的 "Practical Guide to Fine-tuning with Limited Data" 这样的综述。

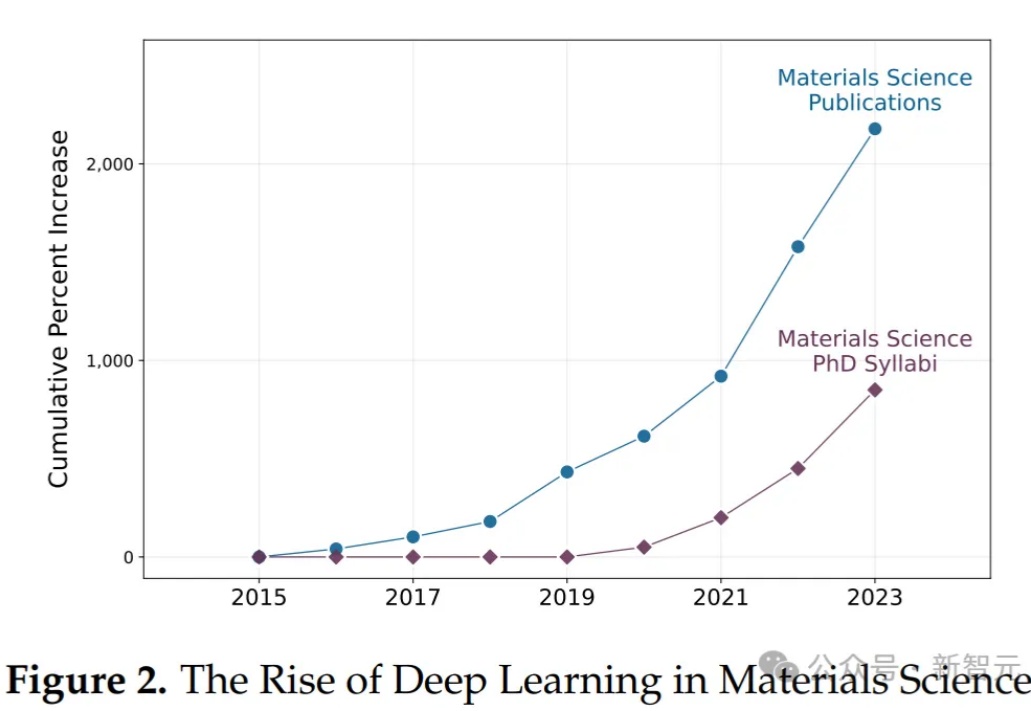

MIT的76页深度报告!AI辅助创新显著增长——这毋庸置疑。但,值得注意的是,AI加剧了不同水平科学家产出的差异,这与科学家的判断力强相关,意味着缺乏判断力的科学家在未来可能会被慢慢淘汰……

近日,来自斯坦福、MIT等机构的研究人员推出了低秩线性转换方法,让传统注意力无缝转移到线性注意力,仅需0.2%的参数更新即可恢复精度,405B大模型两天搞定!

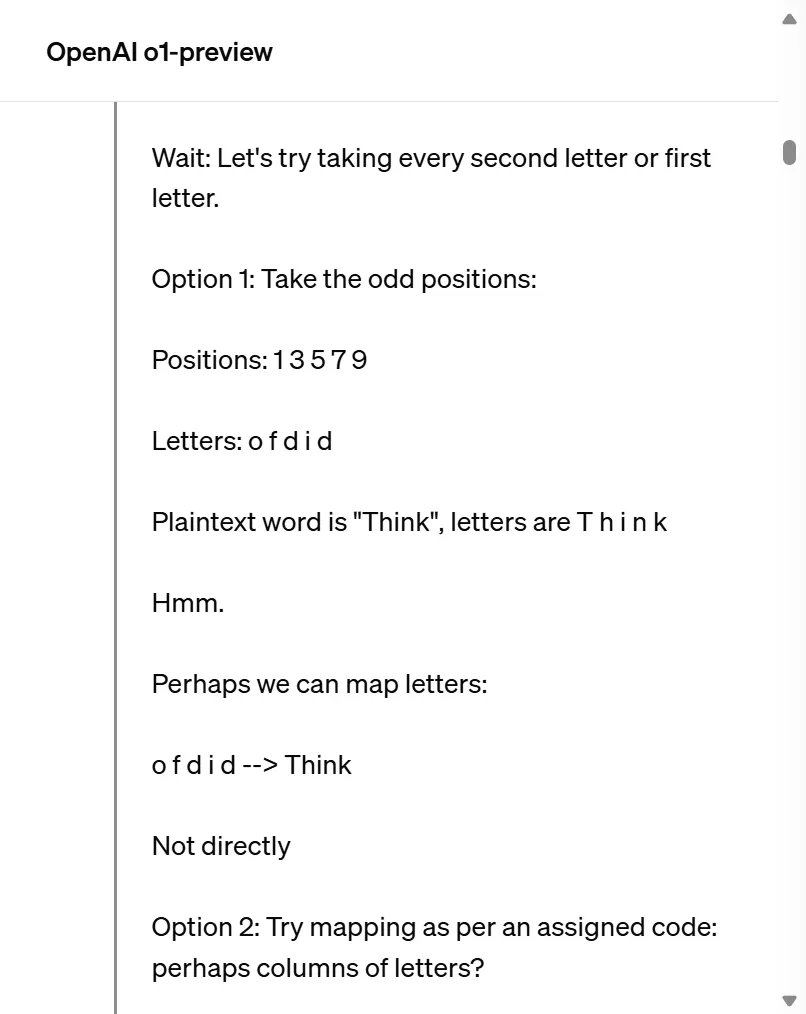

自我纠错(Self Correction)能力,传统上被视为人类特有的特征,正越来越多地在人工智能领域,尤其是大型语言模型(LLMs)中得到广泛应用,最近爆火的OpenAI o1模型[1]和Reflection 70B模型[2]都采取了自我纠正的方法。

如今,机器人学习最大的瓶颈是缺乏数据。与图片和文字相比,机器人的学习数据非常稀少。目前机器人学科的主流方向是通过扩大真实世界中的数据收集来尝试实现通用具身智能,但是和其他的基础模型,比如初版的 StableDiffusion 相比,即使是 pi 的数据都会少七八个数量级。

哈佛斯坦福MIT等机构首次提出「精度感知」scaling law,揭示了精度、参数规模、数据量之间的统一关系。数据量增加,模型对量化精度要求随之提高,这预示着AI领域低精度加速的时代即将结束!

在欧洲最大科技峰会Web Summit上,阿里国际推出全球首个B2B领域的AI搜索引擎Accio,面向全球商家开放,正式入局当下火热的AI Search赛道。

昨天,The Information 的一篇文章让 AI 社区炸了锅。