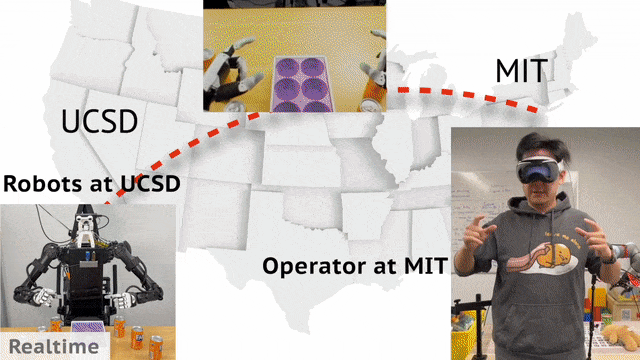

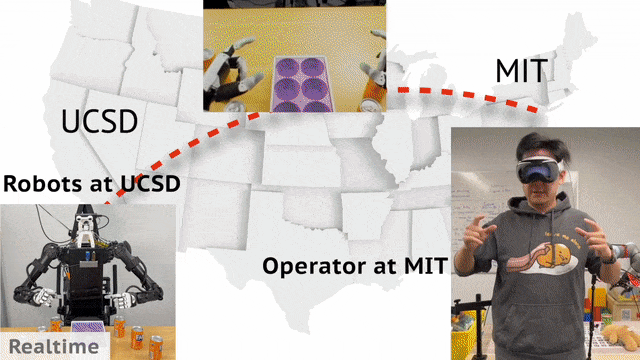

相隔3000英里,用苹果头显遥控机器人!UCSD、MIT华人团队开源TeleVision

相隔3000英里,用苹果头显遥控机器人!UCSD、MIT华人团队开源TeleVision现实中,机器人收据收集可以通过远程操控实现。来自UCSD、MIT的华人团队开发了一个通用框架Open-TeleVision,可以让你身临其境操作机器人,即便相隔3000英里之外。

现实中,机器人收据收集可以通过远程操控实现。来自UCSD、MIT的华人团队开发了一个通用框架Open-TeleVision,可以让你身临其境操作机器人,即便相隔3000英里之外。

几乎每一天,AI都在获得新的能力。在机器人、大模型等热门赛道涌现后,专注企业服务的AI技术成为后起之秀,在智能客服、营销获客、企业培训等企服领域大展拳脚。

从MIT辍学后,华裔少年Alexandr Wang开始建立自己的初创公司,从此开始走向人生巅峰。押对数据标注方向后,他在27岁时就成为了亿万富翁。The Information刚刚发了长文,爆料了Wang的公司崛起的内幕。

深圳市不停科技有限公司(以下简称「不停科技」)近日完成近亿元A+轮融资,本次由华山资本(WestSummit Capital )领投,老股东高秉强教授生态圈基金未来科技参与投资,老股东李泽湘教授旗下清水湾基金、甘洁教授旗下知行一号基金连续三轮继续超额加持。星辰资本担任后续融资独家财务顾问。

何恺明入职MIT副教授后,首次带队的新作来了!

MIT成华人创业工厂,女性创业占20%

本月初,来自 MIT 等机构的研究者提出了一种非常有潜力的 MLP 替代方法 ——KAN。

AI教父Hinton的担心,不是没有道理。

大模型回答如何更可靠?MIT研究团队设计出「共识博弈」,将数学家常用的博弈论引入LLM改进中。没想到,LLaMA-7B的表现,击败了LLaMA-65B,甚至与PaLM-540B相媲美。

刚刚提出了KAN的MIT物理学家Max Tegmark和北大校友刘子鸣,又有一项重磅研究问世了!团队发现,它们用AI发现了物理学中的新方程,从此,AI很可能被引入物理学研究领域,帮助人类物理学家做出全新的发现。