Recap | Prompt实战全景图:探索AI在编程、教育、创作、音乐中的可能性

Recap | Prompt实战全景图:探索AI在编程、教育、创作、音乐中的可能性MT Park 的第12场AI分享会顺利进行!~🎉 感谢向阳乔木老师非常细致地分享了: 他探索 Prompt 的多场景实践,从 Cursor、Windsurf 等 vibe 编程工具,到 Veo3 的视频生成,覆盖编程、教育、内容创作等多个方向,带你快速上手 AI 最实用的玩法。

MT Park 的第12场AI分享会顺利进行!~🎉 感谢向阳乔木老师非常细致地分享了: 他探索 Prompt 的多场景实践,从 Cursor、Windsurf 等 vibe 编程工具,到 Veo3 的视频生成,覆盖编程、教育、内容创作等多个方向,带你快速上手 AI 最实用的玩法。

随着大模型能力的突破,“可调用工具的智能体”已经迅速从实验室概念走向应用落地,成为继大模型之后的又一爆发点。

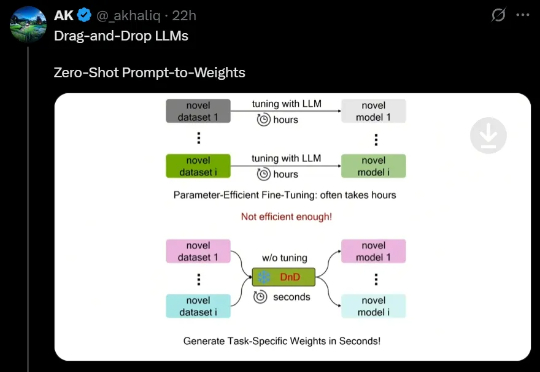

最近,来自NUS、UT Austin等机构的研究人员创新性地提出了一种「拖拽式大语言模型」(DnD),它可以基于提示词快速生成模型参数,无需微调就能适应任务。不仅效率最高提升12000倍,而且具备出色的零样本泛化能力。

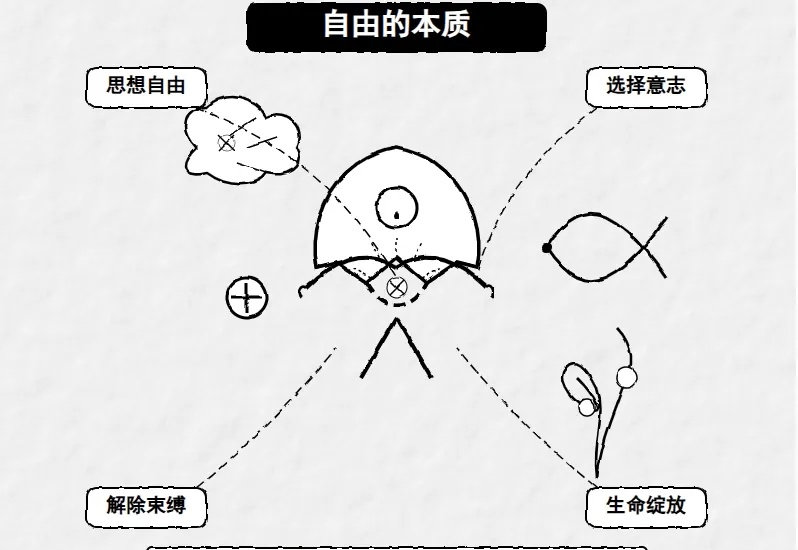

让它画一张黑白手绘风格的svg图片,说明一下“自由”的本质。Prompt:“用黑白手绘风格,说明自由的本质,用svg图解。”

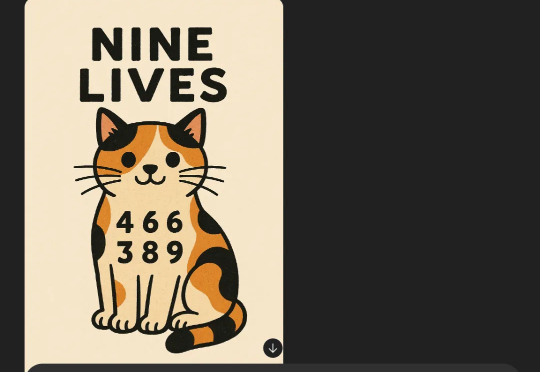

生成图像这件事,会推理的AI才是好AI。 举个例子,以往要是给AI一句这样的Prompt: (3+6)条命的动物。 我们人类肯定一眼就知道是猫咪,但AI的思考过程却是这样的:

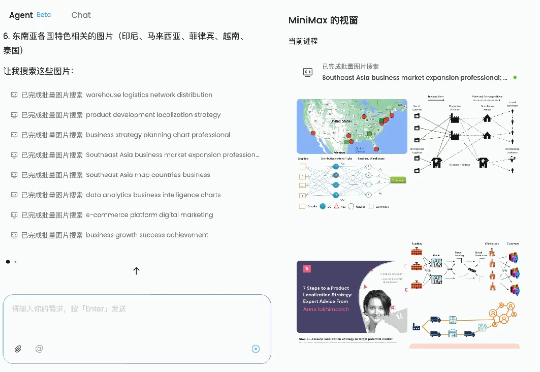

今年上半年,最吊足胃口和期待的,莫过于 Agent 工具,饼画得都很大:日常中那些烧脑、重复、耗时间的任务,现在似乎只需要动动手指、敲几行 prompt 就能搞定。

您有没有发现一个奇怪的现象:同样是Vibe coding,有些人轻松拿到完整的Flask应用,有些人却只得到几行if-else语句?剑桥大学计算机科学与技术系的研究者们最近发布了一项研究,用科学的方法证实了我们的直觉——AI确实会"看人下菜碟"。

在计算机科学领域,有一句英文谚语——「Garbage in, Garbage out」。

现在市面上有46种Prompt工程技术,但真正能在软件工程任务中发挥作用的,可能只有那么几种。来自巴西联邦大学、加州大学尔湾分校等顶级院校的研究者们,花了大量时间和计算资源,调研了58种,整理了46种,最终筛选测试了14种主流提示技术在10个软件工程任务上的表现,用了4个不同的大模型(包括咱们的Deepseek-V3),总共跑了2000多次实验。

宾夕法尼亚大学沃顿商学院生成式AI实验室刚刚发布了两份重磅研究报告,通过严格的科学实验揭示了一个令人震惊的事实:我们可能一直在用错误的方式与AI对话。这不是胡说八道,而是基于近4万次实验得出的硬核数据推理的结论。