Jamba 1.5发布,最长上下文,非Transformer架构首次成功领先

Jamba 1.5发布,最长上下文,非Transformer架构首次成功领先Jamba是第一个基于 Mamba 架构的生产级模型。Mamba 是由卡内基梅隆大学和普林斯顿大学的研究人员提出的新架构,被视为 Transformer 架构的有力挑战者。

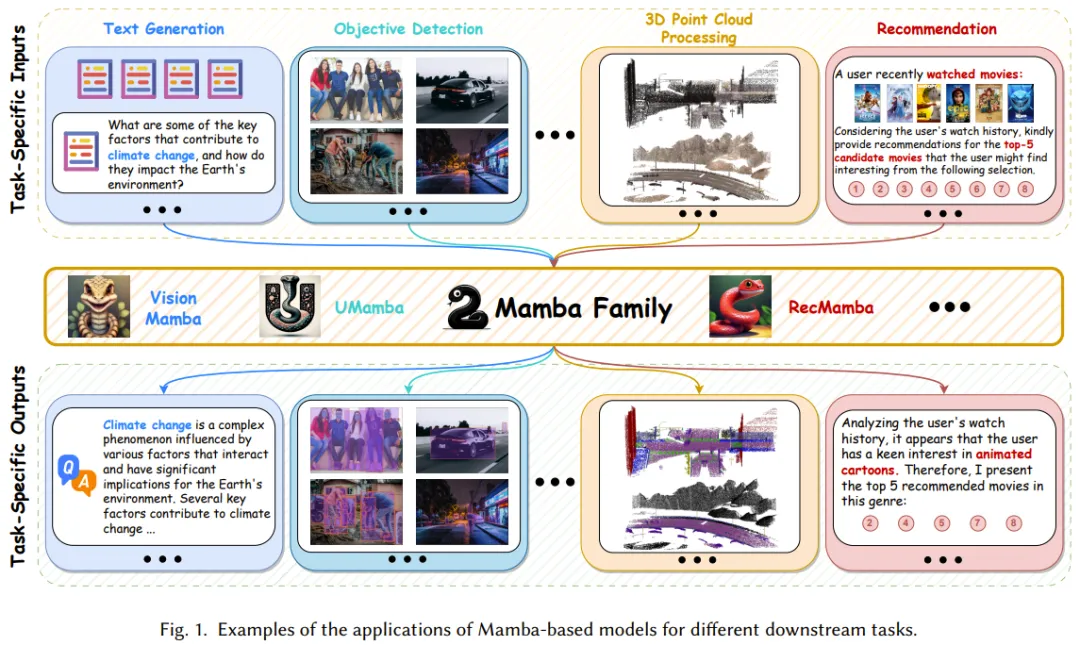

Jamba是第一个基于 Mamba 架构的生产级模型。Mamba 是由卡内基梅隆大学和普林斯顿大学的研究人员提出的新架构,被视为 Transformer 架构的有力挑战者。

Attention is all you need.

Mamba 虽好,但发展尚早。

Mamba 架构的大模型又一次向 Transformer 发起了挑战

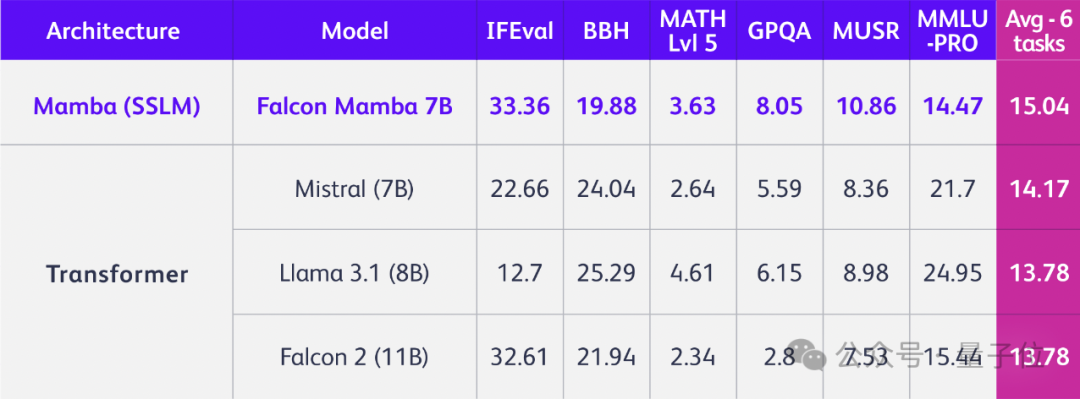

TII开源全球第一个通用的大型Mamba架构模型Falcon Mamba 7B,性能与Transformer架构模型相媲美,在多个基准测试上的均分超过了Llama 3.1 8B和Mistral 7B。

只是换掉Transformer架构,立马性能全方位提升,问鼎同规模开源模型!

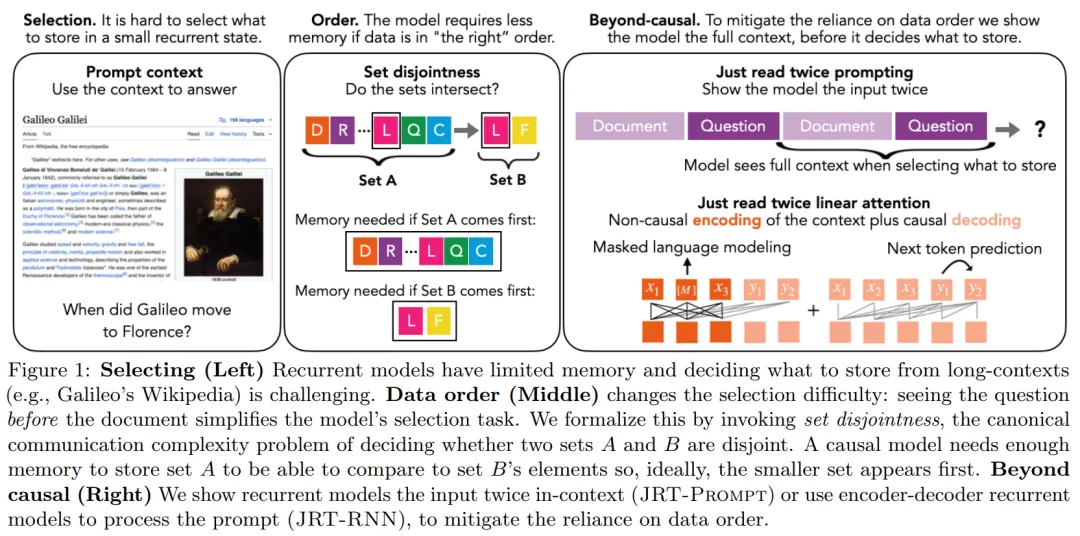

在当前 AI 领域,大语言模型采用的主流架构是 Transformer。不过,随着 RWKV、Mamba 等架构的陆续问世,出现了一个很明显的趋势:在语言建模困惑度方面与 Transformer 较量的循环大语言模型正在快速进入人们的视线。

这几日,AI 圈又一“震惊”事件!!

Mistral AI两款全新7B模型宣战OpenAI,对标更长的代码分析和更高效的数学推理。

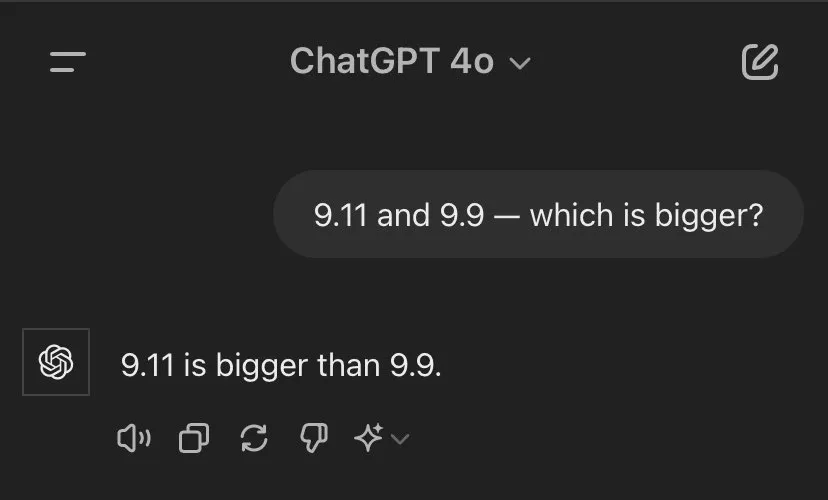

网友很好奇,Mathstral能不能搞定「9.11和9.9谁大」这一问题。