万亿市场 !开源AI大模型发展研究报告 2024

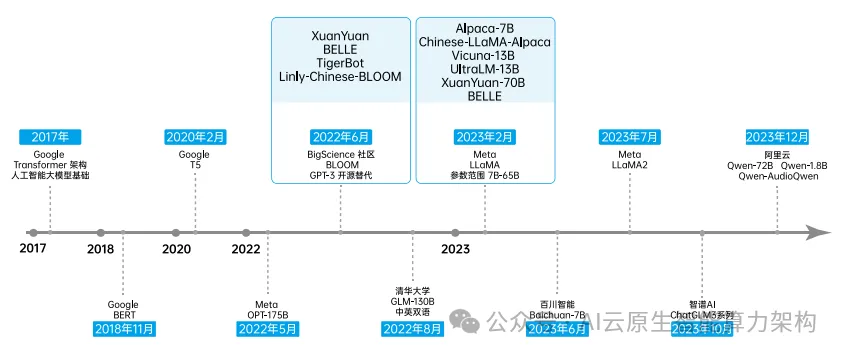

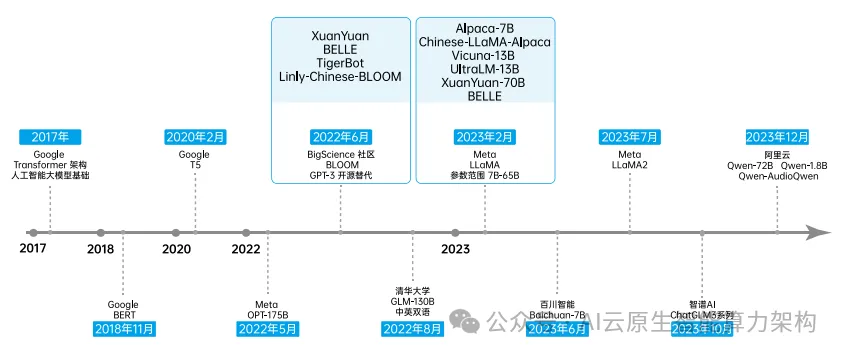

万亿市场 !开源AI大模型发展研究报告 2024随着开源技术占据各大新兴领域的技术路线,其不断丰富人工智能领域的应用场景。 2023年,Meta 相继发布 Llama 和 Llama2,很快成为广受欢迎的开源大模型,也成为许多模型的基座模型。

随着开源技术占据各大新兴领域的技术路线,其不断丰富人工智能领域的应用场景。 2023年,Meta 相继发布 Llama 和 Llama2,很快成为广受欢迎的开源大模型,也成为许多模型的基座模型。

AI 智能体可以设计 AI 吗?

CGPO框架通过混合评审机制和约束优化器,有效解决了RLHF在多任务学习中的奖励欺骗和多目标优化问题,显著提升了语言模型在多任务环境中的表现。CGPO的设计为未来多任务学习提供了新的优化路径,有望进一步提升大型语言模型的效能和稳定性。

Agent-to-Sim (ATS) 是一个创新的三维模拟系统,能够从日常视频集合中学习三维代理的交互行为模型,由 Meta Codec Avatar 实验室主导研发。

学术界对广泛监管的主要论点是,政府不应在技术层面上对人工智能或其他技术进行如此严格的监管。

最新消息,Meta 正在研发一款AI驱动的搜索引擎,旨在为使用 Meta AI 聊天机器人的用户提供关于时事的对话式回答,同时降低对谷歌和微软的依赖。

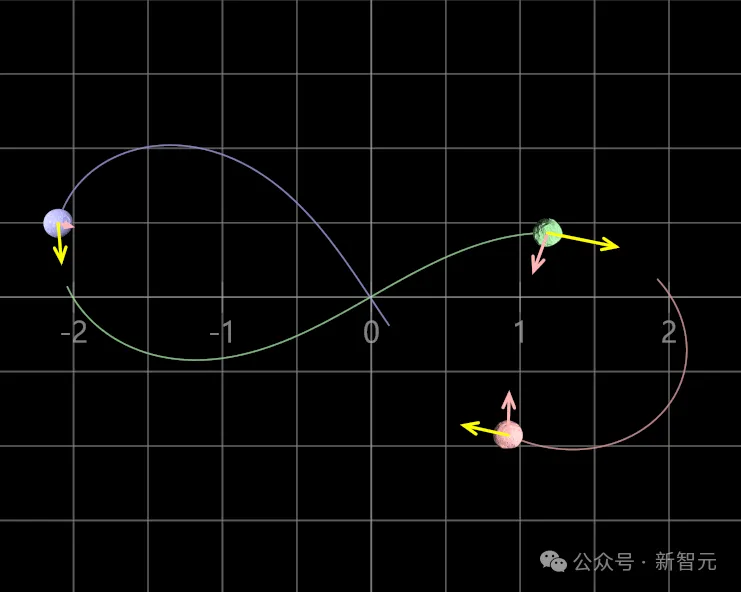

Transformer解决了三体问题?Meta研究者发现,132年前的数学难题——发现全局李雅普诺夫函数,可以被Transformer解决了。「我们不认为Transformer是在推理,它可能是出于对数学问题的深刻理解,产生了超级直觉。」AI可以搞基础数学研究了,陶哲轩预言再成真。

人工智能领域的开源问题一直存在,其中最大的争议点是到底什么样的人工智能可以称之为“开源”。开放源代码倡议(OSI)作为业内公认的开源仲裁机构,二十五年来一直负责管理开放源代码定义 (OSD)。在过去两三年中,OSI 致力于为开源 AI 制定定义和标准,以构建可供任何人用于研究、修改和共享的 AI 系统。

随着谷歌和 Meta 相继推出基于大语言模型的 AI 播客功能,将极大地丰富人类用户与 AI 智能体互动的体验。

AI评估AI可靠吗?来自Meta、KAUST团队的最新研究中,提出了Agent-as-a-Judge框架,证实了智能体系统能够以类人的方式评估。它不仅减少97%成本和时间,还提供丰富的中间反馈。