扎克伯格新访谈:智能眼镜是最完美的AI助手,也是最终极的数字社交

扎克伯格新访谈:智能眼镜是最完美的AI助手,也是最终极的数字社交Meta 的未来是打造「awesome」的产品

Meta 的未来是打造「awesome」的产品

实话说,我一直没想明白阿里为什么会在大模型这个赛道,成为中国版的Meta。

真·「3D」眼镜。即使没有用过,你也很可能对外网的热门拍照社交平台 Snapchat 有所耳闻。

Jiajun Xu : Meta AI科学家,专注大模型和智能眼镜开发。南加州大学博士,Linkedin Top AI Voice,畅销书作家。他的AI科普绘本AI for Babies (“宝宝的人工智能”系列,双语版刚在国内出版) 畅销硅谷,曾获得亚马逊儿童软件、编程新书榜榜首。

当前流行的基于嵌入检索的RAG(Retrieval-Augmented Generation)技术由Meta在2020年首次提出,最初应用于开放领域的抽取式问答。

论文的审稿模式想必大家都不会陌生,一篇论文除了分配多个评审,最后还将由PC综合评估各位审稿人的reviews撰写meta-review。

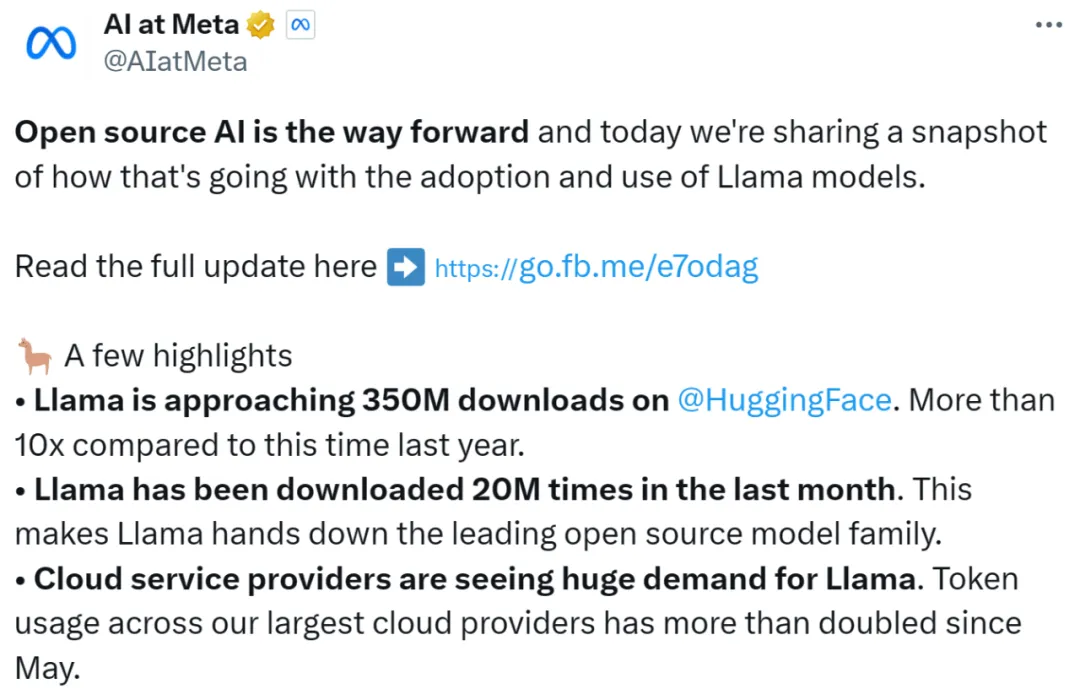

今天一大早,Meta 便秀了一把「Llama 系列模型在开源领域取得的成绩」,包括如下:

最近,Meta的多个工程团队联合发表了一篇论文,描述了在引入基于GPU的分布式训练时,他们如何为其「量身定制」专用的数据中心网络。

在2024年AI Infra @Scale会议上发表开幕主旨演讲

Meta的开源大模型Llama 3在市场上遇冷,进一步加剧了大模型开源与闭源之争的关注热度。