Meta首发「变色龙」挑战GPT-4o,34B参数引领多模态革命!10万亿token训练刷新SOTA

Meta首发「变色龙」挑战GPT-4o,34B参数引领多模态革命!10万亿token训练刷新SOTAGPT-4o发布不到一周,首个敢于挑战王者的新模型诞生!最近,Meta团队发布了「混合模态」Chameleon,可以在单一神经网络无缝处理文本和图像。10万亿token训练的34B参数模型性能接近GPT-4V,刷新SOTA。

GPT-4o发布不到一周,首个敢于挑战王者的新模型诞生!最近,Meta团队发布了「混合模态」Chameleon,可以在单一神经网络无缝处理文本和图像。10万亿token训练的34B参数模型性能接近GPT-4V,刷新SOTA。

Llama 3开源后,聊天机器人Meta AI也宣布使用新模型作为基座,在Meta旗下的各种软件(Meta.ai、Instagram、Facebook、WhatsApp)中都可以进行免费体验。

众所周知,大语言模型的训练常常需要数月的时间,使用数百乃至上千个 GPU。以 LLaMA2 70B 模型为例,其训练总共需要 1,720,320 GPU hours。由于这些工作负载的规模和复杂性,导致训练大模型存在着独特的系统性挑战。

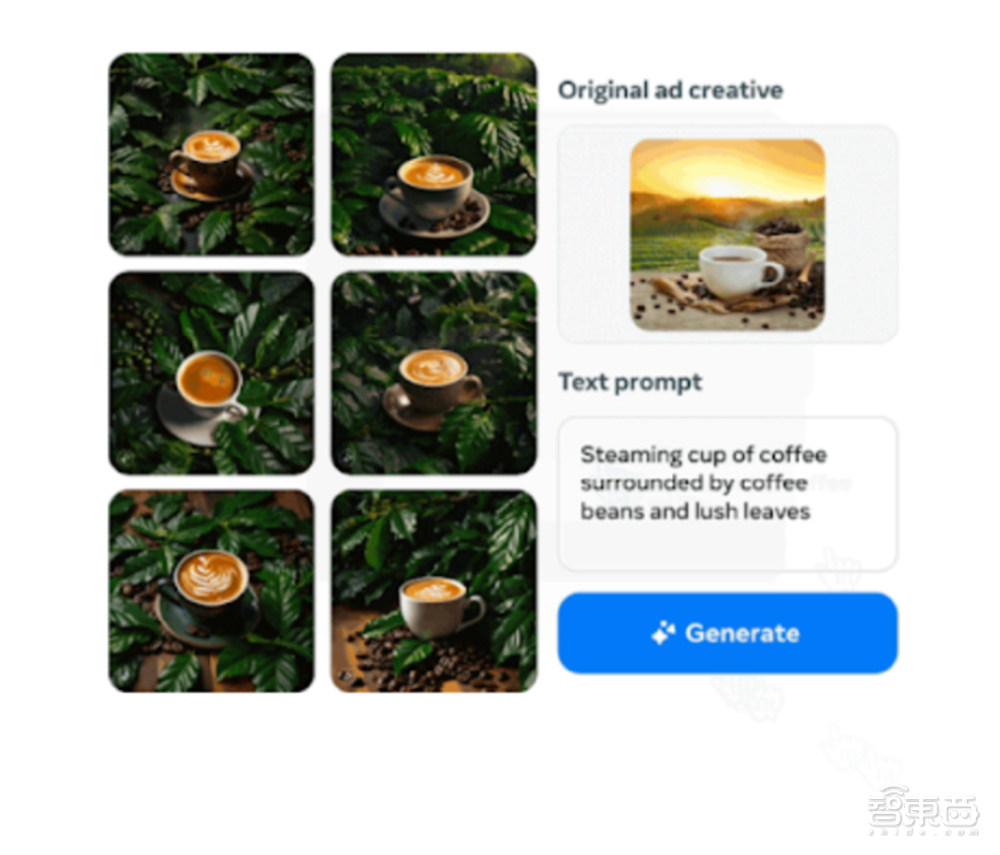

智东西5月9日报道,近日,Meta宣布推出一系列增强的生成式AI技术,扩展其生成式AI广告产品。其中,新增工具能自动生成多样化图像并在其上叠加文字,提升广告商的创意水平和广告效果。

尽管苹果在生成式 AI 方面的进展没有像谷歌、Meta 和微软等竞争对手那样高调,但该公司一直在进行相关研究,其构筑新生态的思路总是显得与众不同。

我们知道,Meta 推出的 Llama 3、Mistral AI 推出的 Mistral 和 Mixtral 模型以及 AI21 实验室推出的 Jamba 等开源大语言模型已经成为 OpenAI 的竞争对手。

大模型发展至今早已火成了一个「概念」。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

“预测下一个token”被认为是大模型的基本范式,一次预测多个tokens又会怎样?

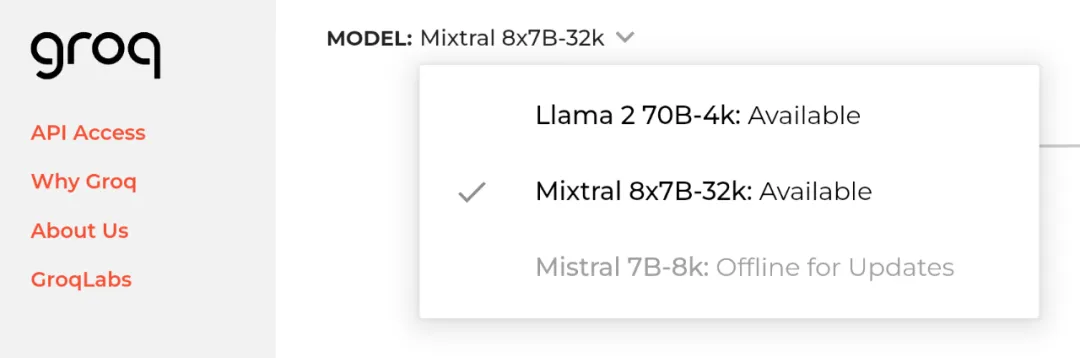

2024 年 4 月 20 日,即 Meta 开源 Llama 3 的隔天,初创公司 Groq 宣布其 LPU 推理引擎已部署 Llama 3 的 8B 和 70B 版本,每秒可输出token输提升至800。