Meta公布Llama 3训练集群细节!储备60万块H100迎接AGI

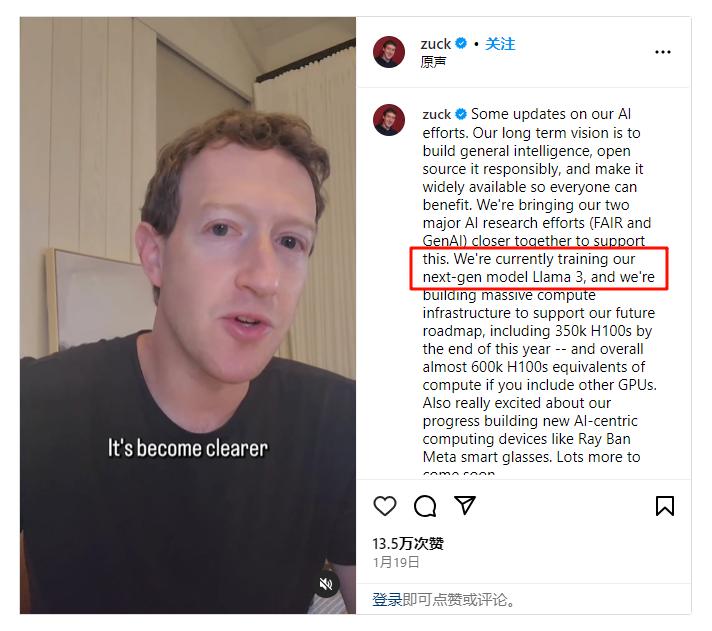

Meta公布Llama 3训练集群细节!储备60万块H100迎接AGILLM开源从Infra做起!Meta公布了自己训练Llama 3的H100集群细节,看来Llama 3快来了。

LLM开源从Infra做起!Meta公布了自己训练Llama 3的H100集群细节,看来Llama 3快来了。

最新报道澄清,“AI的尽头是光伏和储能”并非黄仁勋的原话。AI发展的确依赖于能源创新,当今科技圈的两位大佬,OpenAI创始人阿尔特曼和马斯克此前已给出明确观点。当下的重点在于开源,风能、光伏等可再生新能源被视作数据中心重要的能量池,核能尤其被寄予厚望

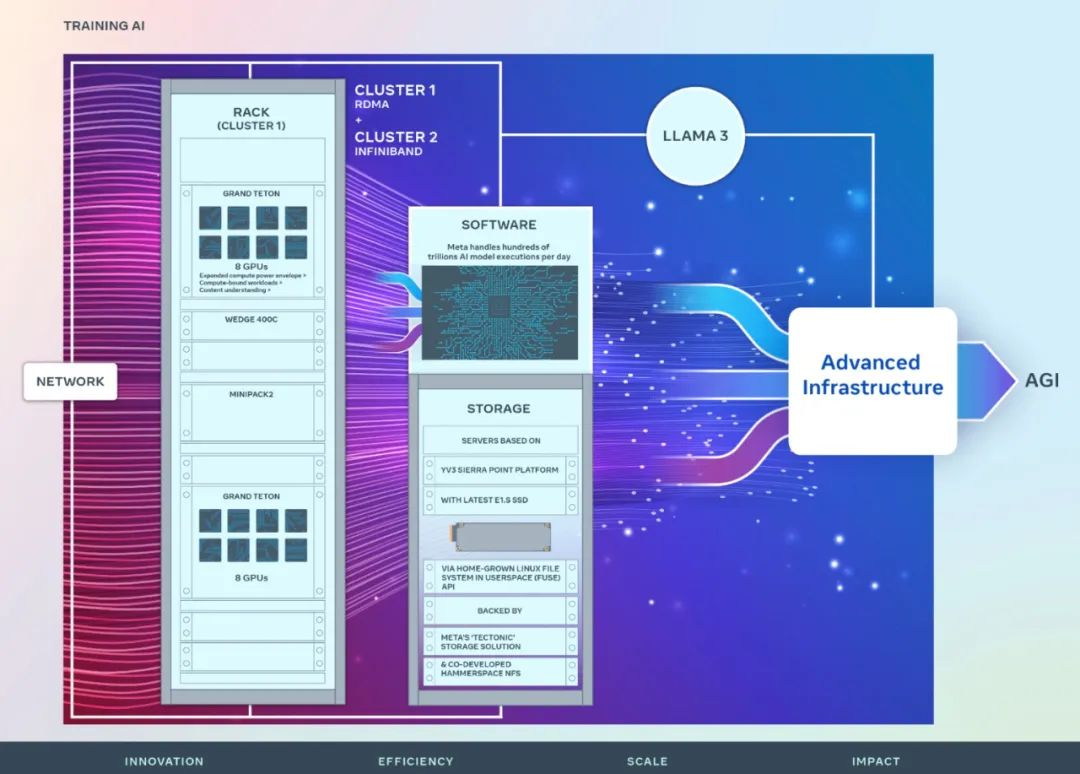

刚刚,Meta 宣布推出两个 24k GPU 集群(共 49152 个 H100),标志着 Meta 为人工智能的未来做出了一笔重大的投资。

半年多来,Meta 开源的 LLaMA 架构在 LLM 中经受了考验并大获成功(训练稳定、容易做 scaling)。

如果说 OpenAI 已经占据了今天闭源大模型生态的一极,那 Meta 无疑是代表开源大模型的另一极。

谷歌团队推出「通用视觉编码器」VideoPrism,在3600万高质量视频字幕对和5.82亿个视频剪辑的数据集上完成了训练,性能刷新30项SOTA。

从文本生成模型 GPT、文生图模型 DALL·E,到文生视频模型 Sora,OpenAI 可以说成功跑通了 AGI 的所有技术栈,为什么是 OpenAI 而不是谷歌、Meta?

短短几天,「世界模型」雏形相继诞生,AGI真的离我们不远了?Sora之后,LeCun首发AI视频预测架构V-JEPA,能够以人类的理解方式看世界。

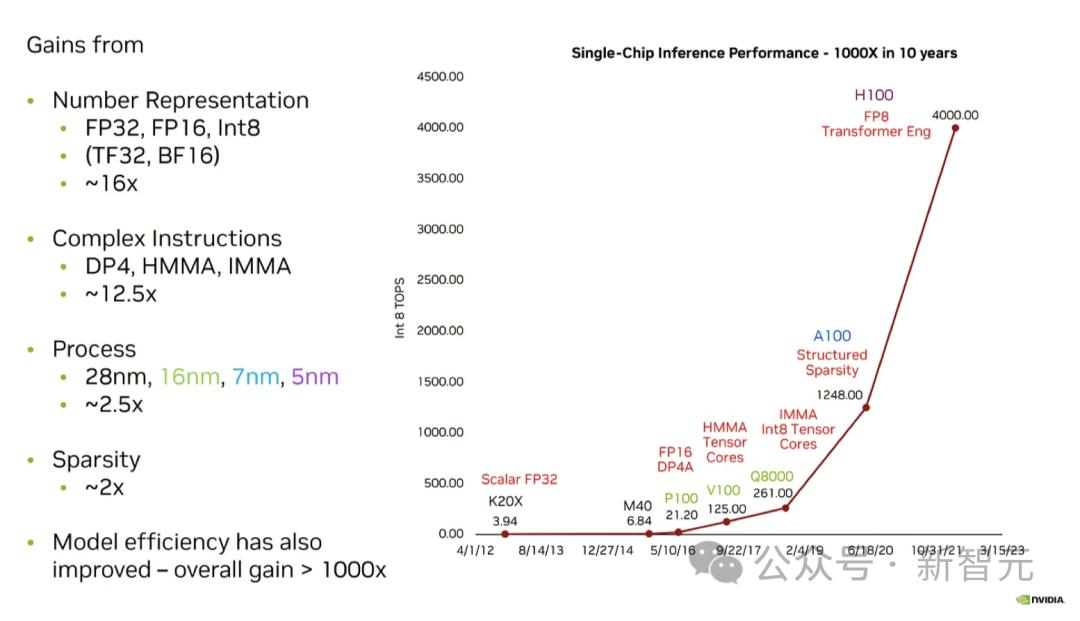

为了应对大模型不断复杂的推理和训练,英伟达、AMD、英特尔、谷歌、微软、Meta、Arm、高通、MatX以及Lemurian Labs,纷纷开始研发全新的硬件解决方案。

在文本生成音频(或音乐)这个 AIGC 赛道,Meta 最近又有了新研究成果,而且开源了。前几日,在论文《Masked Audio Generation using a Single Non-Autoregressive Transformer》中,Meta FAIR 团队、Kyutai 和希伯来大学推出了 MAGNeT,一种在掩码生成序列建模方法。