多忽悠几次AI全招了!Anthropic警告:长上下文成越狱突破口,GPT羊驼Claude无一幸免

多忽悠几次AI全招了!Anthropic警告:长上下文成越狱突破口,GPT羊驼Claude无一幸免大模型厂商在上下文长度上卷的不可开交之际,一项最新研究泼来了一盆冷水——Claude背后厂商Anthropic发现,随着窗口长度的不断增加,大模型的“越狱”现象开始死灰复燃。无论是闭源的GPT-4和Claude 2,还是开源的Llama2和Mistral,都未能幸免。

大模型厂商在上下文长度上卷的不可开交之际,一项最新研究泼来了一盆冷水——Claude背后厂商Anthropic发现,随着窗口长度的不断增加,大模型的“越狱”现象开始死灰复燃。无论是闭源的GPT-4和Claude 2,还是开源的Llama2和Mistral,都未能幸免。

作为 Meta 的前 CTO,Quora CEO Adam D'Angelo 目前还是 OpenAI 的董事会成员,在 Quora 之外推出的 Poe,成为当下接入大模型最多的 Chatbot 平台:GPT-4、Claude3、Mistral 等模型都有,用户也可以在上面搭建自己的 Chatbot 机器人,如果有别的用户使用,还可以产生收益。

让大模型直接操纵格斗游戏《街霸》里的角色,捉对PK,谁更能打?GitHub上一种你没有见过的船新Benchmark火了。

这是迄今为止最强大的开源大语言模型,超越了 Llama 2、Mistral 和马斯克刚刚开源的 Grok-1。

Mistral 可以说是欧洲目前最有代表性的 AI 公司,开源小模型、MoE、专注欧洲多语言市场等等,都让它与美国的几家大模型公司如 OpenAI、Anthropic 截然不同。

刚刚,Mistral AI 的模型又更新了。 这次开源一如既往地「突然」,是在一个叫做 Cerebral Valley 的黑客松活动上公布的。

ChatGPT横空出世的2023年,欧洲能喊得上名号的全球性AI峰会有近20个,大约是美国的3倍、中国的5倍[1]。在人工智能权威杂志(AI Magazine)年末总结的“2023 Top10 AI Events”中,欧洲承办的会议占比高达70%[2]。

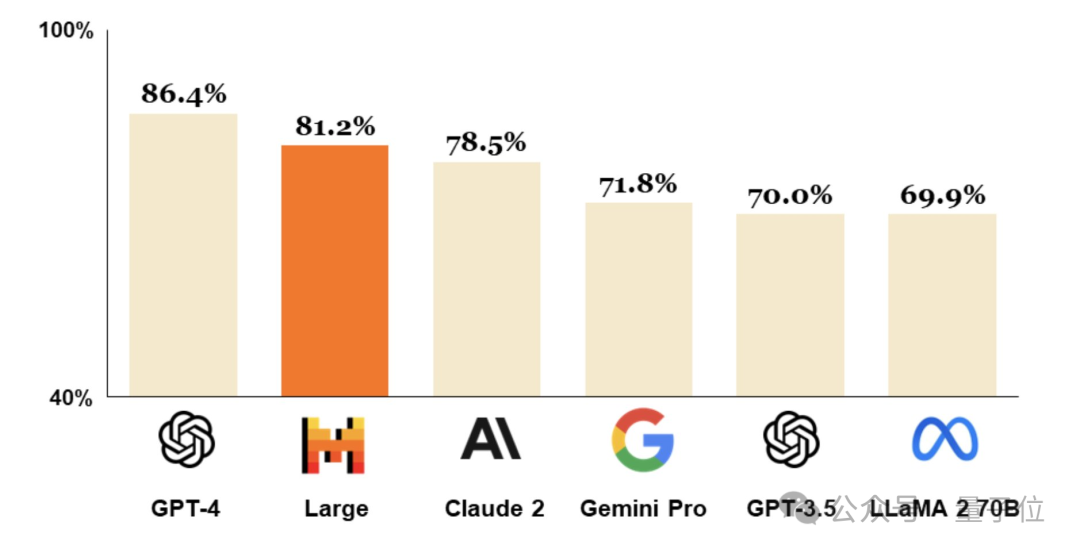

成立仅9个月,法国Mistral AI拿出仅次于GPT-4的大模型。

2月26日,总部位于巴黎的人工智能公司Mistral AI发布尖端文本生成模型Mistral Large。该模型达到了顶级的推理能力,可用于复杂的多语言推理任务,包括文本理解、转换和代码生成。

大模型内卷时代,也不断有人跳出来挑战Transformer的统治地位,RWKV最新发布的Eagle 7B模型登顶了多语言基准测试,同时成本降低了数十倍