AI Agent 工程化,本质是数据库系统设计

AI Agent 工程化,本质是数据库系统设计最近半年,我阅读了业界关于 AI Agent 的工程实践:Anthropic 的 Context Engineering 论文、Manus 的工程分享、Cline 的 Memory Bank 设计等。同时自己也一直在做跟 AI Agent 相关的项目,如:Jta[1](开源的翻译 Agent,基于 Agentic Workflow)。

最近半年,我阅读了业界关于 AI Agent 的工程实践:Anthropic 的 Context Engineering 论文、Manus 的工程分享、Cline 的 Memory Bank 设计等。同时自己也一直在做跟 AI Agent 相关的项目,如:Jta[1](开源的翻译 Agent,基于 Agentic Workflow)。

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。

智源研究院(BAAI)、Spin Matrix、乐聚机器人与新加坡南洋理工大学等联合提出了一个全新的终身记忆系统——RoboBrain-Memory。RoboBrain-Memory是全球范围内首个专为全双工、全模态模型设计的终身记忆系统,旨在解决具身智能体在真实世界的复杂交互问题,不仅支持实时音视频中多用户身份识别与关系理解,还能动态维护个体档案与社会关系图谱,从而实现类人的长期个性化交互。

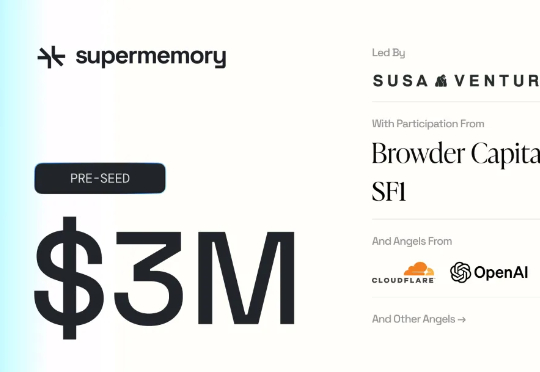

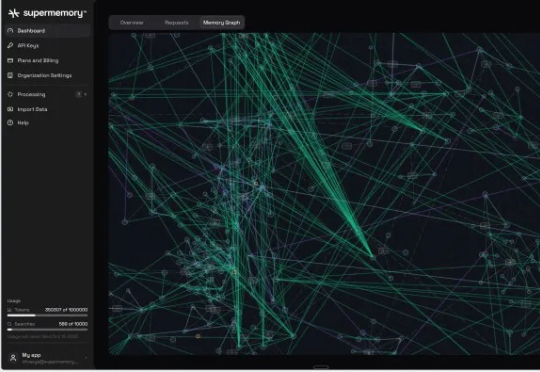

我深入研究了 Supermemory 的技术方案后,发现它和市面上其他记忆解决方案有本质区别。大多数所谓的"记忆"系统,本质上只是一个数据库,提供基本的增删改查功能。你可以保存一个实体,给它设定用户范围,然后查询出来。这很有用,但这只是基础功能,任何数据库都能做到。

想象这样一个场景: 一个AI智能体在帮你处理邮件,一封看似正常的邮件里,却用一张图片的伪装暗藏指令。AI在读取图片时被悄然感染,之后它发给其他AI或人类的所有信息里,都可能携带上这个病毒,导致更大范围的感染和信息泄露。

来自加州大学圣地亚哥分校(UCSD)的华人学者Wanda Hou,与加州大学伯克利分校以及Google Quantum AI合作,在谷歌的Sycamore与Willow超导量子处理器上完成了一次别开生面的实验。

Supermemory 已获得由 Susa Ventures、Browder Capital 和 SF1.vc 领投的 260 万美元种子轮融资。此轮融资还包括 Cloudflare 的 Knecht、谷歌人工智能负责人 Jeff Dean、DeepMind 产品经理 Logan Kilpatrick、Sentry 创始人 David Cramer 以及来自 OpenAI、

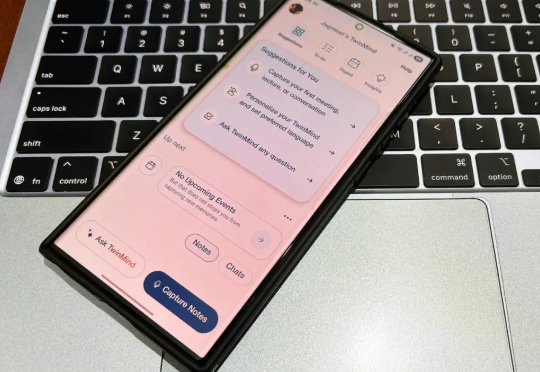

TwinMind的创始人Daniel George在JPMorgan工作时深深体验了这种痛点,当时他每天要参加无数个会议,于是他开发了一个脚本来录制音频、转录文本,并输入到ChatGPT中。神奇的事情发生了,随着时间的推移,ChatGPT开始真正理解他的项目,甚至能生成可用的代码。

AI生成的人物和场景转头就变样,缺乏一致性? nonono,这回不一样了,康康下面的demo! 游戏地图:《塞尔达传说》中的绿色田野

Memory 一直是 AI 产品的技术「痛点」和必争之地。因为决定用户留存,很多有野心的创业者在思考如何借助 AI 长期化时,都会聚焦 AI + Memory 领域。