海外最赚钱的中国AI公司,竟是昆仑万维

海外最赚钱的中国AI公司,竟是昆仑万维根据他们刚发布的 2024 年财报,这家以“天工”大模型在国内引发不少关注的公司,2024 年的海外业务收入达到 51.5 亿元,海外业务收入占比竟然高达 91.0%!这在国内科技公司里,算的上“异类”。

根据他们刚发布的 2024 年财报,这家以“天工”大模型在国内引发不少关注的公司,2024 年的海外业务收入达到 51.5 亿元,海外业务收入占比竟然高达 91.0%!这在国内科技公司里,算的上“异类”。

她21岁创立AI公司,靠5%股份逆风翻盘!Lucy Guo如何从自学编程到辍学创业,超越Taylor Swift,成为全球最年轻的白手起家女亿万富翁?Scale AI最新估值为250亿美元,这也让联合创始人Lucy Guo凭借其股份身价暴涨。

从吸尘器到Optimus:机器人60年间的惊人变化。

Two Heads are Better Than One"(两个脑袋比一个好/双Agent更优)源自英语中的一句古老谚语。MAS-TTS框架的研究者将这一朴素智慧应用到LLM中,创造性地让多个智能体协同工作,如同专家智囊团。

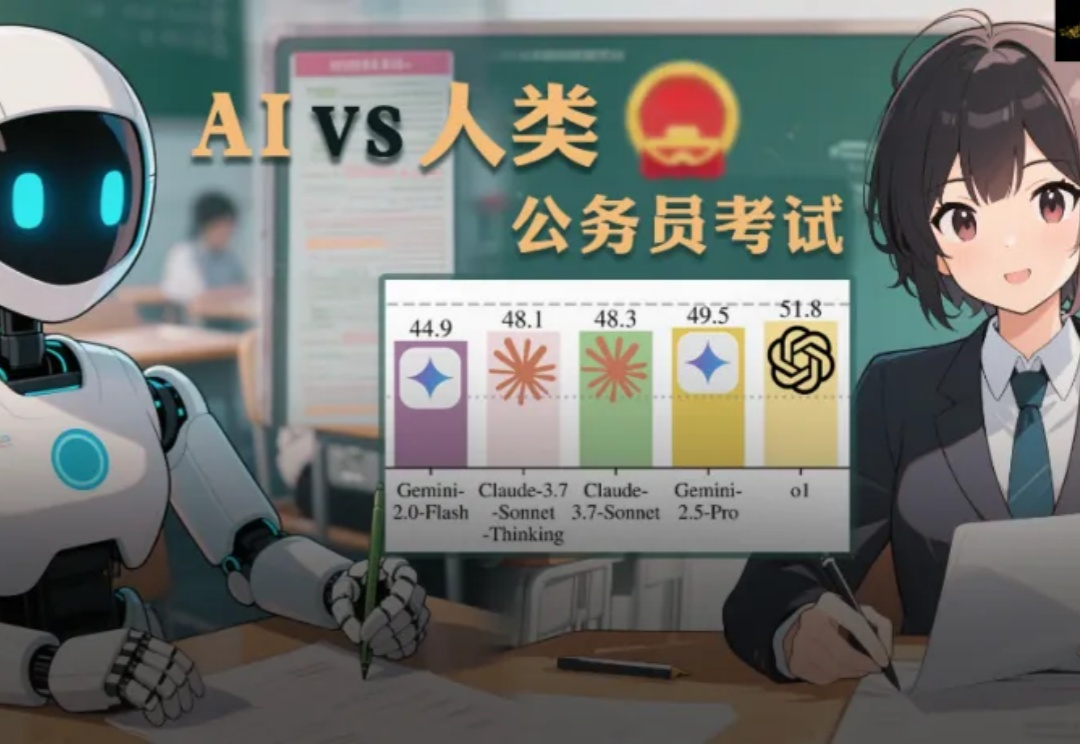

公考行测中的逻辑推理题,是不少考生的噩梦,这次,CMU团队就此为基础,打造了一套逻辑谜题挑战。实测后发现,o1、Gemini-2.5 Pro、Claude-3.7-Sonnet这些顶尖大模型全部惨败!最强的AI正确率也只有57.5%,而人类TOP选手却能接近满分。

大模型聚合平台OpenRouter新推出的Optimus Alpha,已经处理了772亿Token,平均每天超过200亿。并且这个数字还在上升,日Token处理已超过340亿,排名第二,并在Trending榜单上位列第一。

OpenAI前CTO Mira Murati初创公司,正在筹集新融资。20亿美元(折合人民币146亿),还是种子轮!消息称一旦融资完成,Thinking Machines Lab估值将达到超100亿美元。

前 OpenAI 首席技术官 Mira Murati(穆拉蒂)的新 AI 企业 Thinking Machines Lab 迎来了两位重量级顾问:前 OpenAI 首席研究官 Bob McGrew,和曾主导该公司多项突破性创新的前研究员 Alec Radford。

硅谷的每一次脉动,都可能引发全球科技产业的连锁反应。这一次,心跳声来自苹果内部,一个代号为“Mulberry”的重磅AI项目,正悄然将矛头指向价值万亿的数字健康蓝海。传闻中的“AI健康教练”服务,承载着苹果重塑健康生态、深化软硬件协同的巨大野心。这究竟是库克船长驶向新大陆的旗舰,还是又一次在礁石密布的医疗健康领域触礁的风险?

2025 CSRankings新鲜出炉了!CMU稳坐全球第一,中国高校强势崛起,清华摘得第2,上交大与浙大并列第3,北大位居第5。中国在AI领域表现尤为抢眼,上交大、清华、北大、浙大包揽前四,中国科学院与哈工大也跻身全球前十。