逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse

逐个token太慢!大模型原生并行出token,CMU、英伟达新作Multiverse原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。

原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。

Era of Experience 这篇文章中提到:如果要实现 AGI, 构建能完成复杂任务的通用 agent,必须借助“经验”这一媒介,这里的“经验”就是指强化学习过程中模型和 agent 积累的、人类数据集中不存在的高质量数据。

西班牙初创公司 Multiverse Computing 于 6 月 12 日宣布 ,凭借其名为"CompactifAI"的技术优势,已完成 1.89 亿欧元(约合 2.15 亿美元)的巨额 B 轮融资。本轮B 轮融资由 Bullhound Capital 领投,该机构曾投资过 Spotify、Revolut、Delivery Hero、Avito 和 Discord 等企业

1986年,图灵奖得主Fred Brooks在软件工程领域提出了著名的"没有银弹"理论:没有任何一种技术或方法能够独自带来软件工程生产力的数量级提升。近四十年后,这个深刻洞察在AI领域再次得到验证——你是否也曾经历过这样的挫折:

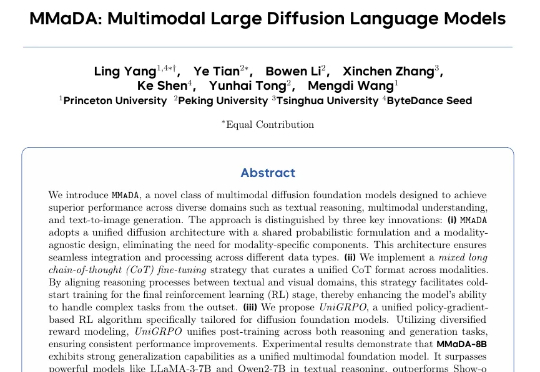

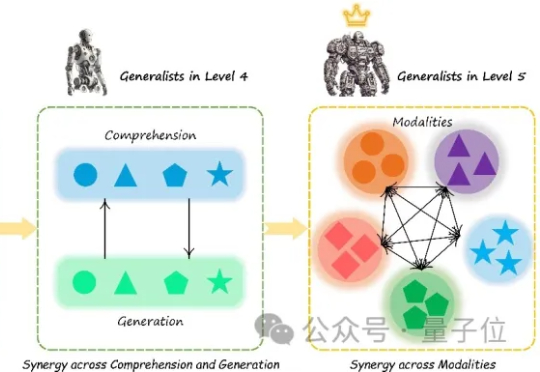

普林斯顿大学与字节 Seed、北大、清华等研究团队合作提出了 MMaDA(Multimodal Large Diffusion Language Models),作为首个系统性探索扩散架构的多模态基础模型,MMaDA 通过三项核心技术突破,成功实现了文本推理、多模态理解与图像生成的统一建模。

多模态大模型(Multimodal Large Language Models, MLLM)正迅速崛起,从只能理解单一模态,到如今可以同时理解和生成图像、文本、音频甚至视频等多种模态。正因如此,在AI竞赛进入“下半场”之际(由最近的OpenAI研究员姚顺雨所引发的共识观点),设计科学的评估机制俨然成为决定胜负的核心关键。

刚刚,全球首个AI多人世界模型开源了!只需一台PC外加1500美元,就能让两个AI智能体在同一个世界中感知、互动、协作。这不仅是AI造梦的一小步,更是AGI创造世界模型的一大步。

以色列 Enigma Labs 团队今天在 X 平台宣称发布全球首款由 AI 生成的多人游戏——Multiverse(多重宇宙)。名字听起来就像漫威出品,玩法也确实够科幻。漂移、撞车,全都同步,操作互相响应,细节还能对上帧数。

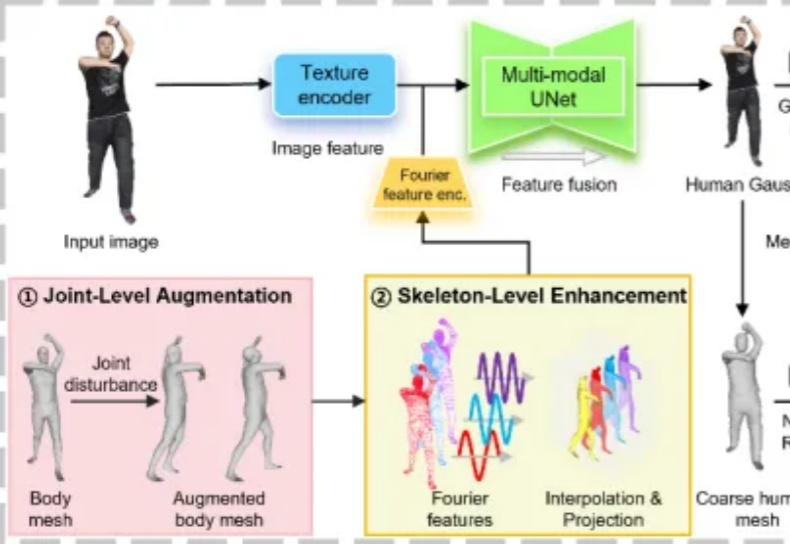

从人体单图变身高保真3D模型,不知道伤害了多少程序猿头发的行业难题,竟然被港科广团队一招破解了!

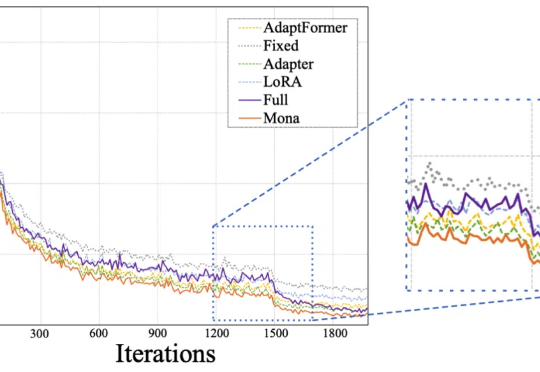

Mona(Multi-cognitive Visual Adapter)是一种新型视觉适配器微调方法,旨在打破传统全参数微调(full fine-tuning)在视觉识别任务中的性能瓶颈。