智源OmniGen2登场,国产多模态图像生成开源!一周狂揽2000星外网爆火

智源OmniGen2登场,国产多模态图像生成开源!一周狂揽2000星外网爆火智源统一图像生成模型OmniGen2发布后,立刻在AI图像生成领域掀起巨响,多模态技术生态进一步打通。才一周,GitHub星标就已经破了2000,X上的话题浏览数直接破数十万。

智源统一图像生成模型OmniGen2发布后,立刻在AI图像生成领域掀起巨响,多模态技术生态进一步打通。才一周,GitHub星标就已经破了2000,X上的话题浏览数直接破数十万。

值得买科技发布了自己的 MCP Server “海纳”,在 AI Agent 时代打造消费领域的基础设施。值得买在数据提供与适配方面有着丰富经验,在电商消费行业有着深刻积累,正是因为有了在垂直领域深耕的行业 know how,所以才有能力向行业提供高质量的、场景相关的数据内容。

6 月 6 日,小红书 hi lab(Humane Intelligence Lab,人文智能实验室)团队首次开源了文本大模型 dots.llm1,采用 MIT 许可证。

此次开源的 Wan2.1-VACE-1.3B 支持 480P 分辨率,Wan2.1-VACE-14B 支持 480P 和 720P 分辨率。通过 VACE,用户可一站式完成文生视频、图像参考生成、局部编辑与视频扩展等多种任务,无需频繁切换模型或工具,真正实现高效、灵活的视频创作体验。

在GitHub狂揽1w+星标的通义万相Wan2.1,又双叒上新了!

Qwen 3还未发布,但已发布的Qwen系列含金量还在上升。2个月前,李飞飞团队基于Qwen2.5-32B-Instruct 模型,以不到50美元的成本训练出新模型 S1-32B,取得了与 OpenAI 的 o1 和 DeepSeek 的 R1 等尖端推理模型数学及编码能力相当的效果。如今,他们的视线再次投向了这个国产模型。

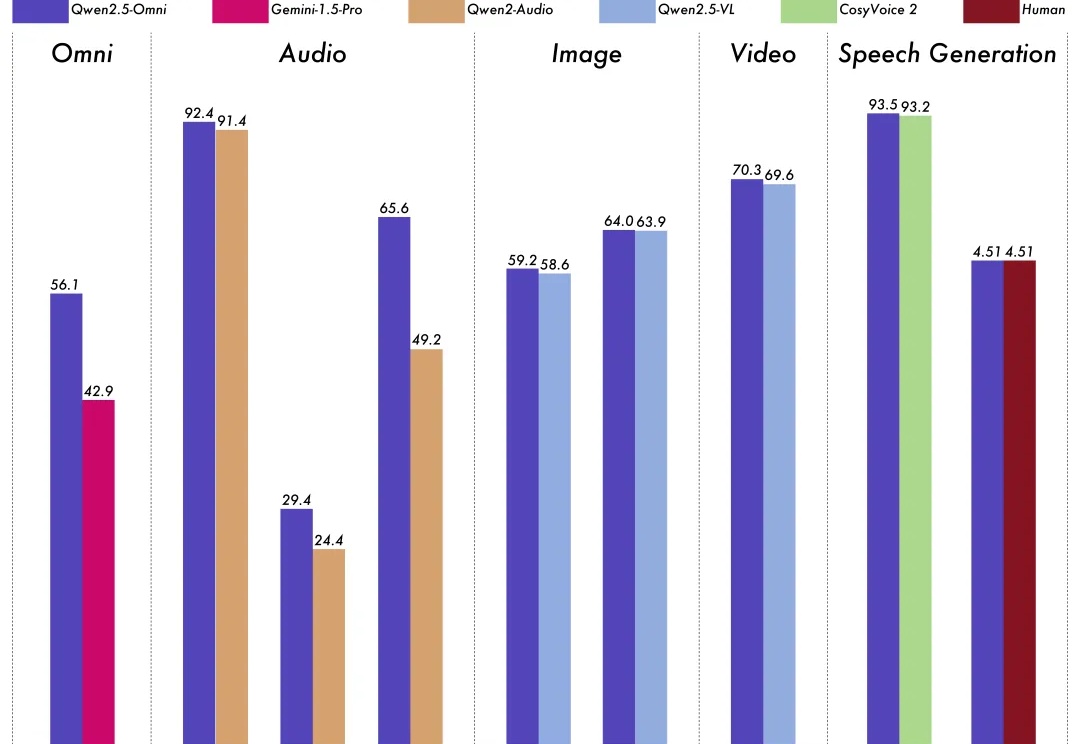

深夜重磅!阿里发布并开源首个端到端全模态大模型——

3 月 27 日凌晨,阿里通义千问团队发布 Qwen2.5-Omni。

就在DeepSeek-V3更新的同一夜,阿里通义千问Qwen又双叒叕一次梦幻联动了——

今天,百图生科宣布开源其领先的xTrimo V2中的蛋白质语言模型xTrimoPGLM,7个不同参数量的模型均已发布在huggingface和github,供全球用户自由获取和使用。xTrimoPGLM是全球首个千亿参数的蛋白质语言模型,性能超越了ESM-2、ProGen2等此前业界领先的蛋白质模型,并在药物分子设计和优化、抗体工程与疫苗开发、酶工程和生物催化剂设计等领域展现出广泛应用前景。