GPT-5首次会推理,OpenAI联创曝AGI秘诀!超临界学习吞噬算力,2045金钱无用?

GPT-5首次会推理,OpenAI联创曝AGI秘诀!超临界学习吞噬算力,2045金钱无用?GPT-5是一个分水岭,终于学会了「推理」。联创Greg Brockman最新访谈畅谈了OpenAI AGI之路,未来AI可以做到边用边学,在超临界模式下推导出N阶后果。

GPT-5是一个分水岭,终于学会了「推理」。联创Greg Brockman最新访谈畅谈了OpenAI AGI之路,未来AI可以做到边用边学,在超临界模式下推导出N阶后果。

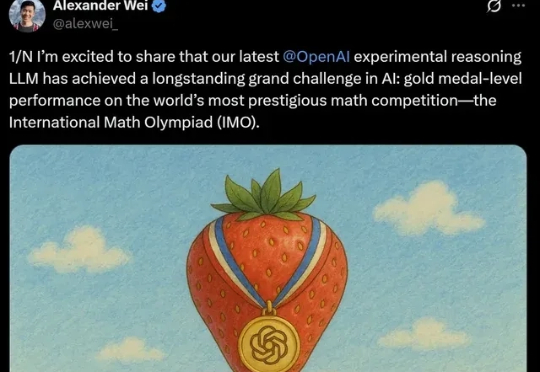

自GPT-2以来,大模型的整体架构虽然未有大的变化,但从未停止演化的脚步。借OpenAI开源gpt-oss(120B/20B),Sebastian Raschka博士将我们带回硬核拆机现场,回溯了从GPT-2到gpt-oss的大模型演进之路,并将gpt-oss与Qwen3进行了详细对比。

奥特曼在一次晚宴上勾勒出宏大愿景——从颠覆搜索与社交,到斥资数万亿打造数据中心和全新AI硬件,甚至探索脑机接口。他强调AI正处在类似互联网泡沫的关键时刻,但其潜力无可比拟。

今年 6 月,The Browser Company 向 Arc 用户开放了浏览器 Dia 的 Beta 测试。上个月,Perplexity 新推出了自己的 AI 原生浏览器 Comet,随后 OpenAI 也宣布计划在未来几周发布浏览器。

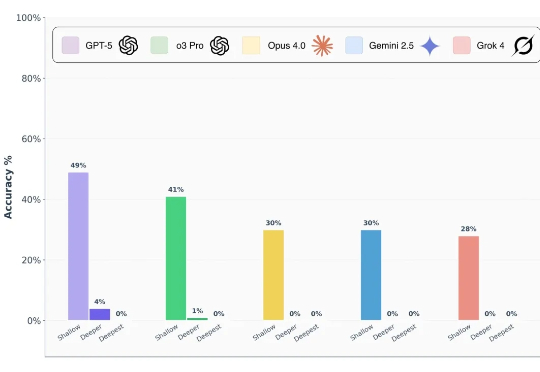

前沿 AI 模型真的能做到博士级推理吗? 前段时间,谷歌、OpenAI 的模型都在数学奥林匹克(IMO)水平测试中达到了金牌水准,这样的表现让人很容易联想到 LLM 是不是已经具备了解决博士级科研难题的推理能力?

给 Sam 的专业建议:直播选人要小心。 大家都是老朋友,在新 Lab 聚首了。

在OpenAI内部,有一个被称为北极星的梦想:让AI成为陪伴每个人一生的良师益友,从而实现真正的教育公平。OpenAI将ChatGPT视为一个致力于弥合教育鸿沟、赋能全球6亿用户的学习平台。

OpenAI 在 AI 领域引领了一波又一波浪潮,想必很多人好奇,这些创新背后的研究人员是如何通过面试的? 尤其是现在,OpenAI 已经成为全球最受瞩目的 AI 公司之一,吸引了无数顶尖人才投递简历。想要加入这个团队,着实不容易。

GPT-5一上线,用户瞬间破防——太冷漠,太爹味,还我GPT-4o!就在刚刚,奥特曼彻底滑跪了,宣布GPT-4o满血复活,重回默认模型宝座。从曾经的遭人唾弃,到今日的白月光回归,ChatGPT的用户们给奥特曼结结实实上了一课。

网友在推特上爆料,一位Mistral离职女员工群发邮件,直指公司多项黑幕。其中最劲爆的就是:Mistral最新模型疑似直接蒸馏自DeepSeek,却对外包装成RL成功案例,并刻意歪曲基准测试结果。