18.5万美元设计大战:AI vs 无代码,谁才是未来?

18.5万美元设计大战:AI vs 无代码,谁才是未来?昨天,两位独立开发者上演了一场现场设计大战: Brett Williams,Webflow老司机,通过他的网页设计工作室Designjoy年入100万+美元 Henrik Westerlund,19岁营销专业辍学生,来自Lovable,一款通过文本提示生成完整功能网页应用的AI产品

昨天,两位独立开发者上演了一场现场设计大战: Brett Williams,Webflow老司机,通过他的网页设计工作室Designjoy年入100万+美元 Henrik Westerlund,19岁营销专业辍学生,来自Lovable,一款通过文本提示生成完整功能网页应用的AI产品

AI智能体有自己的交流方式。

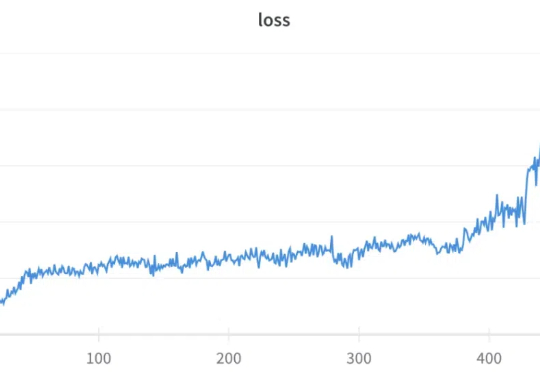

GRPO(Group Relative Policy Optimization)是 DeepSeek-R1 成功的基础技术之一,我们之前也多次报道过该技术,比如《DeepSeek 用的 GRPO 占用大量内存?有人给出了些破解方法》。

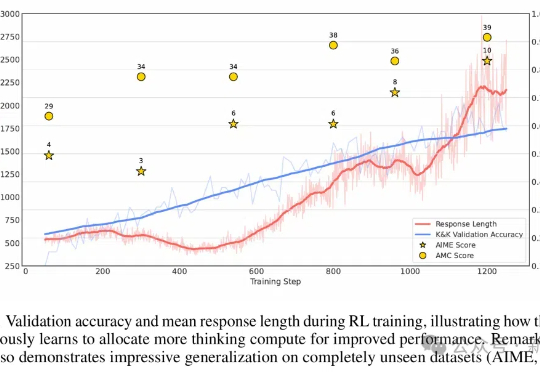

本文深入解析一项开创性研究——"Logic-RL: Unleashing LLM Reasoning with Rule-Based Reinforcement Learning",该研究通过基于规则的强化学习技术显著提升了语言模型的推理能力。微软亚洲的研究团队受DeepSeek-R1成功经验的启发,利用结构化的逻辑谜题作为训练场,为模型创建了一个可以系统学习和改进推理技能的环境。

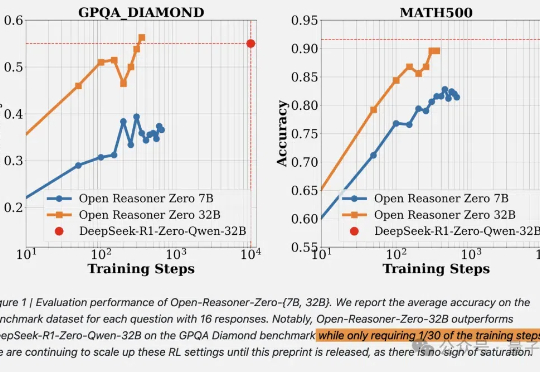

DeepSeek啥都开源了,就是没有开源训练代码和数据。现在,开源RL训练方法只需要用1/30的训练步骤就能赶上相同尺寸的DeepSeek-R1-Zero蒸馏Qwen。

不到10美元,3B模型就能复刻DeepSeek的顿悟时刻了?来自荷兰的开发者采用轻量级的RL算法Reinforce-Lite,把复刻成本降到了史上最低!同时,微软亚研院的一项工作,也受DeepSeek-R1启发,让7B模型涌现出了高级推理技能。

世界模型(World Model)作为近年来机器学习和强化学习的研究热点,通过建立智能体对其所处环境的一种内部表征和模拟,能够加强智能体对于世界的理解,进而更好地进行规划和决策。

经常有群友问我有没有什么把视频修复的工具。而我过去最推荐的,也是我心中目前最牛逼的视频修复工具,自然就是TopazVideoAI了。但,斗转星移,日月如梭,现在已经2025年了。我们在进化,而Topaz他们家,自然也再进化,前两天他们家又整了个新活,搞了个叫Starlight的新东西。

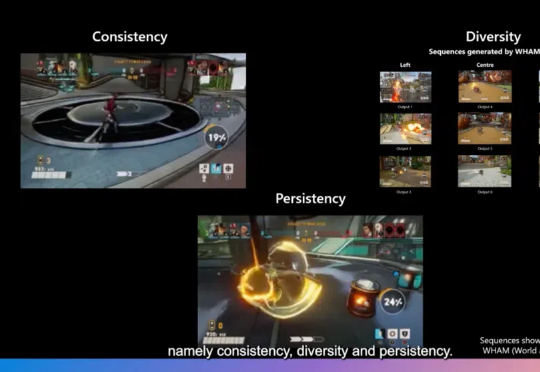

游戏开发不仅需要生成新颖的内容,更需要在保持游戏世界一致性、多样性和用户修改持续性方面达到高度平衡。近日,一篇发表在Nature上的研究论文World and Human Action Models towards Gameplay Ideation揭示了如何利用生成式AI模型推动游戏玩法创意的生成。

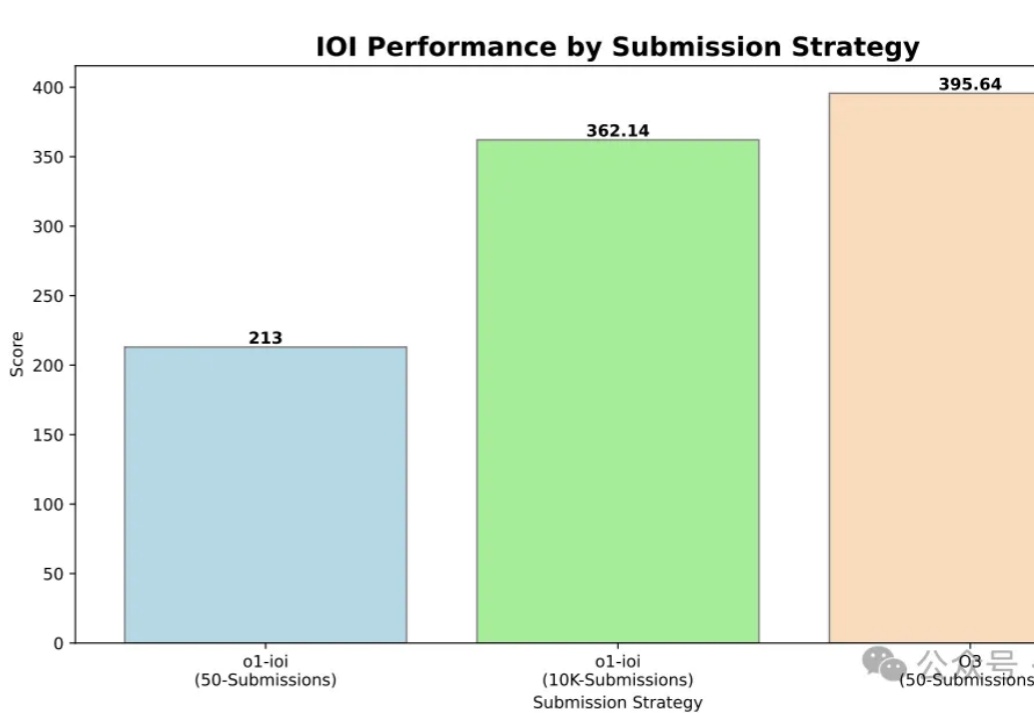

IOI 2024金牌,OpenAI o3轻松高分拿下!