像人类一样在批评中学习成长,1317条评语让LLaMA2胜率飙升30倍

像人类一样在批评中学习成长,1317条评语让LLaMA2胜率飙升30倍有的大模型对齐方法包括基于示例的监督微调(SFT)和基于分数反馈的强化学习(RLHF)。然而,分数只能反应当前回复的好坏程度,并不能明确指出模型的不足之处。相较之下,我们人类通常是从语言反馈中学习并调整自己的行为模式。

有的大模型对齐方法包括基于示例的监督微调(SFT)和基于分数反馈的强化学习(RLHF)。然而,分数只能反应当前回复的好坏程度,并不能明确指出模型的不足之处。相较之下,我们人类通常是从语言反馈中学习并调整自己的行为模式。

过去几个月中,随着 GPT-4V、DALL-E 3、Gemini 等重磅工作的相继推出,「AGI 的下一步」—— 多模态生成大模型迅速成为全球学者瞩目的焦点。

这两天Steam上突然出现了一款爆火的现象级游戏《幻兽帕鲁(Palworld)》。发售没几天就直接冲到了Steam史上玩家在线排行榜第2,超过了CS2等一众经典老游戏。

2013 年创立的科技产品发现平台 Product Hunt 如今已经成为发现新的 AI 产品的主要平台,里面聚集了大量 Early Adopters 种子用户。Notion、Framer 和 Loom 等等产品都通过 Product Hunt 成功实现了冷启动。

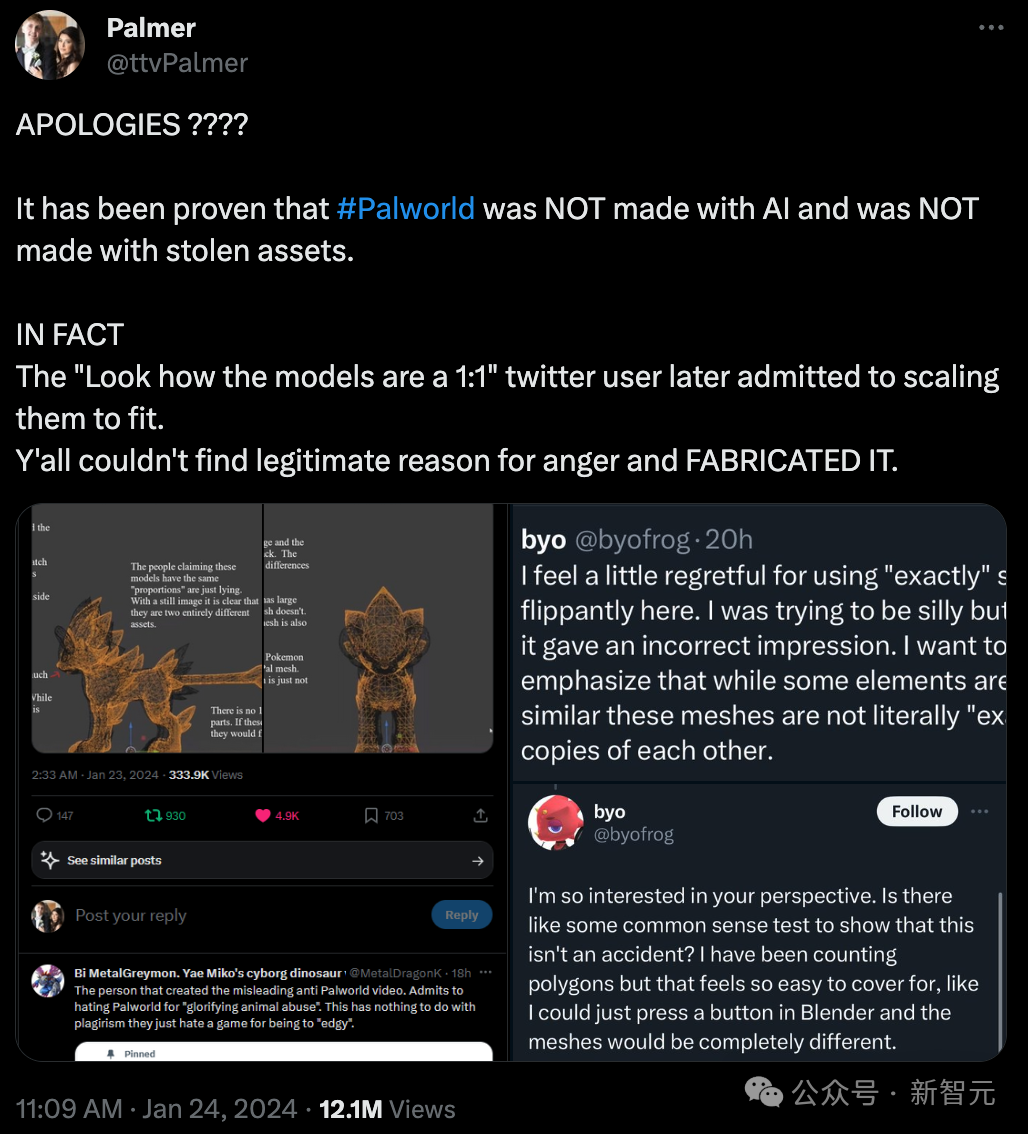

人工智能的反馈(AIF)要代替 RLHF 了?

大模型在极大的提高工作效率的同时,也将一些隐患带入到人们的生活中,比如擦边内容、暴力诱导、种族歧视、虚假和有害信息等。

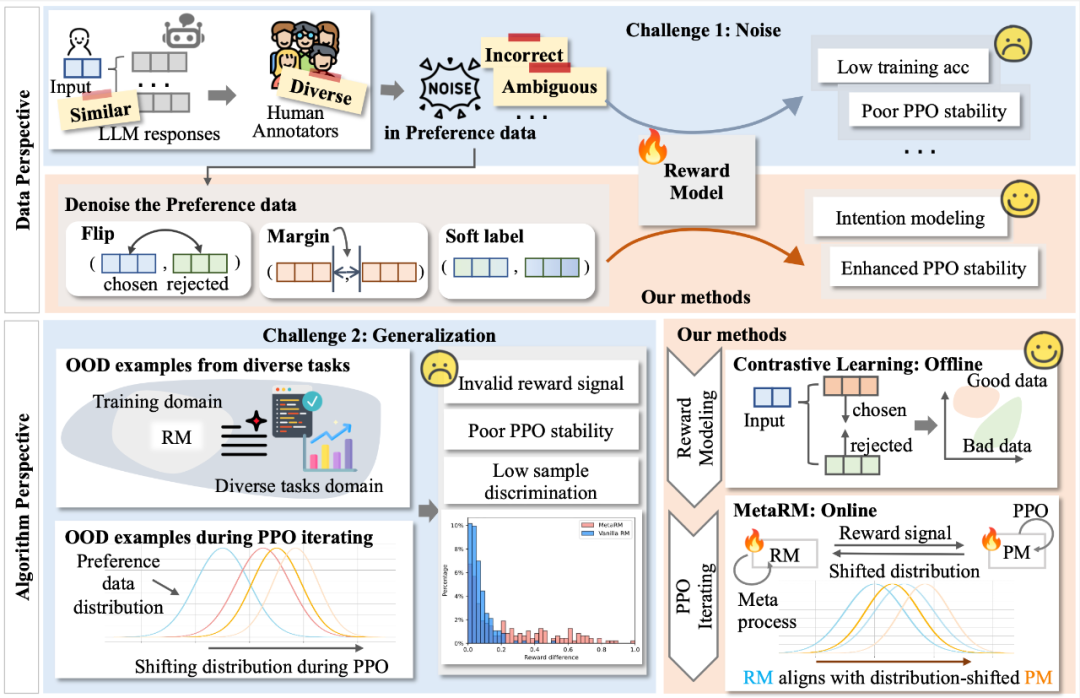

复旦团队进一步挖掘 RLHF 的潜力,重点关注奖励模型(Reward Model)在面对实际应用挑战时的表现和优化途径。

微软和 AI 初创公司 Inworld 达成合作,将引入基于 AI 的“角色引擎”及“Copilot 助理”,为开发者提供一系列开发工具,以创建更真实、动态的 NPC。

OpenAI认为,未来十年来将诞生超过人类的超级AI系统。但是,这会出现一个问题,即基于人类反馈的强化学习技术将终结。

多模态技术是 AI 多样化场景应用的重要基础,多模态大模型(MLLM)展现出了优秀的多模态信息理解和推理能力,正成为人工智能研究的前沿热点。上周,谷歌发布 AI 大模型 Gemini,据称其性能在多模态任务上已全面超越 OpenAI 的 GPT-4V,再次引发行业的广泛关注和热议。