OpenAI怒斥Scaling撞墙论!o1已产生推理直觉潜力巨大

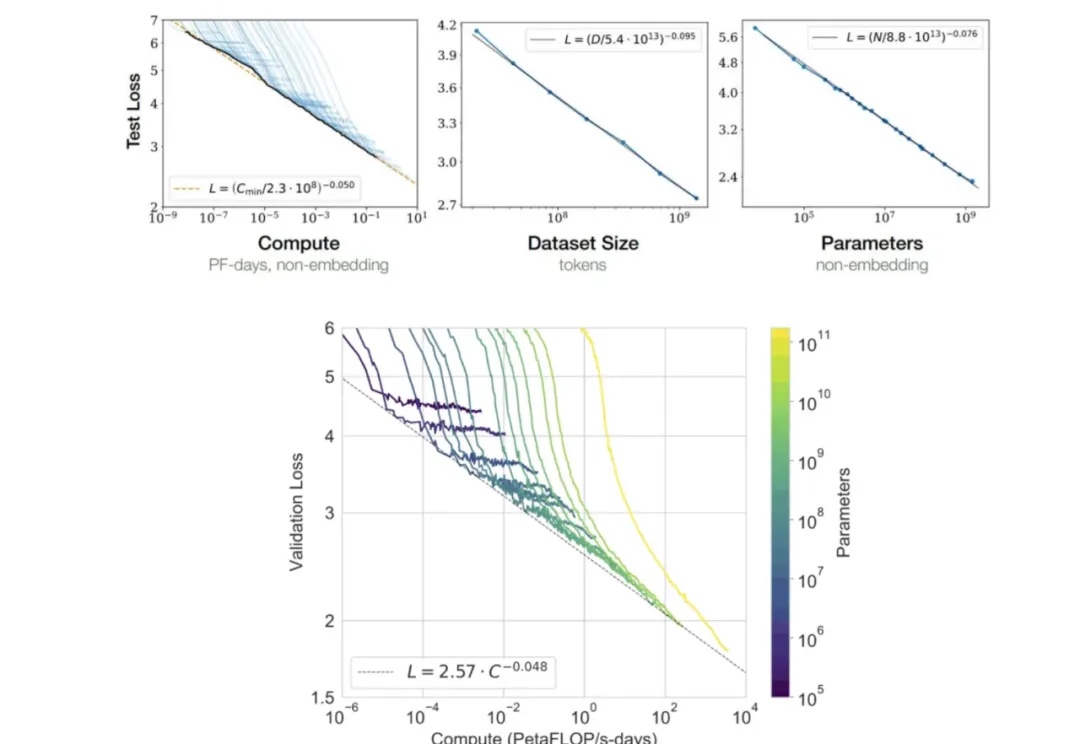

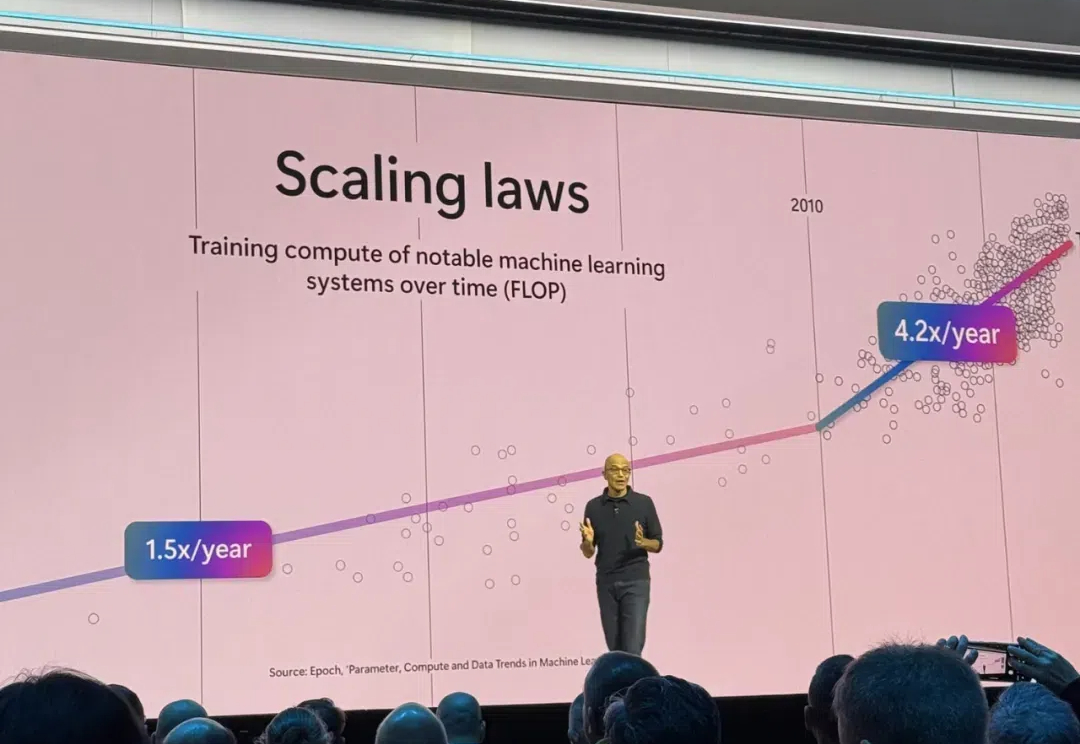

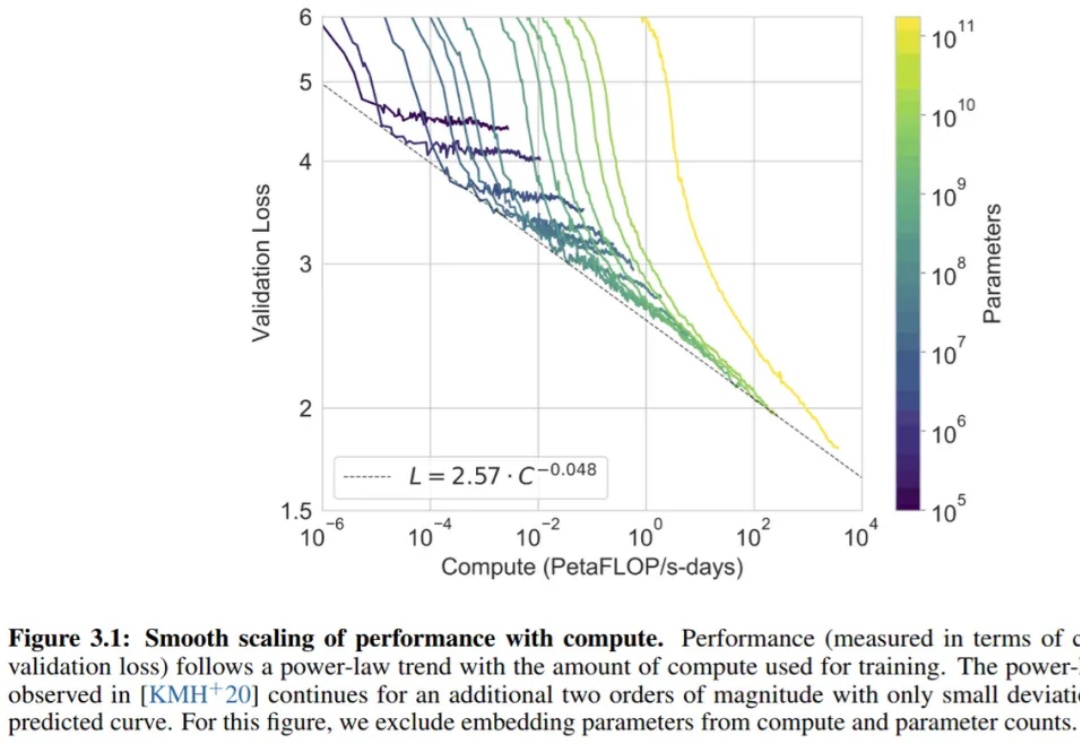

OpenAI怒斥Scaling撞墙论!o1已产生推理直觉潜力巨大Scaling Law撞墙了吗?OpenAI高级研究副总裁Mark Chen正式驳斥了这一观点。他表示,OpenAI已经有o系列和GPT系列两个模型,来让模型继续保持Scaling。

Scaling Law撞墙了吗?OpenAI高级研究副总裁Mark Chen正式驳斥了这一观点。他表示,OpenAI已经有o系列和GPT系列两个模型,来让模型继续保持Scaling。

11 月 23 日,香港科技大学举行了今年度的学位颁授典礼。英伟达创始人和 CEO 黄仁勋又新增一个荣誉工程学博士头衔,与他一同获得荣誉博士学位的还有著名影星梁朝伟、2013 年诺贝尔化学奖得主 Michael Levitt、菲尔兹奖得主 David Mumford。

Claude 3.5 Sonnet 应该是目前公认综合能力最好的基础模型。

Scaling Law撞墙,扩展语言智能体的推理时计算实在太难了!破局之道,竟是使用LLM作为世界模型?OSU华人团队发现,使用GPT-4o作为世界模型来支持复杂环境中的规划,潜力巨大。

Powerful AI 预计会在 2026 年实现,足够强大的 AI 也能够将把一个世纪的科研进展压缩到 5-10 年实现(“Compressed 21st Century”),在他和 Lex Fridman 的最新对谈中,Dario 具体解释了自己对于 Powerful AI 可能带来的机会的理解,以及 scaling law、RL、Compute Use 等模型训练和产品的细节进行了分享

在2024年的AI领域,我们正在见证一个有趣的转折。 OpenAI的进展节奏明显放缓,GPT-5迟迟未能问世,“Scaling Law”成了天方夜谭,即便是年初震撼业界的视频生成模型Sora,也未能如期实现“全面开放”的承诺。

近期,围绕Scaling Law的讨论不绝于耳。

哈佛斯坦福MIT等机构首次提出「精度感知」scaling law,揭示了精度、参数规模、数据量之间的统一关系。数据量增加,模型对量化精度要求随之提高,这预示着AI领域低精度加速的时代即将结束!

继Anthropic之后,OpenAI也要接管人类电脑了?!

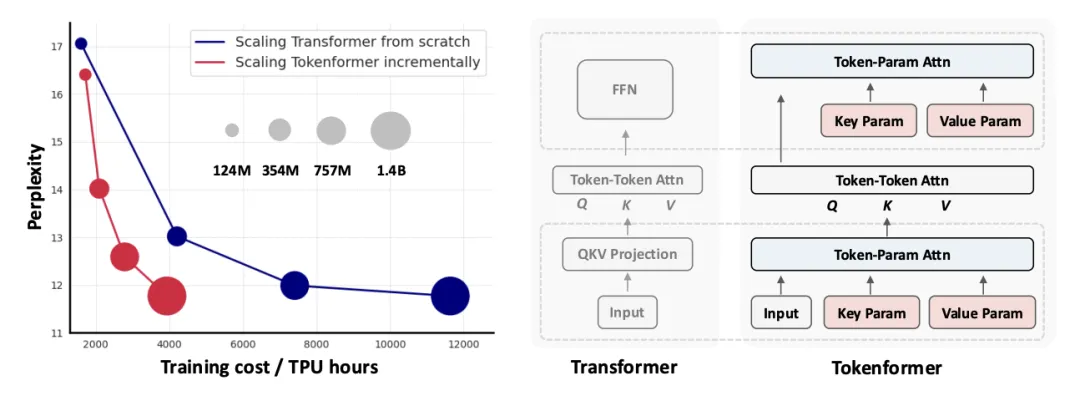

新一代通用灵活的网络结构 TokenFormer: Rethinking Transformer Scaling with Tokenized Model Parameters 来啦!