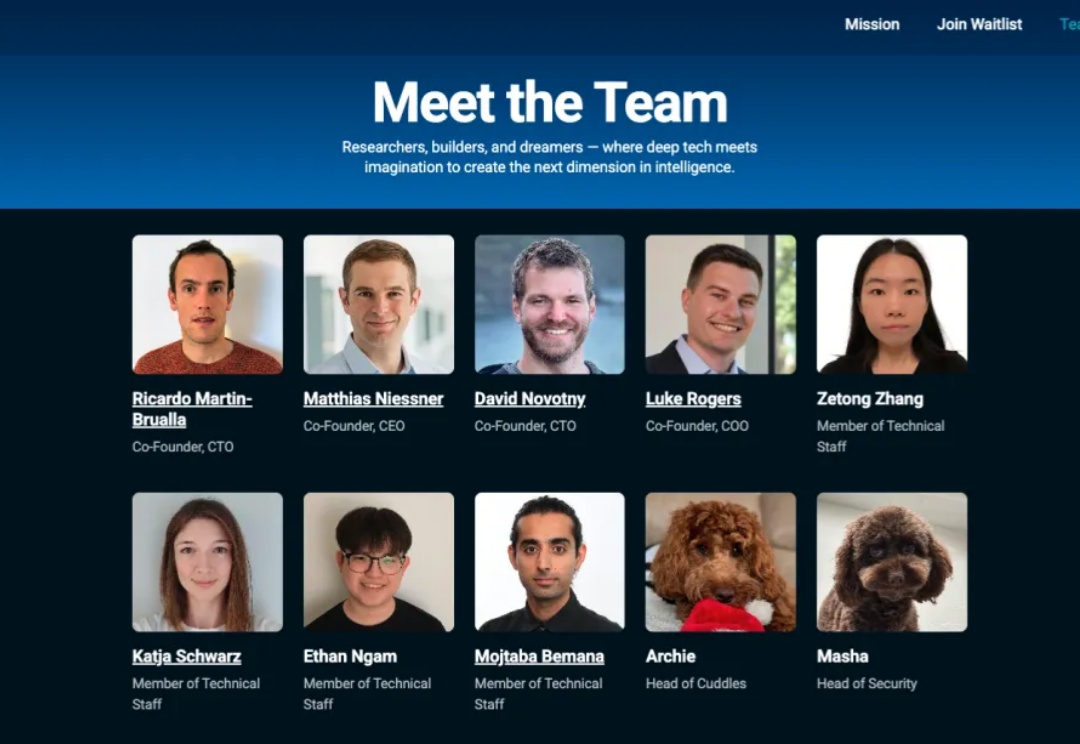

速递|破解3D生成取代CAD?SpAItial获1300万美金种子资金,前Synthesia联创集结Meta谷歌豪华技术团队

速递|破解3D生成取代CAD?SpAItial获1300万美金种子资金,前Synthesia联创集结Meta谷歌豪华技术团队从OpenAI 的 4o 到 Stable Diffusion,能够根据文本提示生成逼真图像的 AI 基础模型如今已比比皆是。相比之下,能够仅凭文本提示就生成完整、连贯的 3D 在线环境的基础模型才刚刚崭露头角。

从OpenAI 的 4o 到 Stable Diffusion,能够根据文本提示生成逼真图像的 AI 基础模型如今已比比皆是。相比之下,能够仅凭文本提示就生成完整、连贯的 3D 在线环境的基础模型才刚刚崭露头角。

AI 初创公司 Stability AI 发布了名为 Stable Audio Open Small 的“立体声”音频生成 AI 模型,该公司宣称这是市场上速度最快的模型,且效率高到足以在智能手机上运行。

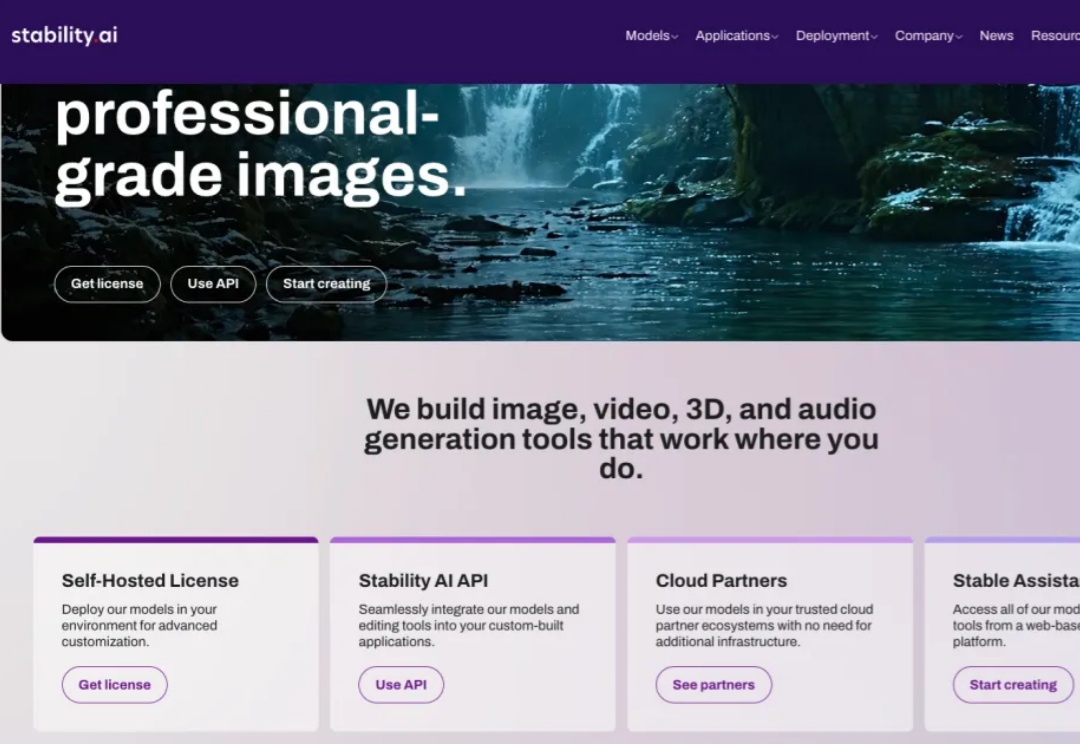

流匹配模型因其坚实的理论基础和在生成高质量图像方面的优异性能,已成为图像生成(Stable Diffusion, Flux)和视频生成(可灵,WanX,Hunyuan)领域最先进模型的训练方法。然而,这些最先进的模型在处理包含多个物体、属性与关系的复杂场景,以及文本渲染任务时仍存在较大困难。

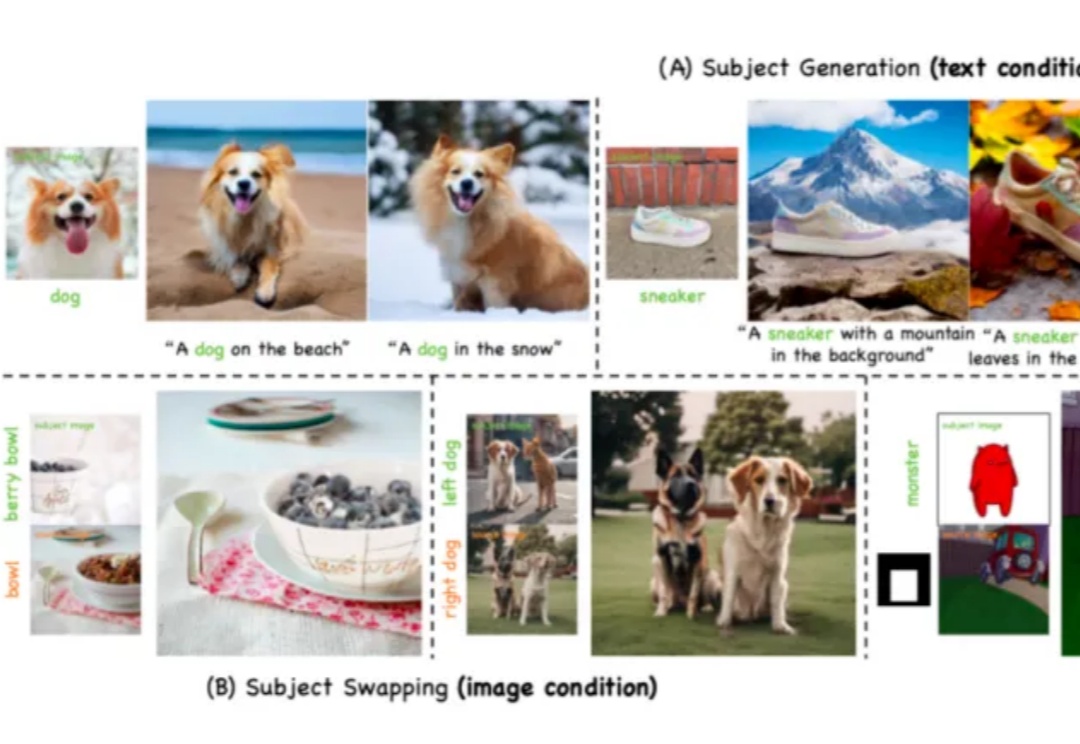

近年来,生成式人工智能(Generative AI)技术的突破性进展,特别是文本到图像 T2I 生成模型的快速发展,已经使 AI 系统能够根据用户输入的文本提示(prompt)生成高度逼真的图像。从早期的 DALL・E 到 Stable Diffusion、Midjourney 等模型,这一领域的技术迭代呈现出加速发展的态势。

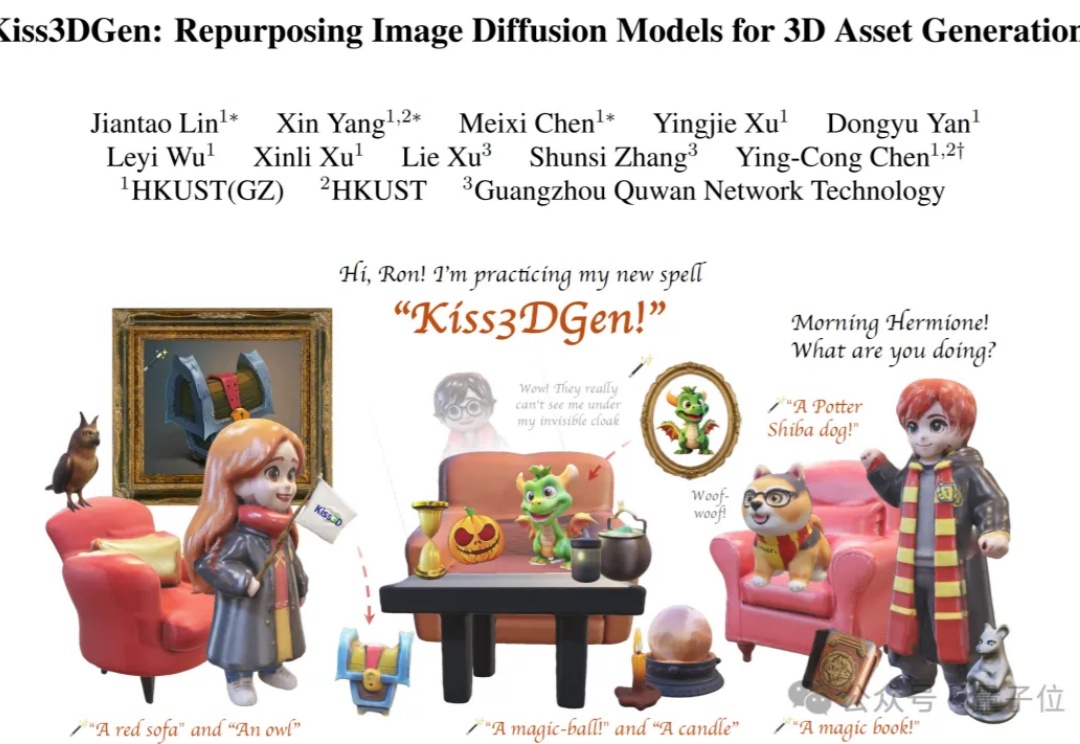

在Stable Diffusion当中,只需加入一个LoRA就能根据图像创建3D模型了?

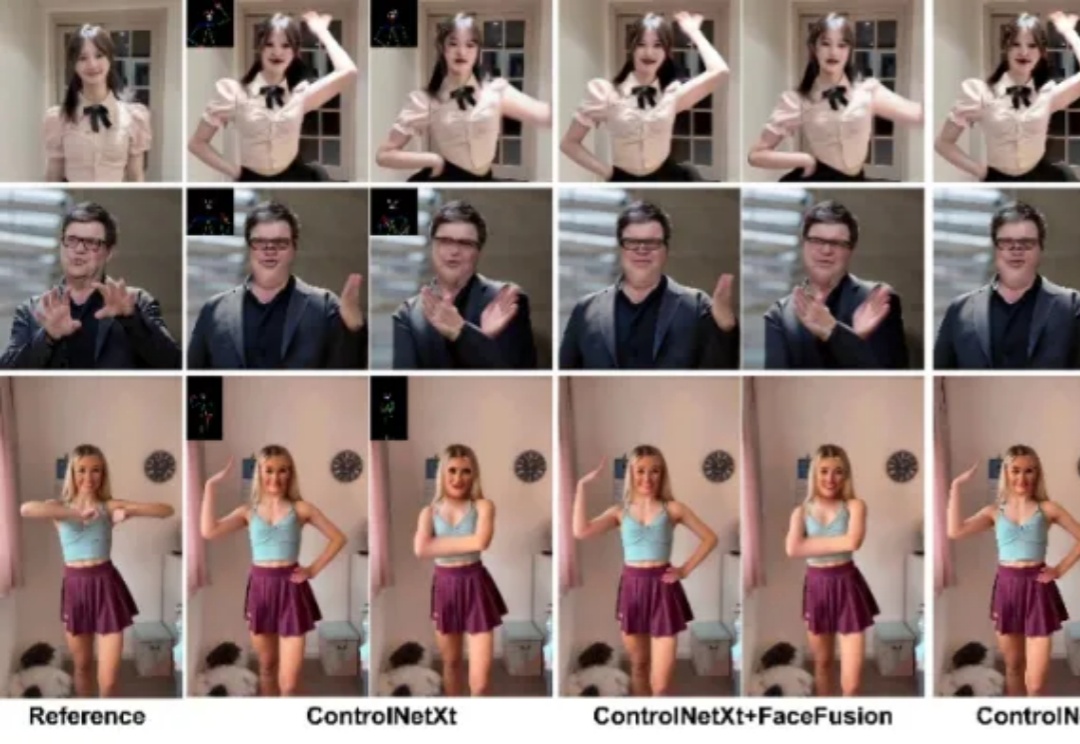

近年来,扩散模型在图像与视频合成领域展现出强大能力,为图像动画技术的发展带来了新的契机。特别是在人物图像动画方面,该技术能够基于一系列预设姿态驱动参考图像,使其动态化,从而生成高度可控的人体动画视频。

文本到图像(Text-to-Image, T2I)生成任务近年来取得了飞速进展,其中以扩散模型(如 Stable Diffusion、DiT 等)和自回归(AR)模型为代表的方法取得了显著成果。然而,这些主流的生成模型通常依赖于超大规模的数据集和巨大的参数量,导致计算成本高昂、落地困难,难以高效地应用于实际生产环境。

Stability AI 发布了一款新 AI 模型——Stable Virtual Camera,该公司宣称该模型能将 2D 图像转化为,具有真实深度和视角的“沉浸式”视频。

这位曾用代码构建童话世界的工程师,被困在了由 AI 工具引发的一场噩梦里。

这次不是卷参数、卷算力,而是卷“跨界学习”——