别再手动编排工作流了,AI 能做的比你更好!

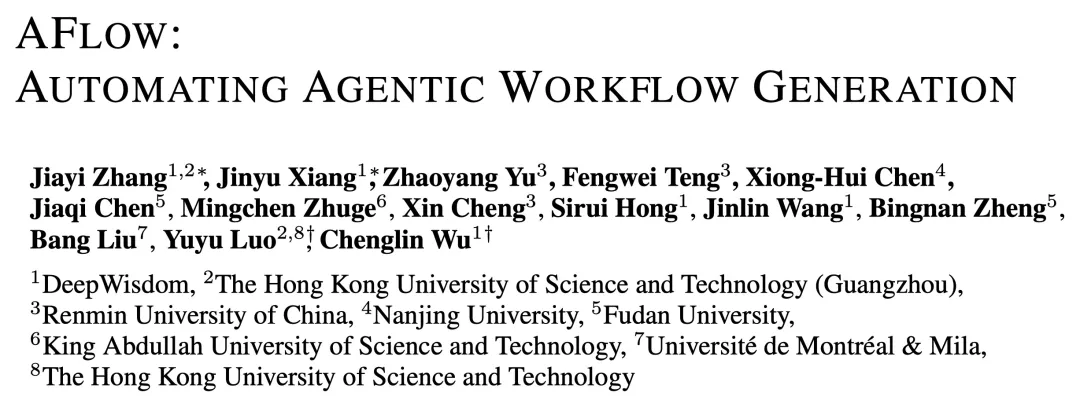

别再手动编排工作流了,AI 能做的比你更好!现在 workflow 也有了自己的智能助手啦! MetaGPT 开源的 AFLOW 可以完全自动地构建和优化 workflow 了!

现在 workflow 也有了自己的智能助手啦! MetaGPT 开源的 AFLOW 可以完全自动地构建和优化 workflow 了!

对于 LLM 从业者来说,让 LLM 落地应用并发挥作用需要手动构建并反复调试 Agentic Workflow,这无疑是个繁琐过程,一遍遍修改相似的代码,调试 prompt,手动执行测试并观察效果,并且换个 LLM 可能就会失效,有高昂的人力成本。许多公司甚至专职招聘 Prompt Engineer 来完成这一工作。

AI 智能体可以设计 AI 吗?

如今,人们选择餐厅,多半会打开app搜索一番,再看看排名。然而美国奥斯汀的一家餐厅Ethos的存在证实这种选择机制多么不可靠。Ethos在社交媒体instagram宣称是当地排名第一的餐厅,拥有7万余粉丝。

无聊的人类会吸电子猫吗 秋天到了,《哈利波特》重映了,万圣节快来了,魔法的气息蠢蠢欲动了。 最近,一只 AI 生成的猫从海外火到国内,在 X、Instagram、小红书都拥有极高的人气。

在 TikTok 上,Daze 最受欢迎的视频已被观看了 800 万次。在TikTok和Instagram上,旨在针对 Z 世代的新消息应用背后的初创公司已获得约 4800 万的总观看次数。

「多智能体系统」是人工智能领域最热门的流行词之一,也是开源框架 MetaGPT 、 Autogen 等研究的焦点。 但是,多智能体系统就一定是完美的吗 近日,来自卡内基梅隆大学的副教授 Graham Neubig 在文章《Don't Sleep on Single-agent Systems》中强调了单智能体系统也不可忽视。

准确的统计数据、时效性强的信息,一直是大语言模型产生幻觉的重灾区。谷歌在近日推出了自己筹划已久的大型数据库Data Commons,以及在此基础上诞生的大模型DataGemma。

与 Text2SQL 或 RAG 不同,TAG 充分利用了数据库系统和 LLM 的功能。

Emory大学的研究团队提出了一种创新的方法,将大语言模型(LLM)在文本图(Text-Attributed Graph, 缩写为TAG)学习中的强大能力蒸馏到本地模型中,以应对文本图学习中的数据稀缺、隐私保护和成本问题。通过训练一个解释器模型来理解LLM的推理过程,并对学生模型进行对齐优化,在多个数据集上实现了显著的性能提升,平均提高了6.2%。