NeurIPS 2023精选回顾:大模型最火,清华ToT思维树上榜

NeurIPS 2023精选回顾:大模型最火,清华ToT思维树上榜美国著名科技播客Latent Space对于刚刚过去的NeurIPS 2023上的精彩论文进行了一个全面的总结,回顾了多篇优秀论文,虽然没有获奖,但同样值得学界关注。

美国著名科技播客Latent Space对于刚刚过去的NeurIPS 2023上的精彩论文进行了一个全面的总结,回顾了多篇优秀论文,虽然没有获奖,但同样值得学界关注。

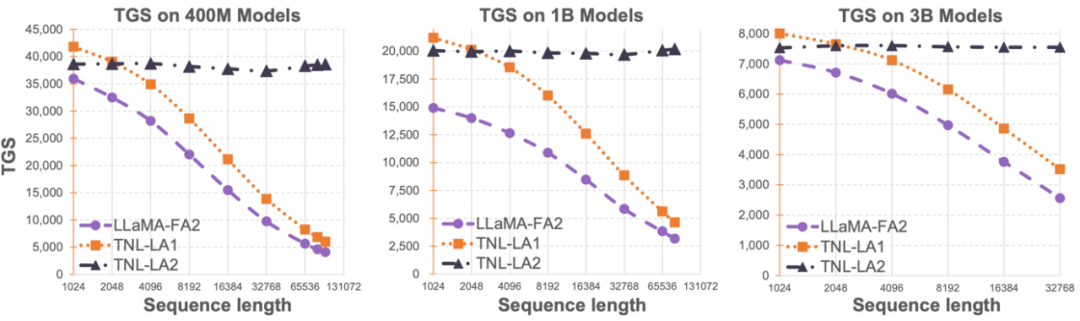

Lightning Attention-2 是一种新型的线性注意力机制,让长序列的训练和推理成本与 1K 序列长度的一致。

一款国产编程神器,秒杀了微软GitHub Copilot。比GitHub Copilot快两倍的同时,准确度还提高了约20%。

Hyena处理长序列输入比FlashAttention速度高100倍!最新发布的StripedHyena模型可能成下一代AI架构的新标准?

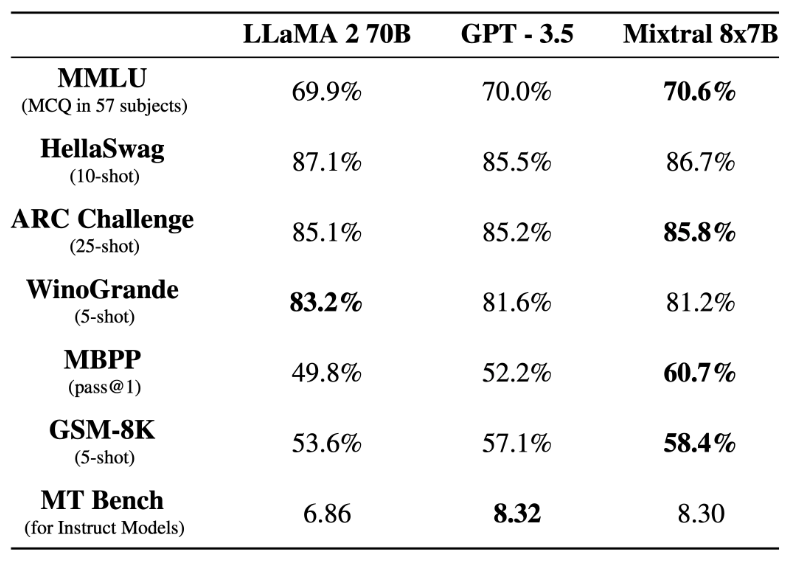

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

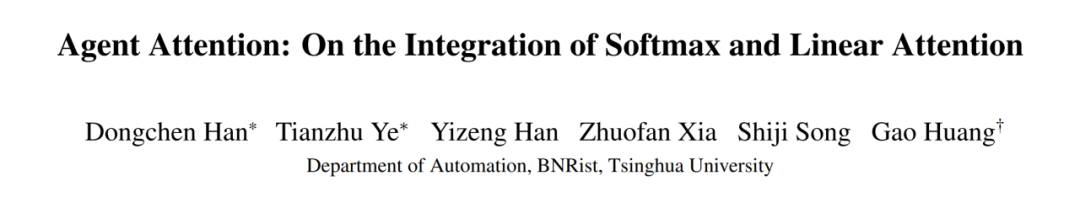

来自清华大学的研究者提出了一种新的注意力范式——代理注意力 (Agent Attention)。

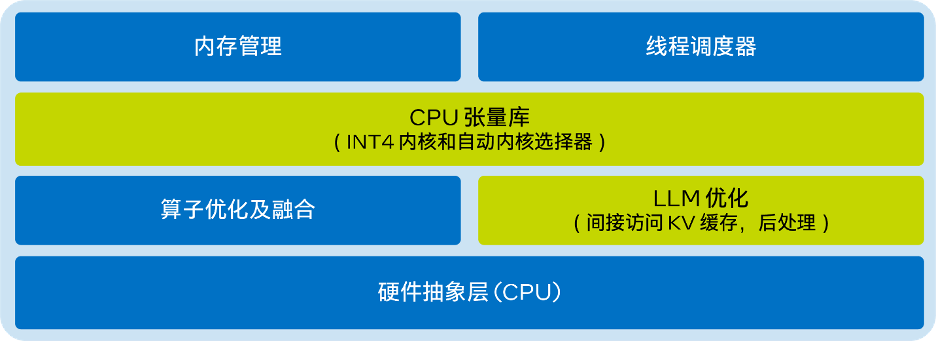

只需不到9行代码,就能在CPU上实现出色的LLM推理性能。英特尔® Extension for Transformer创新工具包中的LLM Runtime为诸多模型显著降低时延,且首个token和下一个token的推理速度分别提升多达40倍和2.68倍,还能满足更多场景应用需求。

前不久,原阿里首席AI科学家贾扬清的一条朋友圈截图四处流传。贾扬清说,他的一个朋友告诉他,某国产大模型不过是LLaMA架构,只是更换了几个变量名而已。 很快有好事者发现,在大模型、数据集开源社区Hugging Face上,就有一位开发者发出了类似质疑:“该模型使用了Meta LLaMA 的架构,只修改个tensor(张量)”。

针对近日零一万物被质疑完全使用 LLaMA 架构,只对两个张量(Tensor)名称做修改,李开复在朋友圈进行了回应。

知名科学出版机构施普林格·自然(Springer Nature)近日发布信息称,集团和作者近期又通过生成式AI共同创造出一本全新的学术书籍——德文图书《GPT在财务、合规和审计中的应用》(Einsatzmöglichkeiten von GPT in Finance and Compliance und Audit)