Meta「轻量级」KernelLLM颠覆GPU内核生成,8B参数碾压GPT-4o

Meta「轻量级」KernelLLM颠覆GPU内核生成,8B参数碾压GPT-4oMeta推出KernelLLM,这个基于Llama 3.1微调的8B模型,竟能将PyTorch代码自动转换为高效Triton GPU内核。实测数据显示,它的单次推理性能超越GPT-4o和DeepSeek V3,多次生成时得分飙升。

Meta推出KernelLLM,这个基于Llama 3.1微调的8B模型,竟能将PyTorch代码自动转换为高效Triton GPU内核。实测数据显示,它的单次推理性能超越GPT-4o和DeepSeek V3,多次生成时得分飙升。

硅谷终极野心:AI+机器人吞噬全球六十万亿美元工资;马斯克、盖茨、Hinton等科技大佬同声预言,白领到蓝领都将被算法与机械手臂取代。这场变革的背后,是提高生活水平的美好愿景,还是少数人掌控生产资料的逐利游戏?

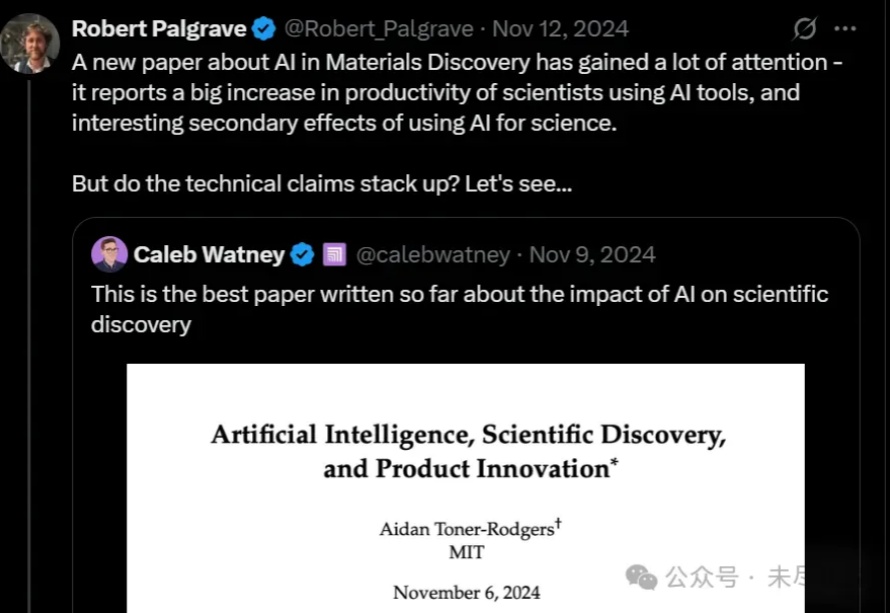

关于MIT博士生Aidan Toner-Rodgers论文造假一事,在AI、经济学、科研、政策和媒体圈子里引起强烈反响,正如它6个月前在相同的圈子里引起轰动一样。

程序员要消失了?AI教父Hinton、诺奖得主Pissarides和英伟达CEO黄仁勋齐声预警:AI正在颠覆编程岗位,「写代码」将变成过去式!最新报告显示,美国超1/4编程职位已消失。大学该不该还教编程?CS还值不值得学?

日前,诺奖得主、AI教父Geoffrey Hinton联合10名前OpenAI员工及其他业内人士联合发表公开信反对OpenAI的重组计划,理由非常直接:OpenAI违背了他们的慈善宗旨,即确保AGI的安全开发和造福人类。

日前,一封公开信拦在了OpenAI的重组之路上。该公开信由诺奖得主、AI教父Geoffrey Hinton联合10名前OpenAI员工及其他业内人士共同发表,要求停止OpenAI的重组计划。

锌刻度从企查查搜索发现,该品牌背后的公司深圳玖柒陆科技有限公司成立于2024年,注册资本仅50万元。 这似乎也就不难理解,为什么第一批体验AI洗头机的消费者要么觉得“鸡肋”,要么发现“洗不干净”。事实上,目前除了AI洗头,近来兴起的应用机器人服务人体的项目还有按摩、艾灸、拉筋、疏通经络等。

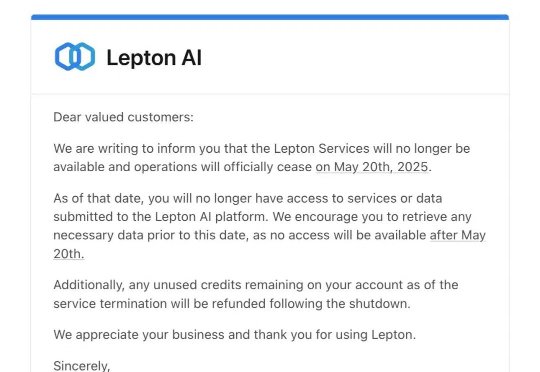

近日,网上曝出 Lepton AI 已通知用户,Lepton 将于 2025 年 5 月 20 日正式停止运营,此后用户将无法再访问 Lepton AI 平台上的服务或提交的数据,建议用户在该日期之前尽快下载或备份所需数据。服务终止时,若用户账户中仍有未使用的积分,官方将会在关停后予以退款处理。

本文对DeepMind两位泰斗级科学家David Silver和Richard Sutton的重磅论文《Welcome to the Era of Experience》进行了深度解读,我将其视为AI发展方向的一份战略瞭望图。

强化学习之父Richard Sutton和DeepMind强化学习副总裁David Silver对我们发出了当头棒喝:如今,人类已经由数据时代踏入经验时代。通往ASI之路要靠RL,而非人类数据!