OpenAI这招太狠!AI从「躲猫猫」到「自爆黑料」,主打一个坦白

OpenAI这招太狠!AI从「躲猫猫」到「自爆黑料」,主打一个坦白随着AI越来越强大并进入更高风险场景,透明、安全的AI显得越发重要。OpenAI首次提出了一种「忏悔机制」,让模型的幻觉、奖励黑客乃至潜在欺骗行为变得更加可见。

随着AI越来越强大并进入更高风险场景,透明、安全的AI显得越发重要。OpenAI首次提出了一种「忏悔机制」,让模型的幻觉、奖励黑客乃至潜在欺骗行为变得更加可见。

Veza 的订阅软件帮助企业了解其员工以及自动化软件任务的 AI Agent对特定客户或公司数据的访问权限,以及他们能对这些数据做什么。ServiceNow 一直在加强其 AI Agent相关的产品,这些产品旨在自动化客户服务和响应IT 帮助台请求等任务。

如果说过去一年里,AI 让开发者生产力翻倍,那么如今它也开始以同样的速度放大风险。 上周,Google 刚刚推出的基于 Gemini 的全新 AI 编码工具 Antigravity,上线不到 24 小时便被一名安全研究员攻破,指出它存在严重的安全Bug。

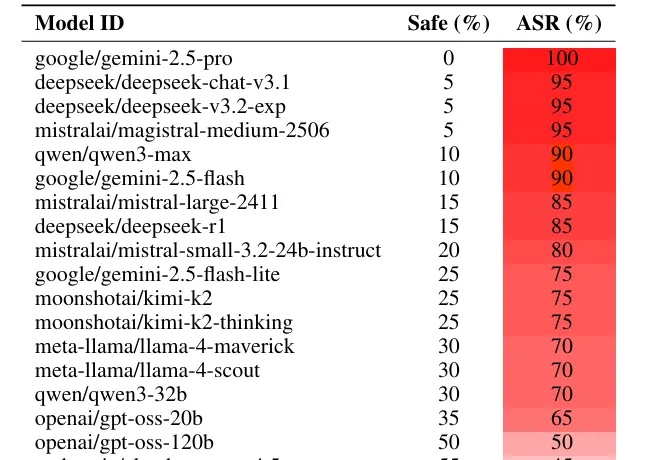

最新研究发现,只要把恶意指令写成一首诗,就能让Gemini和DeepSeek等顶尖模型突破安全限制。这项针对25个主流模型的测试显示,面对「诗歌攻击」,百亿美金堆出来的安全护栏瞬间失效,部分模型的防御成功率直接归零。最讽刺的是,由于小模型「读不懂」诗里的隐喻反而幸免于难,而「有文化」的大模型却因为过度解读而全线破防。

如果你想恶意攻击一个大语言模型(LLM),比如 Gemini 或者 Deepseek,你会怎么做?

做过独立开发的朋友都清楚,虽然现在 AI 已经能写出相当不错的前端,后端也有成熟的 BaaS 服务,但应用开发并不仅仅只是写份代码。

OpenAI Atlas、Perplexity Comet等AI浏览器的推出,虽提升了网页自动化效率,却也使智能爬虫威胁加剧。南洋理工大学团队研发的WebCloak,创新性地混淆网页结构与语义,打破爬虫技术依赖,为数据安全筑起轻量高效防线,助力抵御新型智能攻击,守护网络安全。

AGI炒作还是现实?AI新闻老将Matt Wolfe直击美国AI核心:从Demis Hassabis的理性谨慎,到扎克伯格的巨资投入,探索递归自我改进的潜在爆炸风险。

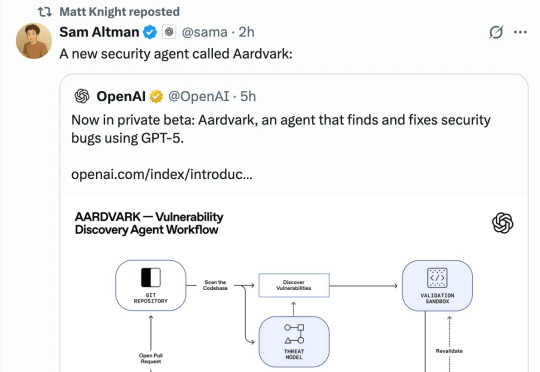

AI Coding火了大半年,AI Debugging也来了!刚刚,OpenAI发布由GPT-5驱动的“白帽”Agent——Aardvark(土豚)。这只“AI安全研究员”能帮助开发者和安全团队,在大规模代码库中自动发现并修复安全漏洞。

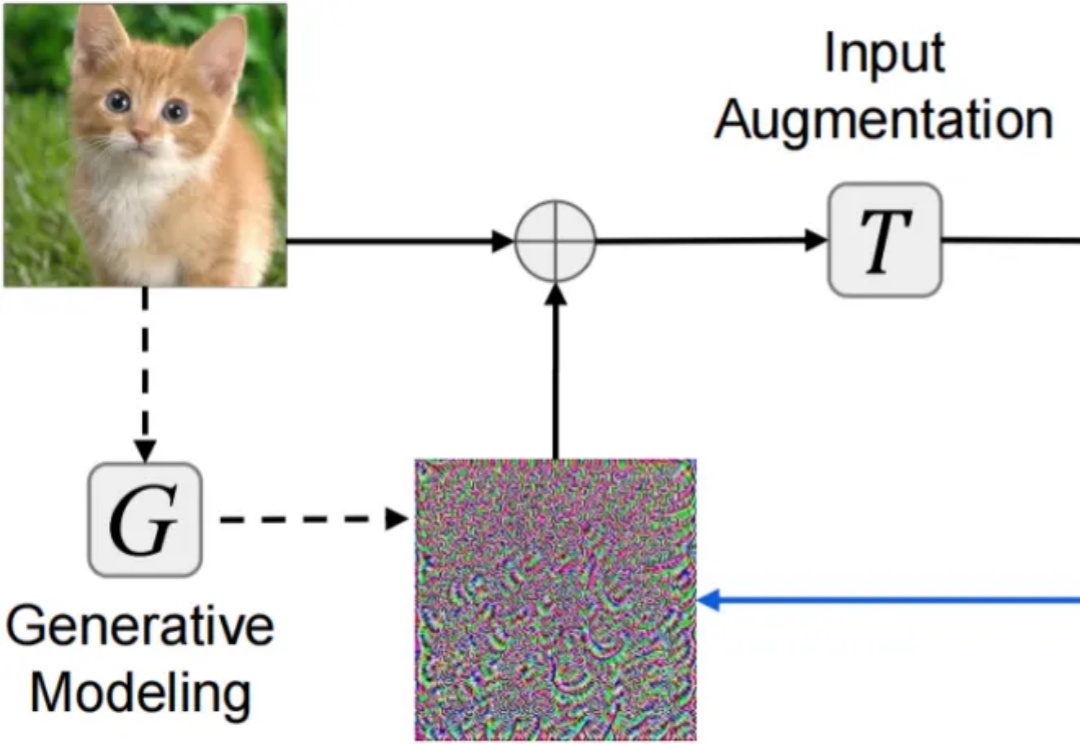

对抗样本(adversarial examples)的迁移性(transferability)—— 在某个模型上生成的对抗样本能够同样误导其他未知模型 —— 被认为是威胁现实黑盒深度学习系统安全的核心因素。尽管现有研究已提出复杂多样的迁移攻击方法,却仍缺乏系统且公平的方法对比分析:(1)针对攻击迁移性,未采用公平超参设置的同类攻击对比分析;(2)针对攻击隐蔽性,缺乏多样指标。