重磅开源利器 Denser Retriever:轻松打造顶尖 RAG 应用的终极检索器

重磅开源利器 Denser Retriever:轻松打造顶尖 RAG 应用的终极检索器当前流行的基于嵌入检索的RAG(Retrieval-Augmented Generation)技术由Meta在2020年首次提出,最初应用于开放领域的抽取式问答。

当前流行的基于嵌入检索的RAG(Retrieval-Augmented Generation)技术由Meta在2020年首次提出,最初应用于开放领域的抽取式问答。

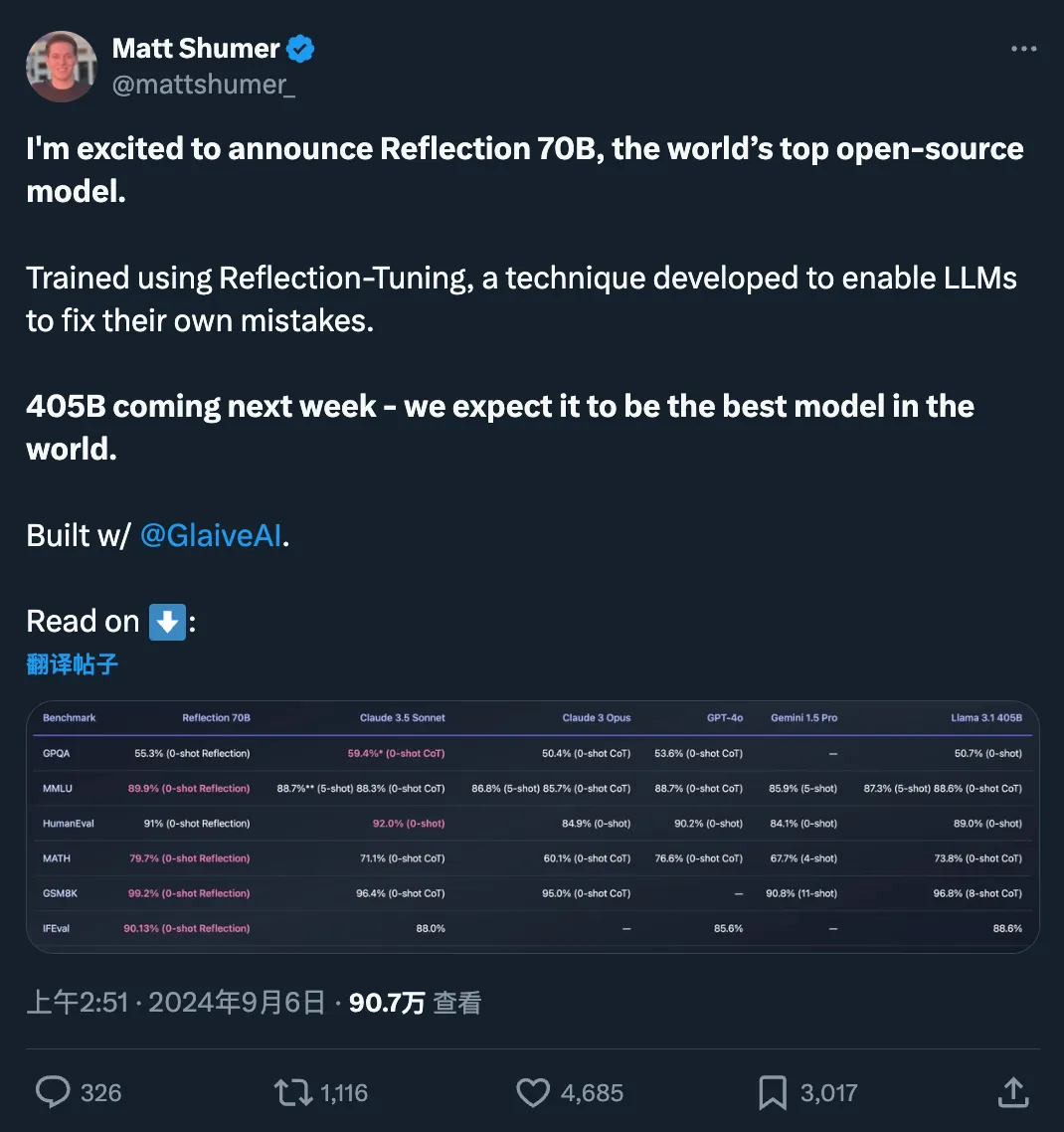

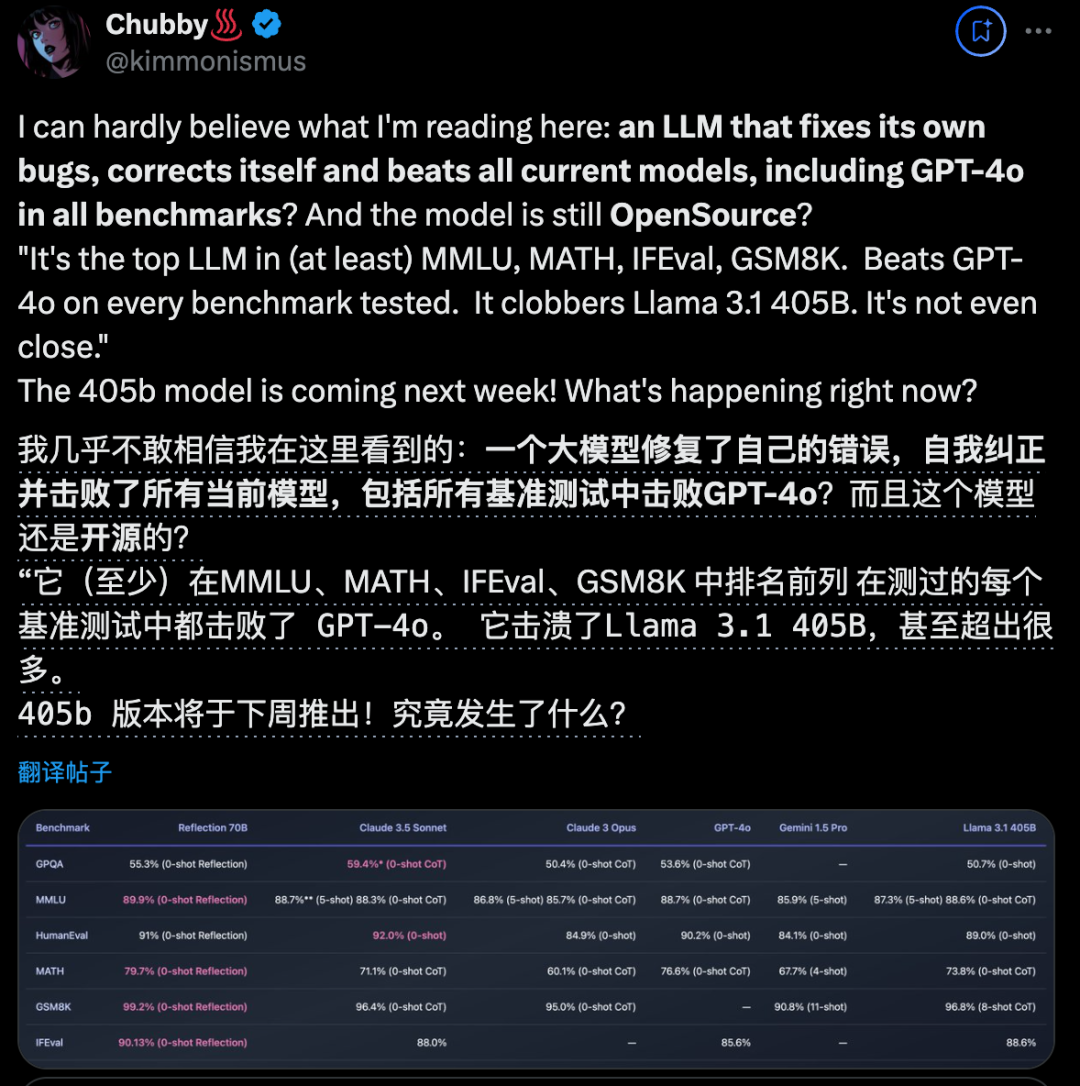

快速更迭的开源大模型领域,又出现了新王:Reflection 70B。 横扫 MMLU、MATH、IFEval、GSM8K,在每项基准测试上都超过了 GPT-4o,还击败了 405B 的 Llama 3.1。 这个新模型 Reflection 70B,来自 AI 写作初创公司 HyperWrite。

开源大模型王座突然易主,居然来自一家小创业团队,瞬间引爆业界。新模型名为Reflection 70B,使用一种全新训练技术,让AI学会在推理过程中纠正自己的错误和幻觉。

美东时间9月3日,AI+衰老药物发现公司 BioAge Labs(下称BioAge)正式向美国证券交易委员提交IPO上市申请。

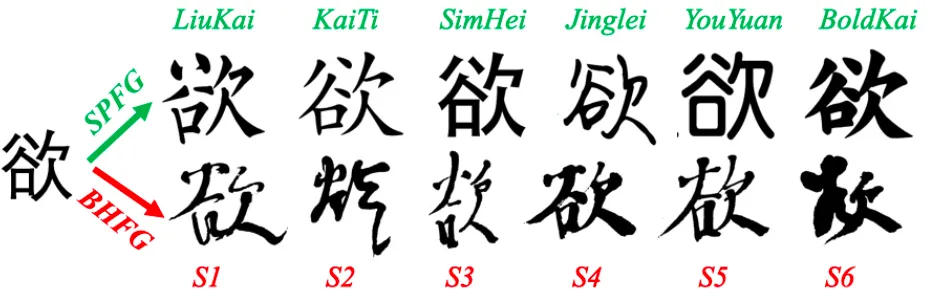

这篇文章是笔者之前AI手写连笔书法生成的一个工作,是联合中央美院几位非常知名的老师完成的。当时提出的思路相对简单,主要结构是基于对抗生成网络(GAN)。虽然方法在大模型横行今天可能已经不算太新颖,但近期一些基于diffusion的AIGC工作还是关注到了这篇文章,并产生了一些启发。笔者认为这些灵感仍具有一定价值,因此在这里做个分享。由于一些公式和指标不太友好,为了不影响阅读故省略。

AlphaFold2解决了很大程度上解决了单体蛋白质结构预测问题。

PPIO推出新AI产品,助力分布式云计算及AIGC应用。

企业要用好 LLM 离不开高质量数据。和传统机器学习模型相比,LLM 对于数据需求量更大、要求更高,尤其是非结构化数据。而传统 ETL 工具并不擅长非结构化数据的处理,因此,企业在部署 LLM 的过程中,数据科学家们往往要耗费大量的时间精力在数据处理环节。这一环节既关系到 LLM 部署的效率和质量,也对数据科学家人力的 ROI 产生影响。

2024 Inclusion·外滩大会将于明天正式开幕。今天,记者来到大会现场探营,今年围绕科技、人文、可持续三大关键词再次升级,特设10000平方米的科技展览和3000平方米的绿色生活节,为观众带来一场活色生香的沉浸式科技体验。

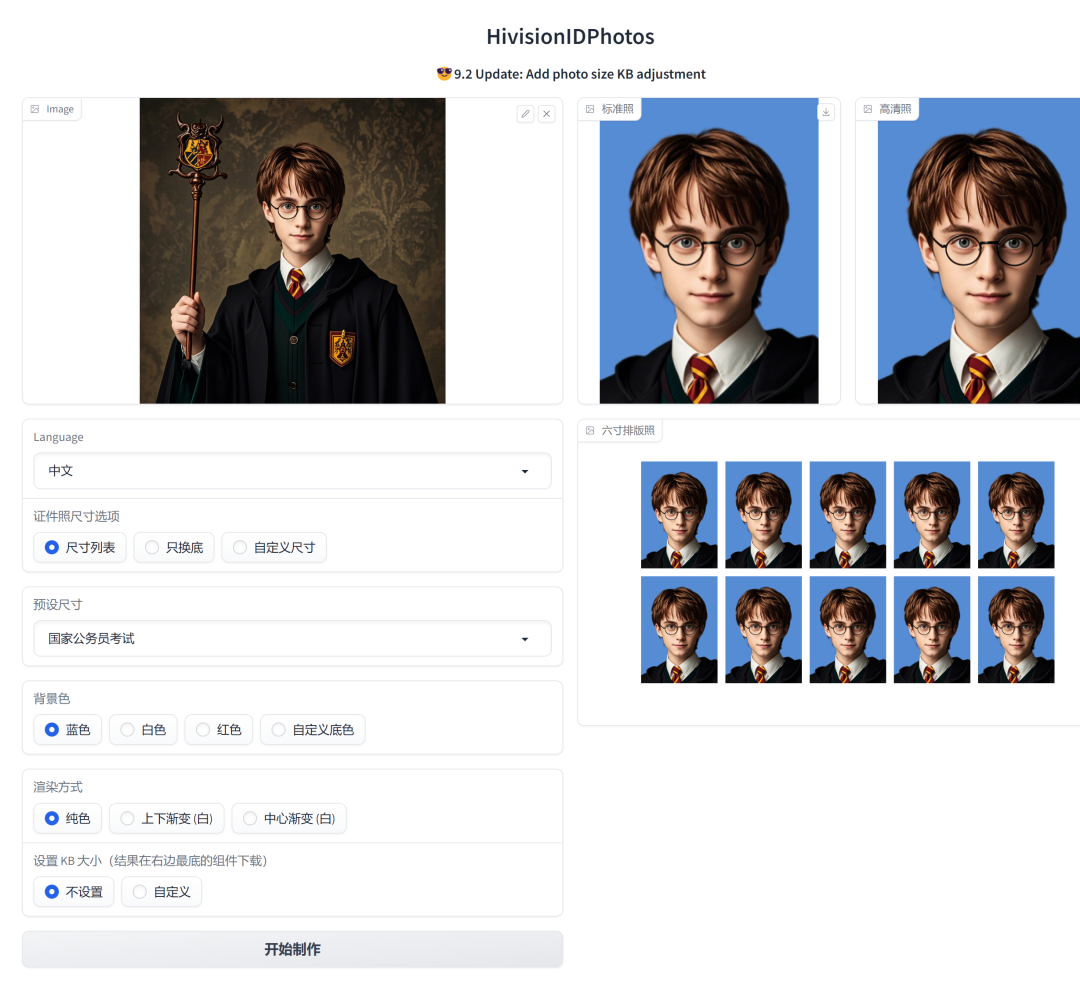

最近,这个AI证件照神器狠狠火了~