微软急刹车,被曝撤掉大波数据中心租赁!DeepSeek冲击,算力泡沫要破?

微软急刹车,被曝撤掉大波数据中心租赁!DeepSeek冲击,算力泡沫要破?DeepSeek开源第二弹如期而至。这一次,他们把MoE模型内核库开源了,支持FP8专为Hopper GPU设计,低延迟超高速训练推理。

DeepSeek开源第二弹如期而至。这一次,他们把MoE模型内核库开源了,支持FP8专为Hopper GPU设计,低延迟超高速训练推理。

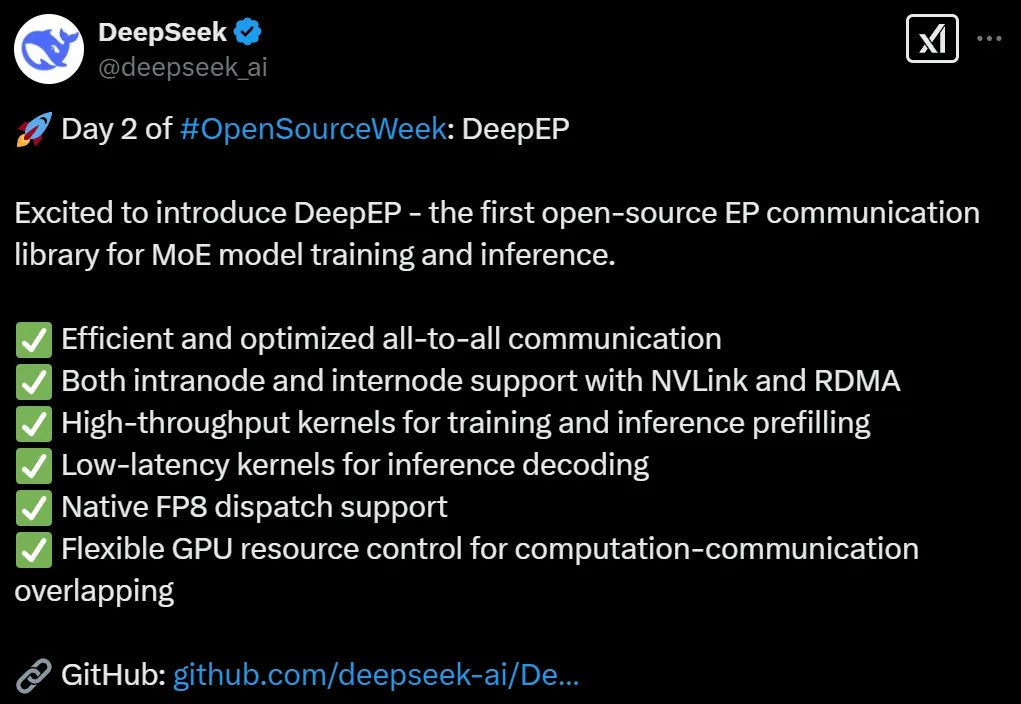

DeepSeek开源第二弹如期而至。这一次,他们把MoE训推EP通信库DeepEP开源了,支持FP8专为Hopper GPU设计,低延迟超高速训练推理。

DeepSeek 本周正在连续 5 天发布开源项目,今天是第 2 天,带来了专为混合专家模型(MoE)和专家并行(EP)打造的高效通信库 — DeepEP。就在半小时前,官方对此进行了发布,以下是由赛博禅心带来的详解。

DeepSeek开源周第一天就放大招!FlashMLA强势登场,这是专为英伟达Hopper GPU打造MLA解码内核。注意,DeepSeek训练成本极低的两大关键,一个是MoE,另一个就是MLA。

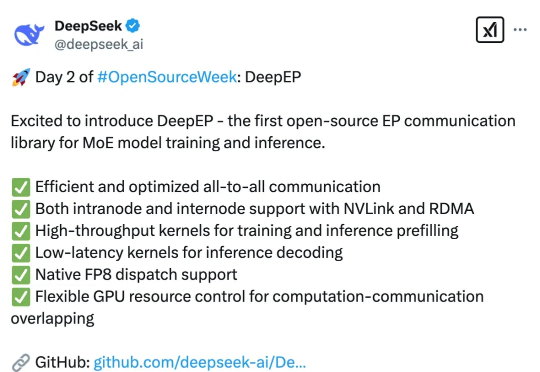

2 月 18 日,月之暗面发布了一篇关于稀疏注意力框架 MoBA 的论文。MoBA 框架借鉴了 Mixture of Experts(MoE)的理念,提升了处理长文本的效率,它的上下文长度可扩展至 10M。并且,MoBA 支持在全注意力和稀疏注意力之间无缝切换,使得与现有的预训练模型兼容性大幅提升。

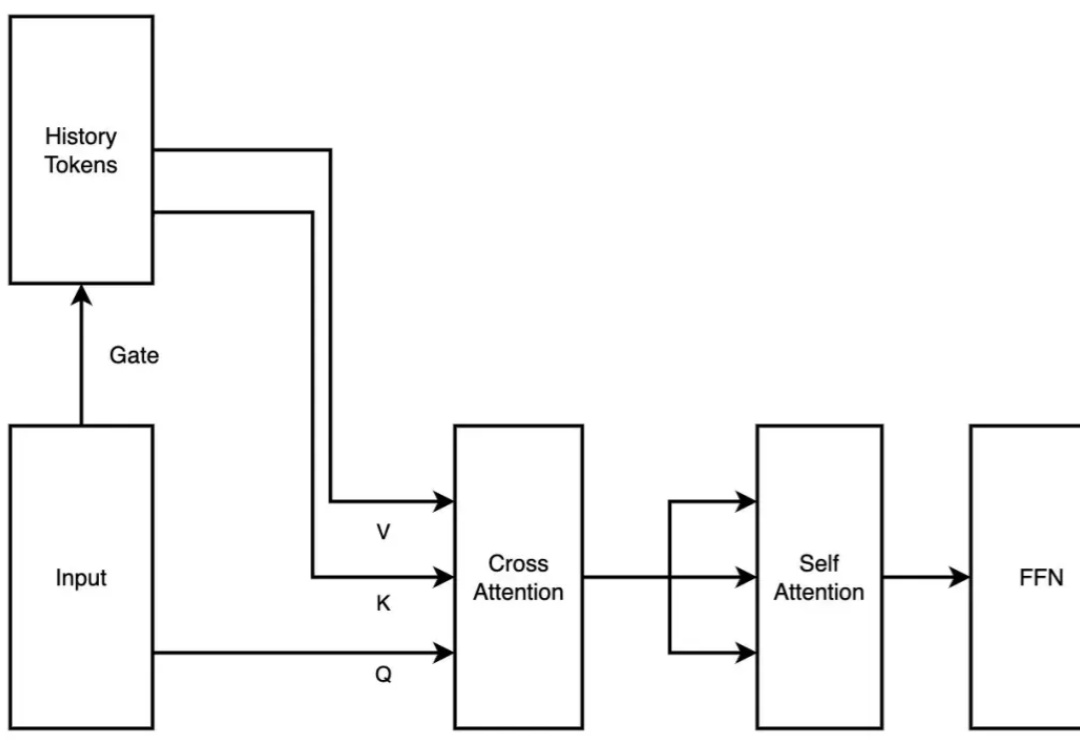

在大语言模型领域中,预训练 + 微调范式已经成为了部署各类下游应用的重要基础。在该框架下,通过使用搭低秩自适应(LoRA)方法的大模型参数高效微调(PEFT)技术,已经产生了大量针对特定任务、可重用的 LoRA 适配器。

这应该是我知道的第一家有自己大模型的大厂,第一次在面向C端的AI助手应用中,第一次接入DeepSeek R1。这个意义影响还是非常深远的,腾讯在AI这一步上,好像走的格外的开放,从之前的批量开源MoE、混元绘图模型、混元视频模型、混元3D模型,还有今天这神之一手接入DeepSeek R1。

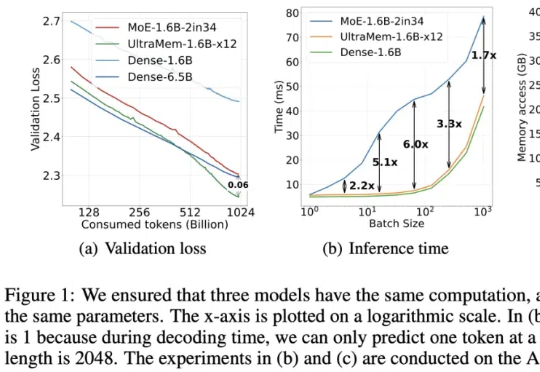

字节出了个全新架构,把推理成本给狠狠地打了下去!推理速度相比MoE架构提升2-6倍,推理成本最高可降低83%。

DeepSeek 的最新模型 DeepSeek-V3 和 DeepSeek-R1 都属于 MoE(混合专家)架构,并在开源世界产生了较大的影响力。特别是 2025 年 1 月开源的 DeepSeek-R1,模型性能可挑战 OpenAI 闭源的 o1 模型。

过年这几天,DeepSeek 算是彻底破圈了,火遍大江南北,火到人尽皆知。虽然网络版和 APP 版已经足够好用,但把模型部署到本地,才能真正实现独家定制,让 DeepSeek R1 的深度思考「以你为主,为你所用」。