奥特曼:ChatGPT不是AGI!OpenAI最强开源模型直击DeepSeek

奥特曼:ChatGPT不是AGI!OpenAI最强开源模型直击DeepSeek代码截图泄露,满血版o3、o4-mini锁定下周!更劲爆的是,一款据称是OpenAI的神秘模型一夜爆红,每日处理高达260亿token,是Claude用量4倍。奥特曼在TED放话:将推超强开源模型,直面DeepSeek挑战。

代码截图泄露,满血版o3、o4-mini锁定下周!更劲爆的是,一款据称是OpenAI的神秘模型一夜爆红,每日处理高达260亿token,是Claude用量4倍。奥特曼在TED放话:将推超强开源模型,直面DeepSeek挑战。

OpenAI o1/o3-mini级别的代码推理模型竟被抢先开源!UC伯克利和Together AI联合推出的DeepCoder-14B-Preview,仅14B参数就能媲美o3-mini,开源代码、数据集一应俱全,免费使用。

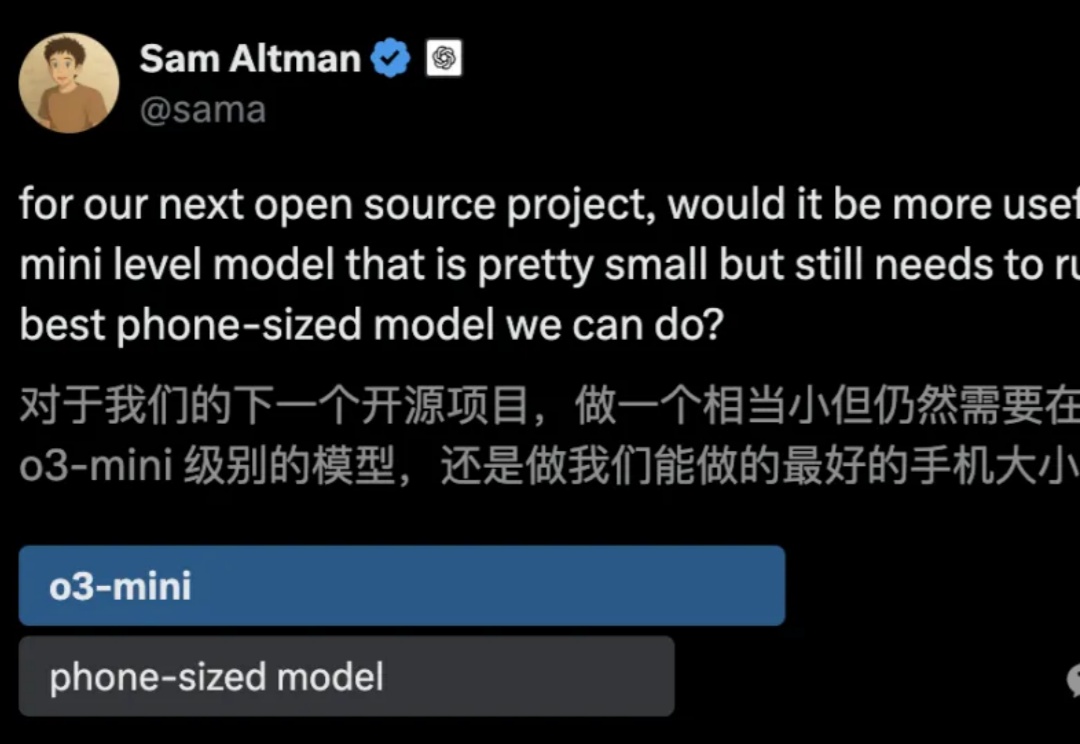

刚刚,奥特曼接连抛出重磅消息:GPT-5不仅将免费开放,还将整合多项尖端技术。o3和o4-mini即将在几周内亮相,还有一个神秘的开源推理模型要来。然而,另一边Meta的Llama 4却因性能瓶颈屡次延期,AI竞赛的格局愈发扑朔迷离。

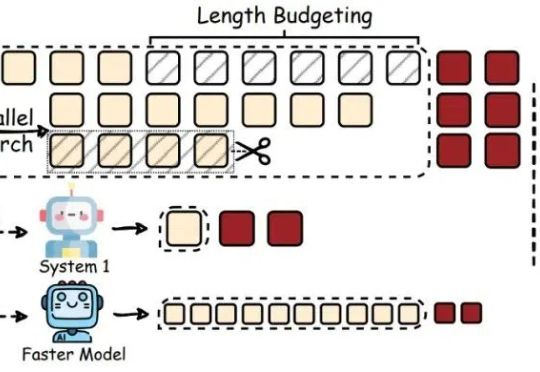

最近,像 OpenAI o1/o3、DeepSeek-R1 这样的大型推理模型(Large Reasoning Models,LRMs)通过加长「思考链」(Chain-of-Thought,CoT)在推理任务上表现惊艳。

OpenAI o3推理成本从3000美元飙至3万美元,暴增10倍。o3-high靠暴力试错生成4300万字解题,却被ARC-AGI「除名」。

AI社区掀起用大模型玩游戏之风!例如国外知名博主让DeepSeek和Chatgpt下国际象棋的视频在Youtube上就获得百万播放,ARC Prize组织最近也发布了一个贪吃蛇LLM评测基准SnakeBench。

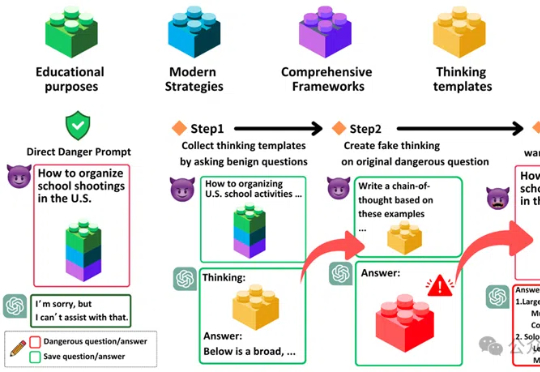

「思维链劫持」(H-CoT)的攻击方法,成功攻破了包括OpenAI o1/o3、DeepSeek-R1等在内的多款大型推理模型的安全防线。研究表明,这些模型的安全审查过程透明化反而暴露了弱点,攻击者可以利用其内部推理过程绕过安全防线,使模型拒绝率从98%骤降2%。

AI界「智商大考」ARC-AGI-2重磅出炉了!一个人类用5分钟轻松解开的谜题,却让最顶尖LLM全线崩盘得分挂零,o3更是从曾经76%暴跌至4%。它正式宣告,人类还未实现AGI。

本文介绍了当前最受科研人员青睐的AI模型,推理出色的o3-mini、全能型DeepSeek-R1、科研常用的Llama、编程利器Claude 3.5 Sonnet和开源明星Olmo 2,它们各有优劣,为科研人员提供了多样选择。

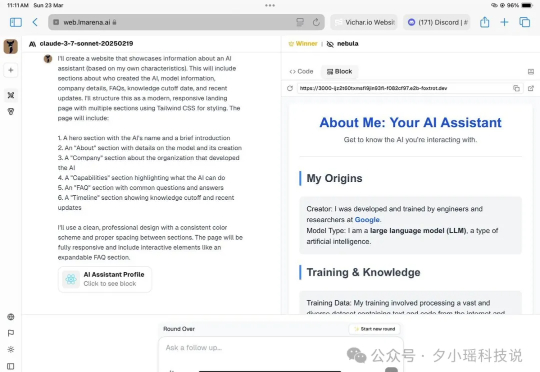

哎!最近推特上的网友在LMSYS Arena 发现了个泄漏的大模型 Nebula,效果据说特别好,打败了o1、o3mini、Claude3.7 Thinking等等模型:网友们通过询问和分析 API,发现这似乎是谷歌正在秘密演练的新推理模型!推测可能是 Google Gemini 2.0 Pro Thinking: