比GPT-4快18倍,世界最快大模型Groq登场!每秒500 token破纪录,自研LPU是英伟达GPU 10倍

比GPT-4快18倍,世界最快大模型Groq登场!每秒500 token破纪录,自研LPU是英伟达GPU 10倍卷疯了!世界最快的大模型Groq一夜之间爆火,能够每秒输出近500个token。如此神速的响应,背后全凭自研的LPU。

卷疯了!世界最快的大模型Groq一夜之间爆火,能够每秒输出近500个token。如此神速的响应,背后全凭自研的LPU。

我们接连被谷歌的多模态模型 Gemini 1.5 以及 OpenAI 的视频生成模型 Sora 所震撼到,前者可以处理的上下文窗口达百万级别,而后者生成的视频能够理解运动中的物理世界,被很多人称为「世界模型」。

月之暗面,拿到了中国大模型初创公司自ChatGPT出现至今的最大一笔单轮融资,10亿美元。

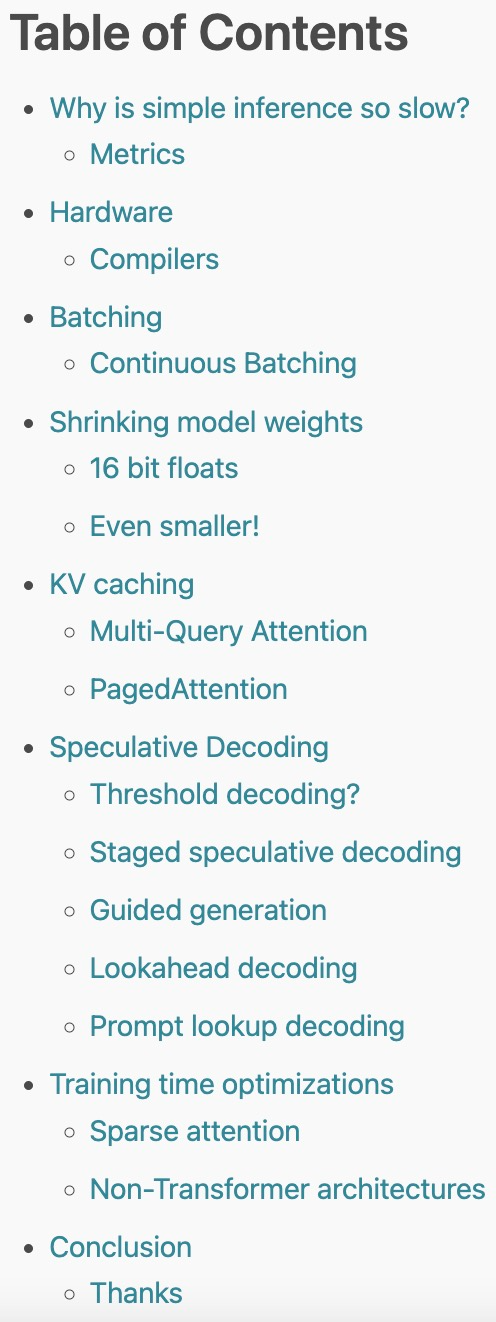

2023 年,大型语言模型(LLM)以其强大的生成、理解、推理等能力而持续受到高度关注。然而,训练和部署 LLM 非常昂贵,需要大量的计算资源和内存,因此研究人员开发了许多用于加速 LLM 预训练、微调和推理的方法。

端侧大模型的火爆,为手机市场带来了新的活力。而颇具创新性的AI应用出现,不仅让手机OEM厂商多了一个可卷的领域,还为用户带来了全新体验,并一定程度上刺激了消费升级,推动手机市场回暖。

Moonshot AI 开放平台今天正式启动公开测试。为了方便 AI 开发者快速接入模型能力,Moonshot AI 开放平台的 API 与 OpenAI 兼容。开发者可以平滑迁移,无需对代码做任何基本参数外的“额外”修改,立即体验到 moonshot 模型的能力。

模型通过学习这些 token 的上下文关系以及如何组合它们来表示原始文本或预测下一个 token。

一个体量仅为2B的大模型,能有什么用?答案可能超出你的想象。

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

对于大型视觉语言模型(LVLM)而言,扩展模型可以有效提高模型性能。然而,扩大参数规模会显著增加训练和推理成本,因为计算中每个 token 都会激活所有模型参数。