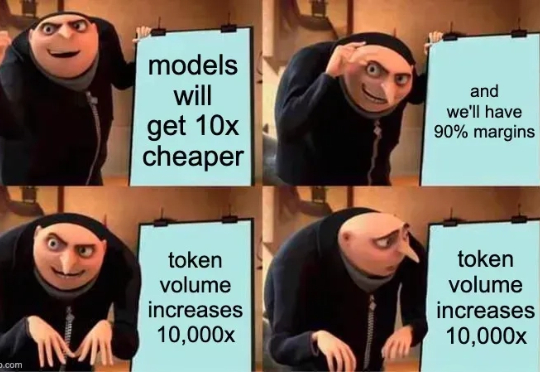

token危机解决?扩散模型数据潜力3倍于自回归,重训480次性能仍攀升

token危机解决?扩散模型数据潜力3倍于自回归,重训480次性能仍攀升扩散语言模型(DLMs)是超强的数据学习者。 token 危机终于要不存在了吗? 近日,新加坡国立大学 AI 研究者 Jinjie Ni 及其团队向着解决 token 危机迈出了关键一步。

扩散语言模型(DLMs)是超强的数据学习者。 token 危机终于要不存在了吗? 近日,新加坡国立大学 AI 研究者 Jinjie Ni 及其团队向着解决 token 危机迈出了关键一步。

年初那会儿,DeepSeek 横空出世,AI 圈子跟过年一样热闹。它凭啥这么火?除了开源够意思,五百多万的训练成本也惊艳了不少人。

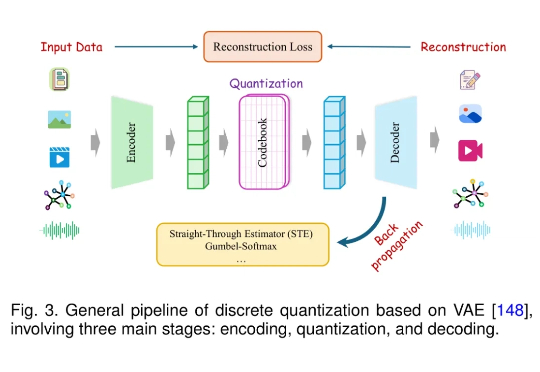

近年来,大语言模型(LLM)在语言理解、生成和泛化方面取得了突破性进展,并广泛应用于各种文本任务。随着研究的深入,人们开始关注将 LLM 的能力扩展至非文本模态,例如图像、音频、视频、图结构、推荐系统等。

用扩散模型写代码,不仅像开了倍速,改起来还特别灵活! 字节Seed最新发布扩散语言模型Seed Diffusion Preview,这款模型主要聚焦于代码生成领域,它的特别之处在于采用了离散状态扩散技术,在推理速度上表现出色。

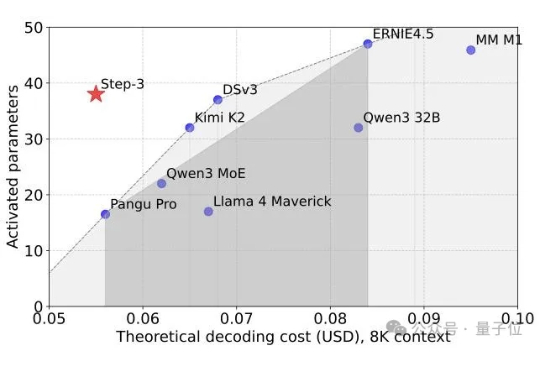

又一个SOTA基础模型开源,而且依然是国产。 刚刚,阶跃星辰兑现了WAIC上的承诺,将最新多模态推理模型Step-3正式开源! 在MMMU等多个多模态榜单上,它一现身就取得了开源多模态推理模型新SOTA的成绩。

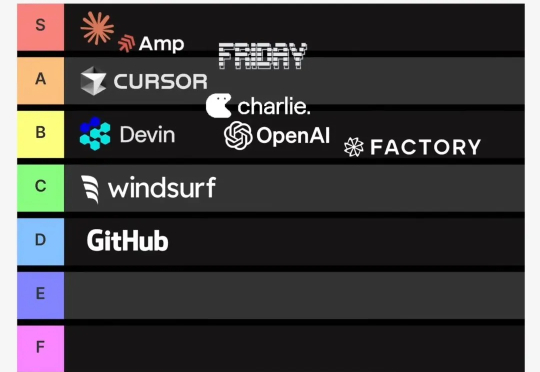

近期,AI 编程领域又一匹 AI Coding 黑马正在快速崛起。

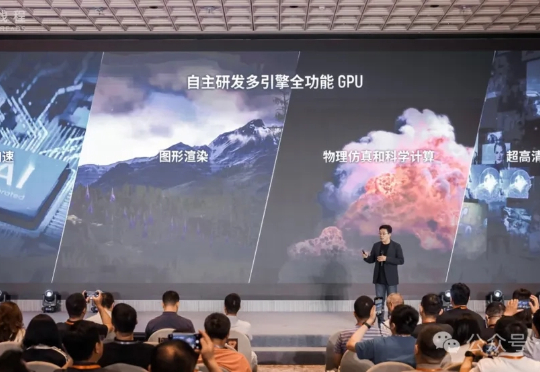

放眼当下,到底哪个芯片跑满血DeepSeek是最快的? 答案很意外——不是你以为的英伟达,而是一家国产GPU。 因为现在它的速度,已经直接来到了100 tokens/s!

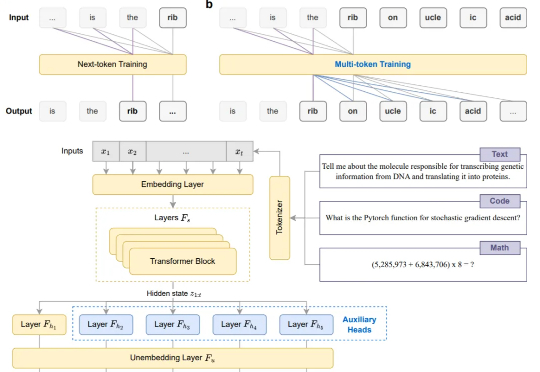

告别Next-token,现在模型微调阶段就能直接多token预测!

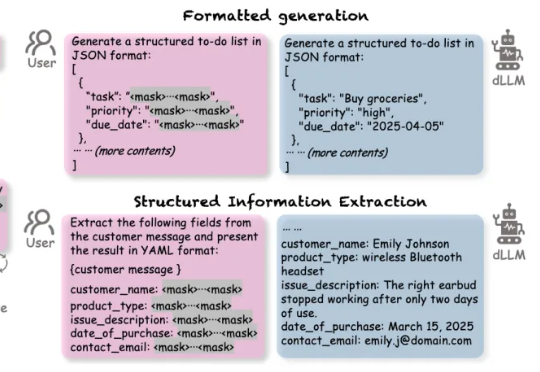

扩散语言模型(Diffusion-based LLMs,简称 dLLMs)以其并行解码、双向上下文建模、灵活插入masked token进行解码的特性,成为一个重要的发展方向。

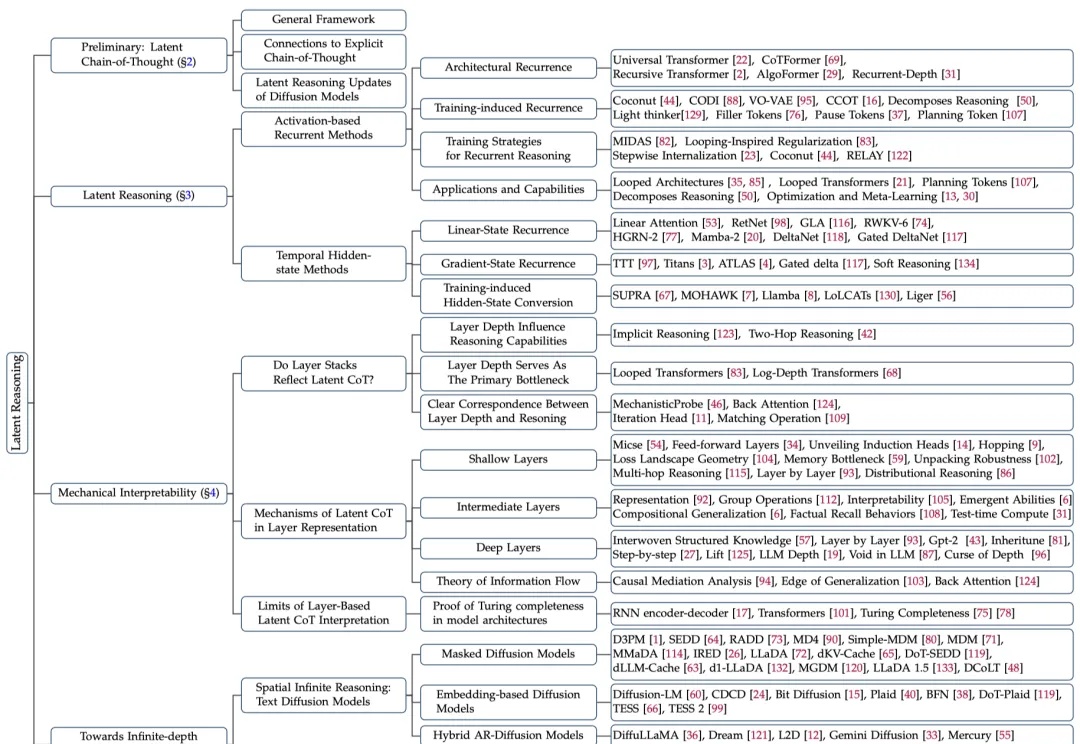

大模型在潜空间中推理,带宽能达到普通(显式)思维链(CoT)的2700多倍?