批量生成AI视频!Vidu接入飞书多维表格,工作流思路解析与模板分享

批量生成AI视频!Vidu接入飞书多维表格,工作流思路解析与模板分享这里介绍一下Vidu,Vidu是由生数科技联合清华大学正式发布的中国首个长时长、高一致性、高动态性视频大模型。Vidu在语义理解、推理速度、动态幅度等方面具备领先优势,并上线了全球首个“多主体参考”功能,突破视频模型一致性生成难题,开启了视觉上下文时代。最近上线了 Vidu Q1 的高质量视频大模型,不仅视频效果质感更高,而且性价比很不错。

这里介绍一下Vidu,Vidu是由生数科技联合清华大学正式发布的中国首个长时长、高一致性、高动态性视频大模型。Vidu在语义理解、推理速度、动态幅度等方面具备领先优势,并上线了全球首个“多主体参考”功能,突破视频模型一致性生成难题,开启了视觉上下文时代。最近上线了 Vidu Q1 的高质量视频大模型,不仅视频效果质感更高,而且性价比很不错。

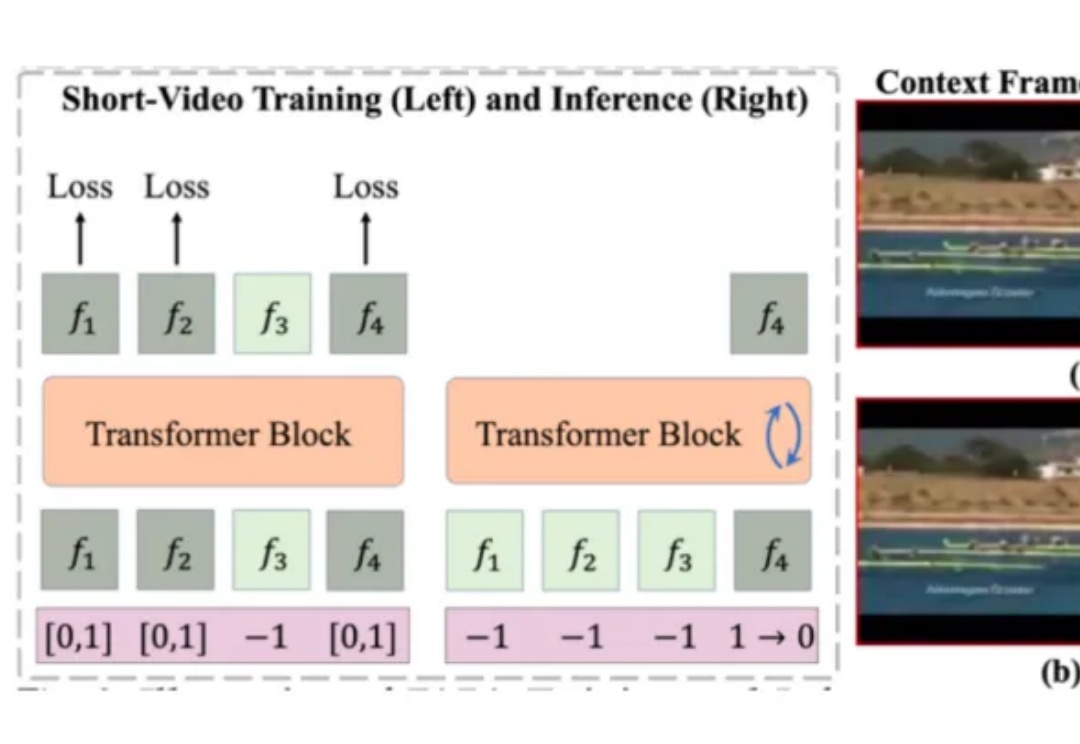

目前的视频生成技术大多是在短视频数据上训练,推理时则通过滑动窗口等策略,逐步扩展生成的视频长度。然而,这种方式无法充分利用视频的长时上下文信息,容易导致生成内容在时序上出现潜在的不一致性。

一句话看懂:o3以深度推理与工具调用能力领跑复杂任务,GPT-4.1超长上下文与精准指令执行适合API开发,而o4-mini则堪称日常任务的「性价比之王」。

GPT - 4o、Deepseek - R1 等高级模型已展现出令人惊叹的「深度思考」能力:理解上下文关联、拆解多步骤问题、甚至通过思维链(Chain - of - Thought)进行自我验证、自我反思等推理过程。

想象一个世界:AI 智能体不再仅仅为你工作,更能彼此协作,形成强大的合力。谷歌的智能体到智能体(A2A)协议,正致力于将孤立的 AI 执行者转变为高效的协作团队。但它与 Anthropic 的模型上下文协议(MCP)相比,孰优孰劣?本文将为您深入剖析。

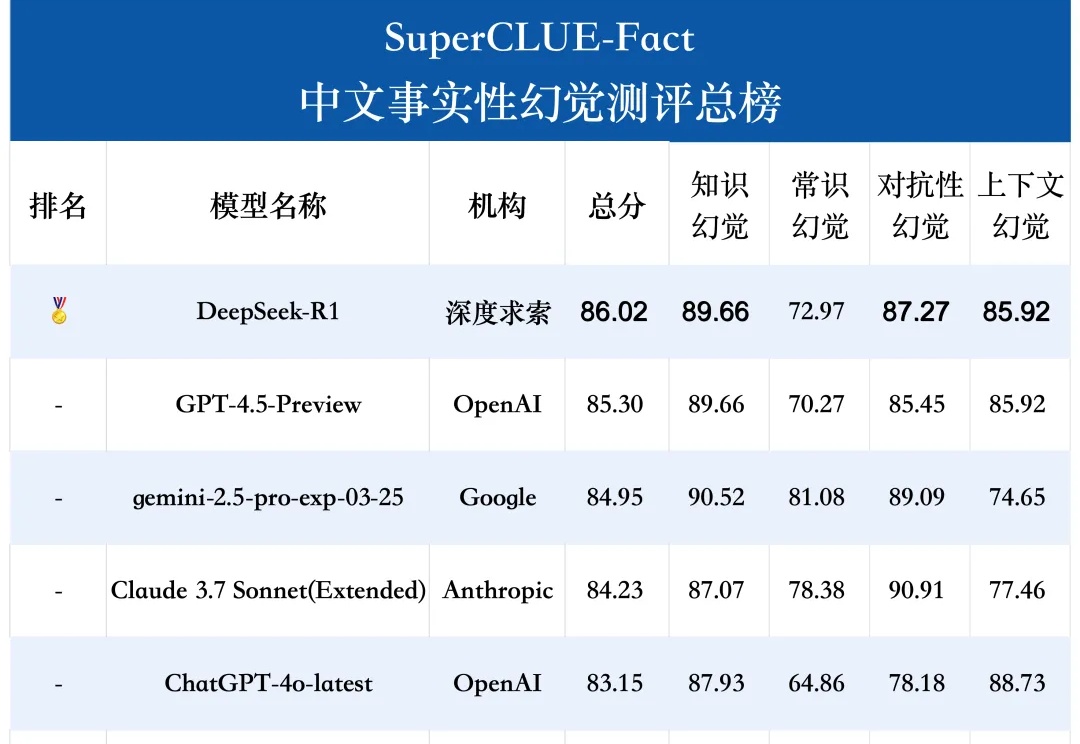

SuperCLUE-Fact是专门评估大语言模型在中文短问答中识别和应对事实性幻觉的测试基准。测评任务包括知识、常识、对抗性和上下文幻觉。

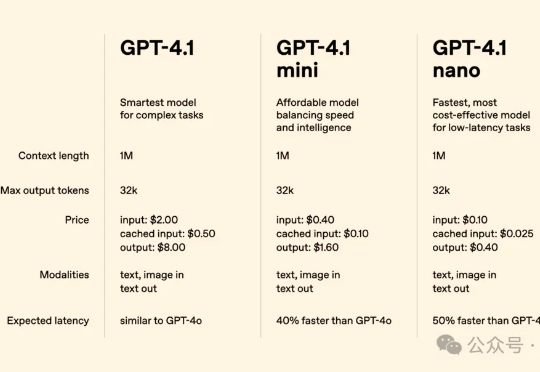

今天凌晨,OpenAI 的新系列模型 GPT-4.1 如约而至。

OpenAI重磅发布的GPT-4.1系列模型,带来了编程、指令跟随和长上下文处理能力的全面飞跃!由中科大校友Jiahui Yu领衔的团队打造。与此同时,备受争议的GPT-4.5将在三个月后停用,GPT-4.1 nano则以最小、最快、最便宜的姿态强势登场。

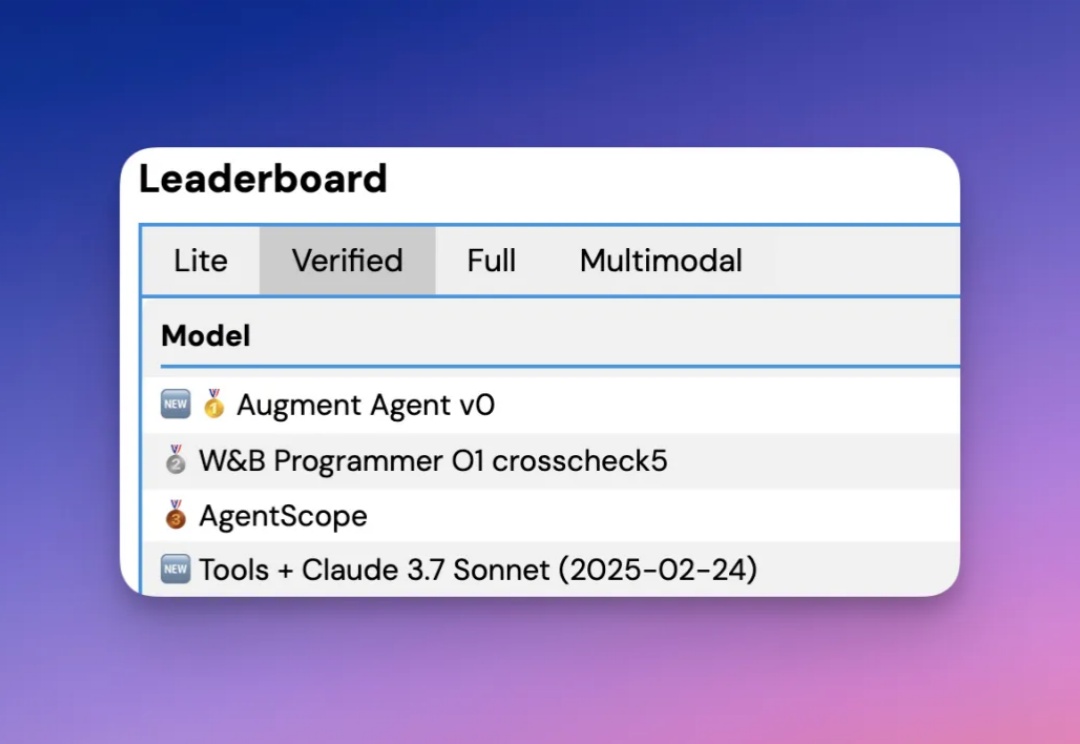

根据官方介绍,Augment Agent 是首个转为大型代码库工作的专业软件工程师设计的 AI 编码助手,上下文支持 200K ,也就是 20 万的 token 啊。

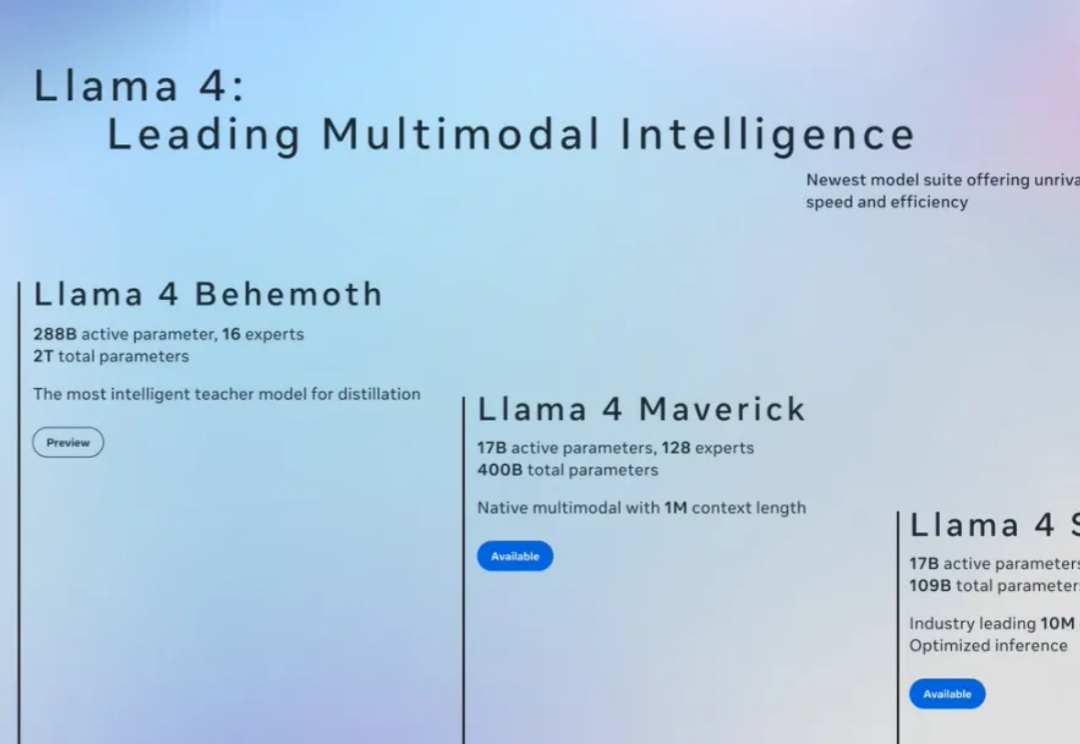

今天在各大信息渠道看到 Llama4 发布的消息,一上来就放出三个模型,具体能力这里就不在赘述,相信大家已经多少看到不少介绍了。