Test Time Scaling Law远未达到上限! o4-mini仅15.8%通过率,华为诺亚提出代码HLCE终极基准

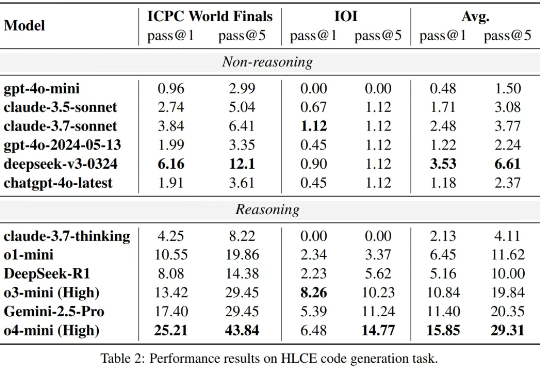

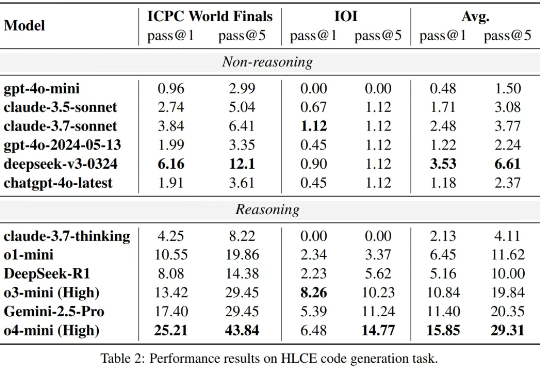

Test Time Scaling Law远未达到上限! o4-mini仅15.8%通过率,华为诺亚提出代码HLCE终极基准大语言模型(LLM)在标准编程基准测试(如 HumanEval,Livecodebench)上已经接近 “毕业”,但这是否意味着它们已经掌握了人类顶尖水平的复杂推理和编程能力?

大语言模型(LLM)在标准编程基准测试(如 HumanEval,Livecodebench)上已经接近 “毕业”,但这是否意味着它们已经掌握了人类顶尖水平的复杂推理和编程能力?

华为 Pangu 员工自曝盘古模型并非如内部宣称的是“从旧的135B参数继承改造而来”,而是直接套用阿里千问 1.5 110B 模型进行续训(通过加层、扩增FFN维度、添加PI机制凑参数)。作者指出:

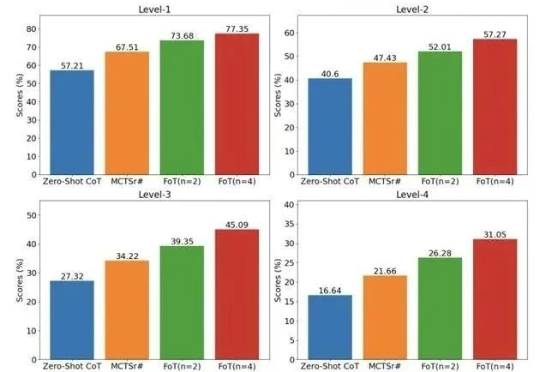

大模型越来越大,通用能力越来越强,但一遇到数学、科学、逻辑这类复杂问题,还是常“翻车”。为破解这一痛点,华为诺亚方舟实验室提出全新高阶推理框架 ——思维森林(Forest-of-Thought,FoT)。

7月5日下午16:59分,隶属于华为的负责开发盘古大模型的诺亚方舟实验室发布声明对于“抄袭”指控进行了官方回应。诺亚方舟实验室表示,盘古Pro MoE开源模型是基于昇腾硬件平台开发、训练的基础大模型,并非基于其他厂商模型增量训练而来,在架构设计、技术特性等方面做了关键创新,是全球首个面向昇腾硬件平台设计的同规格混合专家模型

AI 领域最近盛行一个观点:AI 下半场已经开始,评估将比训练重要。而在硬件层级上,我们也正在开始进入一个新世代。

混合专家网络模型架构(MoE)已经成为当前大模型的一个主流架构选择,以最近开源的盘古Pro MoE为例

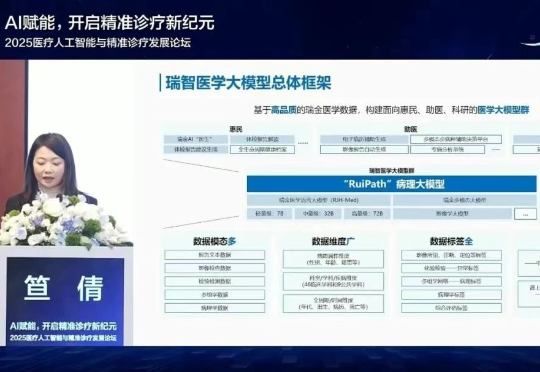

6月30日,上海交通大学医学院附属瑞金医院宣布,RuiPath病理大模型的视觉基础模型正式开源。

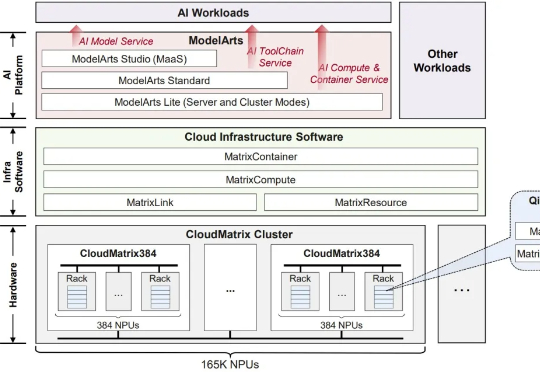

超大规模MoE模型(如DeepSeek),到底该怎么推理才能做到又快又稳。现在,这个问题似乎已经有了标准答案——华为一个新项目,直接把推理超大规模MoE背后的架构、技术和代码,统统给开源了!

最近,看到各大厂商,在不断地将自己的AI大模型进行开源。华为宣布开源:盘古7B稠密和72B混合专家模型。

刚刚,华为正式宣布开源盘古 70 亿参数的稠密模型、盘古 Pro MoE 720 亿参数的混合专家模型(参见机器之心报道:华为盘古首次露出,昇腾原生72B MoE架构,SuperCLUE千亿内模型并列国内第一 )和基于昇腾的模型推理技术。