多模态模型学会打扑克:表现超越GPT-4v,全新强化学习框架是关键

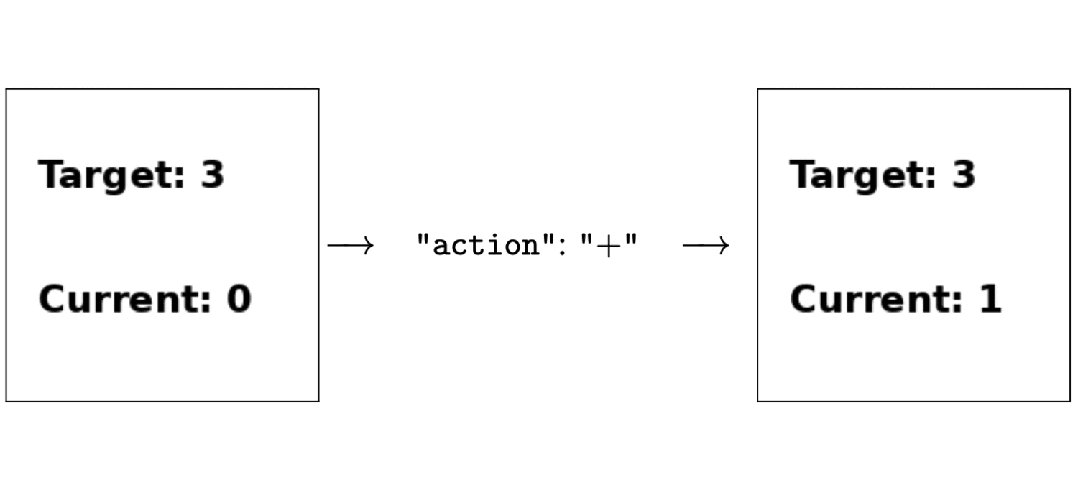

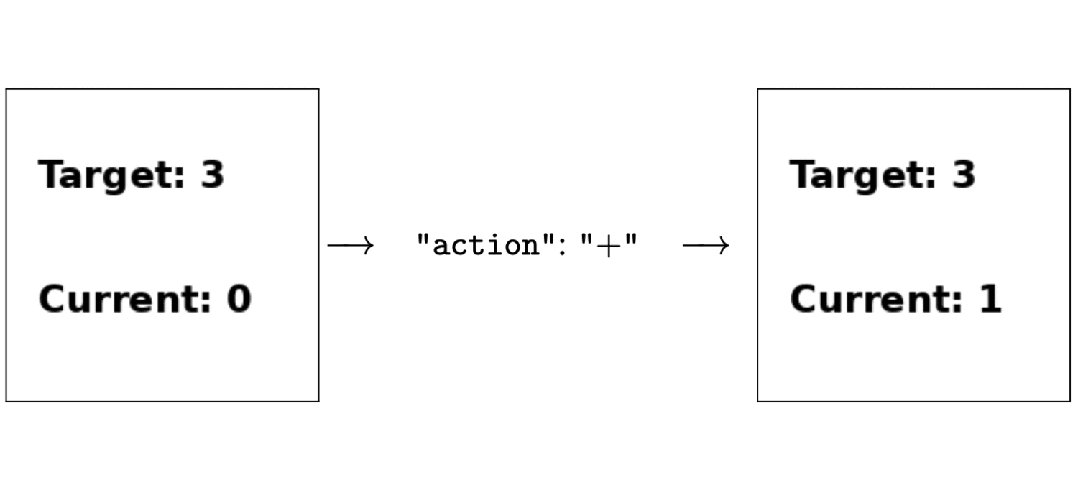

多模态模型学会打扑克:表现超越GPT-4v,全新强化学习框架是关键只用强化学习来微调,无需人类反馈,就能让多模态大模型学会做决策!

只用强化学习来微调,无需人类反馈,就能让多模态大模型学会做决策!

多模态,已经成为大模型最重要的发展方向之一。

最近的一系列研究表明,纯解码器生成模型可以通过训练利用下一个 token 预测生成有用的表征,从而成功地生成多种模态(如音频、图像或状态 - 动作序列)的新序列,从文本、蛋白质、音频到图像,甚至是状态序列。

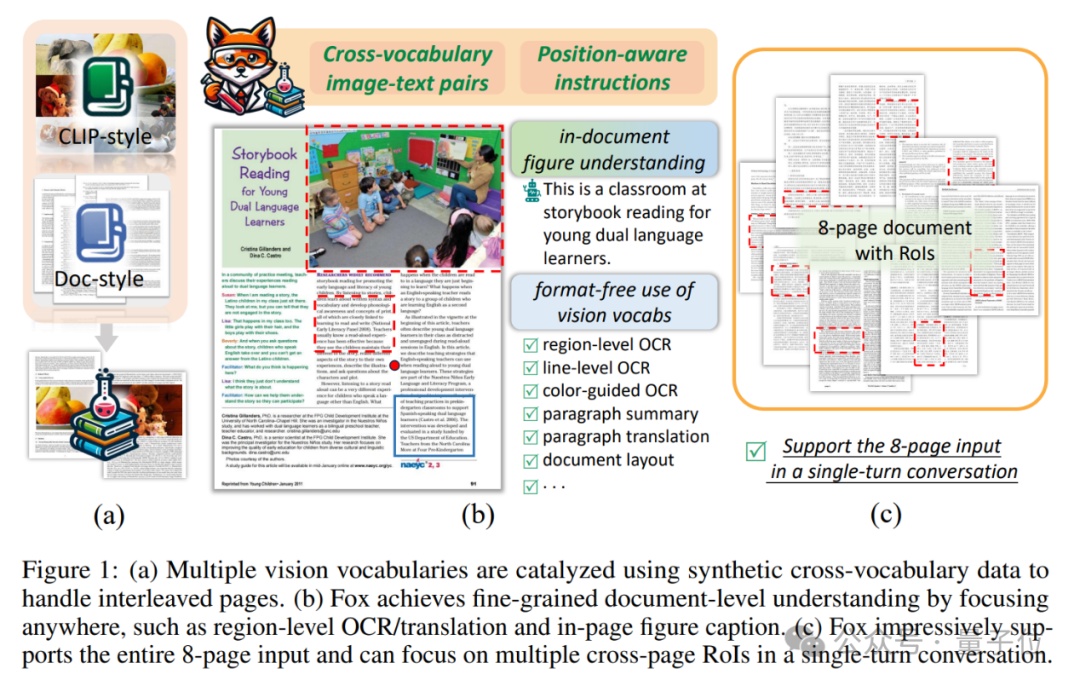

虽然多模态大模型都能挑西瓜了,但理解复杂文档方面还是差点意思。

Aya23在模型性能和语言种类覆盖度上达到了平衡,其中最大的35B参数量模型在所有评估任务和涵盖的语言中取得了最好成绩。

多模态大模型,也有自己的CoT思维链了! 厦门大学&腾讯优图团队提出一种名为“领唱员(Cantor)”的决策感知多模态思维链架构,无需额外训练,性能大幅提升。

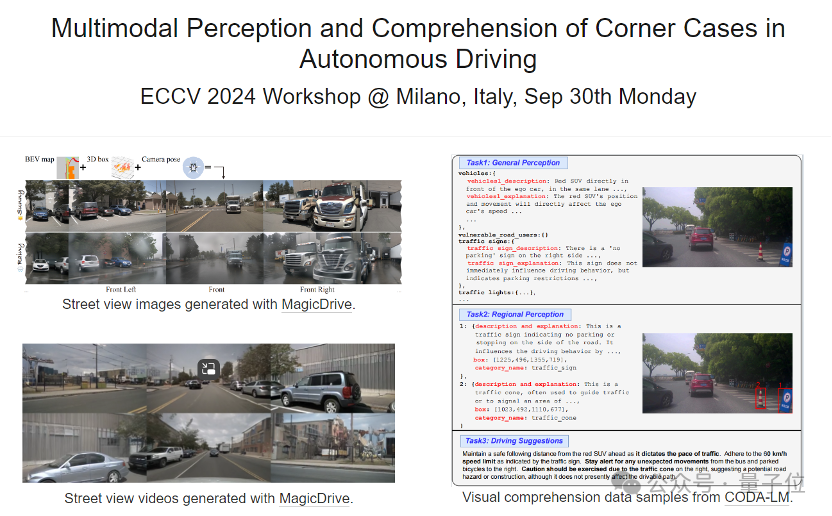

当前,多模态大模型 (MLLM)在多项视觉任务上展现出了强大的认知理解能力。 然而大部分多模态大模型局限于单向的图像理解,难以将理解的内容映射回图像上。 比如,模型能轻易说出图中有哪些物体,但无法将物体在图中准确标识出来。 定位能力的缺失直接限制了多模态大模型在图像编辑,自动驾驶,机器人控制等下游领域的应用。针对这一问题,港大和字节跳动商业化团队的研究人员提出了一种新范式Groma

央企通信巨头再次奏响大模型舞台的超强音!刚刚结束的中国移动人工智能生态大会主旨论坛上,中国移动发布了全自研「九天」千亿多模态基座大模型,一举成为国内最值得信赖、最懂行业的全栈大模型。

在人工智能的辉煌历史中,Geoffrey Hinton教授不仅是深度学习的奠基人之一,更是推动了整个领域从理论到实践的转变。在这次深入的访谈中,Geoffrey Hinton分享了自己在人工智能研究中的个人经历、对深度学习未来发展的深刻见解,以及对当前技术可能带来的社会影响的深思熟虑。

OpenAI半小时的发布会让很多人第一反应是直呼「失望」,但随着官网放出更多demo以及更多网友开始试用,大家才发现GPT-4o真的不可小觑,不仅在各种基准测试中稳拿第一,而且有很多发布会从未提及的惊艳功能。