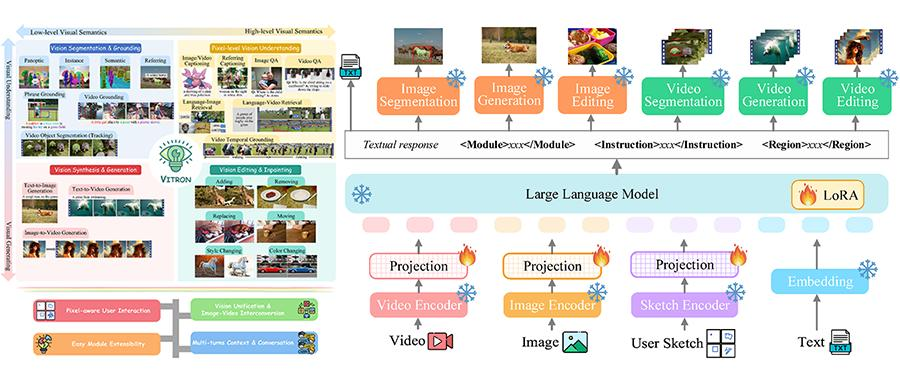

国产多模态大模型狂飙,颜水成挂帅开源Vitron,破解图像/视频模型割裂问题

国产多模态大模型狂飙,颜水成挂帅开源Vitron,破解图像/视频模型割裂问题奔向通用人工智能,大模型又迈出一大步。

奔向通用人工智能,大模型又迈出一大步。

奔向通用人工智能,大模型又迈出一大步。

近期,多模态大模型 (MLLM) 在文本中心的 VQA 领域取得了显著进展,尤其是多个闭源模型,例如:GPT4V 和 Gemini,甚至在某些方面展现了超越人类能力的表现。

2023年12月,宁德时代低调宣布在香港设立国际研发中心; 2024年3月11日,作为中国科学院在香港设立的首个国家级信息研发机构,中国科学院香港创新研究院人工智能与机器人创新中心发布了医疗多模态大模型CARES Copilot 1.0;

一个可以自动分析PDF、网页、海报、Excel图表内容的大模型,对于打工人来说简直不要太方便。

近日,由DeepMind、谷歌和Meta的研究人员创立的AI初创公司Reka,推出了他们最新的多模态语言模型——Reka Core

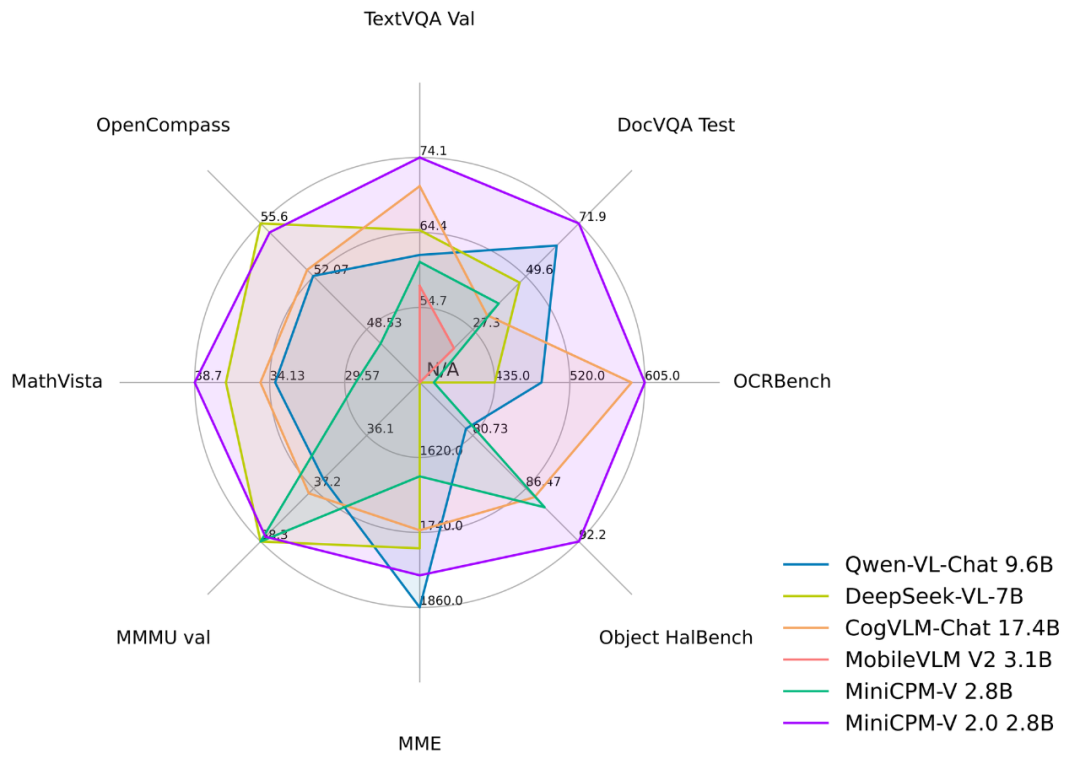

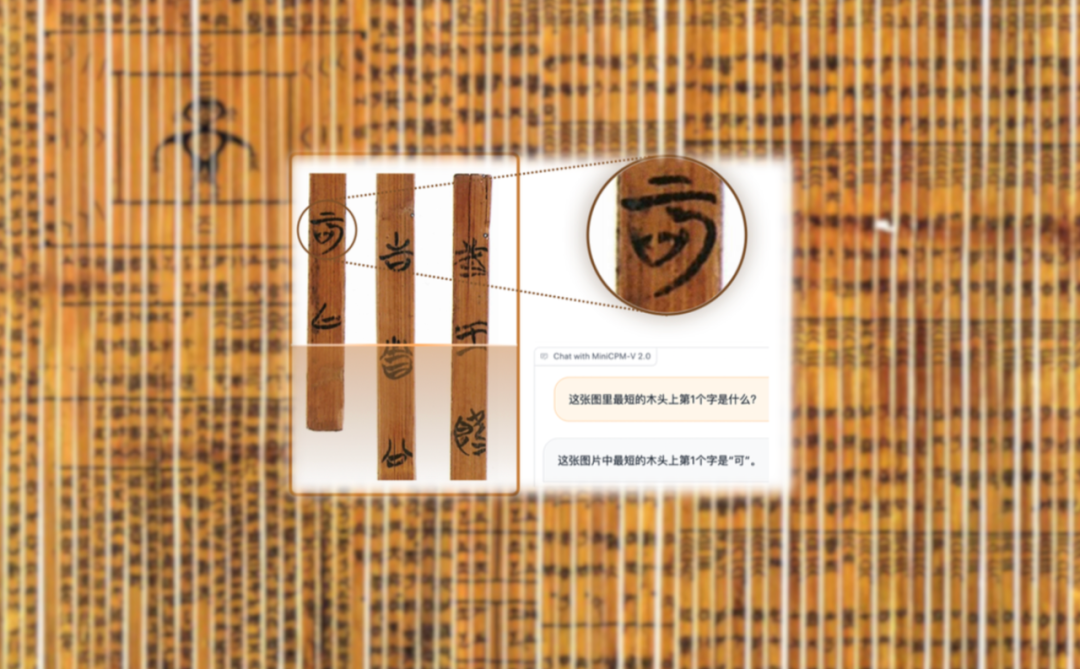

MiniCPM 系列的最新多模态版本 MiniCPM-V 2.0。该模型基于 MiniCPM 2.4B 和 SigLip-400M 构建,共拥有 2.8B 参数。MiniCPM-V 2.0 具有领先的光学字符识别(OCR)和多模态理解能力

自从 2023 年 11 月 Grok 首次亮相以来,马斯克的 xAI 正在大模型领域不断取得进步,向 OpenAI 等先行者发起进攻。在 Grok-1 开源后不到一个月,xAI 的首个多模态模型就问世了。

识读距今2300多年战国时期的上古竹简,AI正在立功。 而且在这背后的“大功臣”,竟是只有2B大小的多模态大模型!

4 月 4 日,Y Combinator W2024 Batch Demo Day 正式开始。这次共亮相 260 个项目,YC 从 2.7 万份申请中筛选出来,通过率低于 1%,是历史上 YC 录取比例最低的一轮批次之一。