拿CPU搞AI推理,谁给你的底气?

拿CPU搞AI推理,谁给你的底气?大模型的训练阶段我们选择GPU,但到了推理阶段,我们果断把CPU加到了菜单上。

大模型的训练阶段我们选择GPU,但到了推理阶段,我们果断把CPU加到了菜单上。

2024年2月,OpenAI发布其首款视频生成模型Sora,用户仅需输入一段文字即可生成长达一分钟场景切换流畅、细节呈现清晰、情感表达准确的高清视频,与一年前的AI生成视频相比,在各维度均实现了质的提升。

PreFLMR模型是一个通用的预训练多模态知识检索器,可用于搭建多模态RAG应用。模型基于发表于 NeurIPS 2023 的 Fine-grained Late-interaction Multi-modal Retriever (FLMR) 并进行了模型改进和 M2KR 上的大规模预训练。

最近,华中科技大学和金山的研究人员在多模态大模型 Monkey [1](Li et al., CVPR2024)工作的基础上提出 TextMonkey。在多个场景文本和文档的测试基准中,TextMonkey 处于国际领先地位,有潜力带来办公自动化、智慧教育、智慧金融等行业应用领域的技术变革。

3 月 23 日,国内通用大模型创业公司阶跃星辰在 2024 全球开发者先锋大会上发布了公司的通用大模型产品。阶跃星辰创始人、CEO 姜大昕博士在大会开幕式上对外发布了 Step 系列通用大模型,包括 Step-1 千亿参数语言大模型、Step-1V 千亿参数多模态大模型以及 Step-2 万亿参数 MoE 语言大模型预览版。

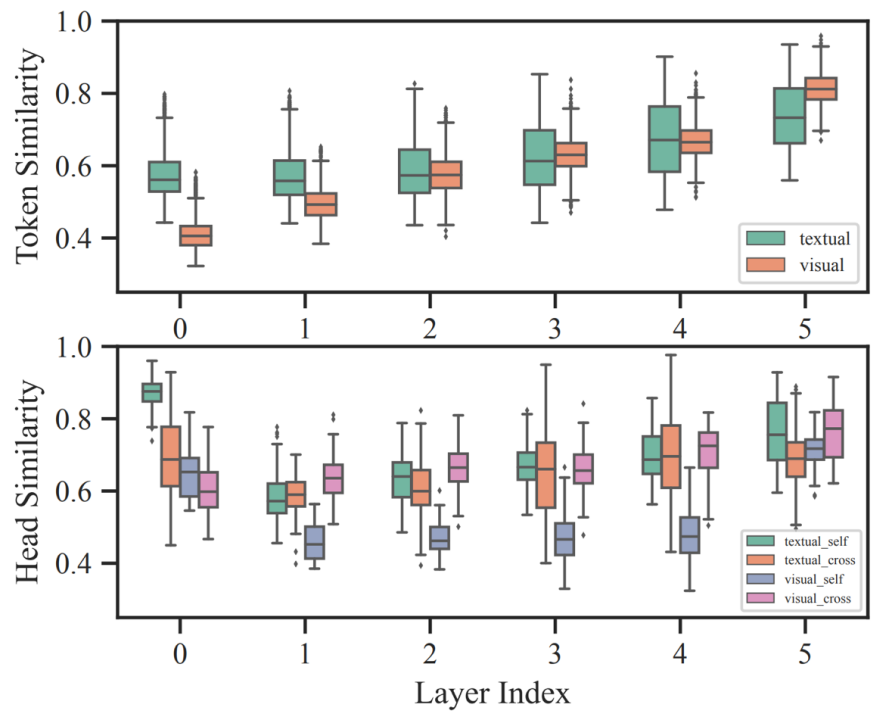

哈工大联合度小满推出针对多模态模型的自适应剪枝算法 SmartTrim,论文已被自然语言处理顶级会议 COLING 24 接收。

苹果首次披露了在多模态大型语言模型(LLM)研究领域的最新突破,并在生成式AI领域“开辟新天地”。探索生成式AI领域,将AI技术引入iPhone

清华系多模态大模型公司,又拿钱了!

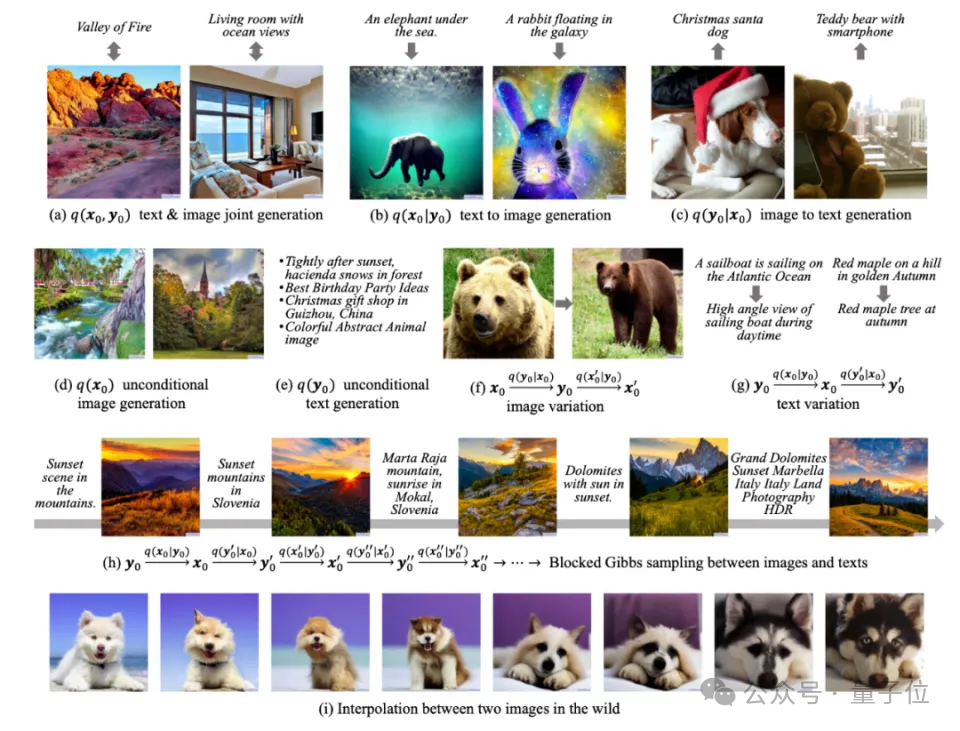

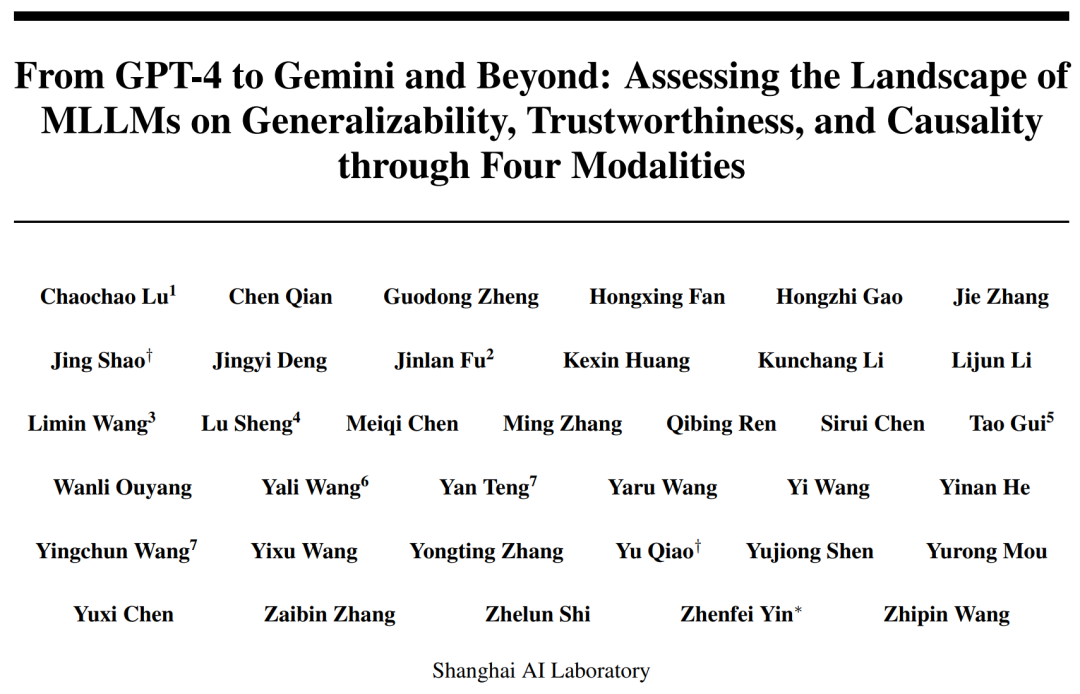

2023 年我们正见证着多模态大模型的跨越式发展,多模态大语言模型(MLLM)已经在文本、代码、图像、视频等多模态内容处理方面表现出了空前的能力,成为技术新浪潮。以 Llama 2,Mixtral 为代表的大语言模型(LLM),以 GPT-4、Gemini、LLaVA 为代表的多模态大语言模型跨越式发展。

近日,杭州联汇科技股份有限公司(以下简称 “联汇科技”)宣布完成新一轮数亿元战略融资,投资方由中国移动产业链发展基金中移和创投资、前海方舟(前海母基金管理机构)旗下中原前海基金和齐鲁前海基金等多家头部国资与市场化机构组成。