2B多模态新SOTA!华科、华南理工发布Mini-Monkey,专治「切分增大分辨率」后遗症

2B多模态新SOTA!华科、华南理工发布Mini-Monkey,专治「切分增大分辨率」后遗症Mini-Monkey 是一个轻量级的多模态大型语言模型,通过采用多尺度自适应切分策略(MSAC)和尺度压缩机制(SCM),有效缓解了传统图像切分策略带来的锯齿效应,提升了模型在高分辨率图像处理和文档理解任务的性能。它在多项基准测试中取得了领先的成绩,证明了其在多模态理解和文档智能领域的潜力。

Mini-Monkey 是一个轻量级的多模态大型语言模型,通过采用多尺度自适应切分策略(MSAC)和尺度压缩机制(SCM),有效缓解了传统图像切分策略带来的锯齿效应,提升了模型在高分辨率图像处理和文档理解任务的性能。它在多项基准测试中取得了领先的成绩,证明了其在多模态理解和文档智能领域的潜力。

在过去的几年中,大型语言模型(Large Language Models, LLMs)在自然语言处理(NLP)领域取得了突破性的进展。这些模型不仅能够理解复杂的语境,还能够生成连贯且逻辑严谨的文本。

数以亿计的人体验过ChatGPT,但许多人尝试过后便未再回头。每家大型企业也都曾尝试过相关试点项目,但真正投入应用的却寥寥无几。这其中部分原因可能只是时间问题。然而,大型语言模型(LLMs)可能也存在陷阱:它们看似是产品,给人以神奇之感,但实际上并非如此。或许,我们终究需要经历寻找产品与市场契合点的漫长而单调的探索过程。

随着大型语言模型(LLM)技术日渐成熟,各行各业加快了 LLM 应用落地的步伐。为了改进 LLM 的实际应用效果,业界做出了诸多努力。

UrbanGPT是一种创新的时空大型语言模型,它通过结合时空依赖编码器和指令微调技术,展现出在多种城市任务中卓越的泛化能力和预测精度。这项技术突破了传统模型对大量标记数据的依赖,即使在数据稀缺的情况下也能提供准确的预测,为城市管理和规划提供了强大的支持。

大型语言模型(LLM)展现出了令人印象深刻的智能水平。因此,确保其安全性显得至关重要。已有研究提出了各种策略,以使 LLM 与人类伦理道德对齐。然而,当前的先进模型例如 GPT-4 和 LLaMA3-70b-Instruct 仍然容易受到越狱攻击,并被用于恶意用途。

随着大型语言模型(LLMs)的进步,多模态大型语言模型(MLLMs)迅速发展。它们使用预训练的视觉编码器处理图像,并将图像与文本信息一同作为 Token 嵌入输入至 LLMs,从而扩展了模型处理图像输入的对话能力。这种能力的提升为自动驾驶和医疗助手等多种潜在应用领域带来了可能性。

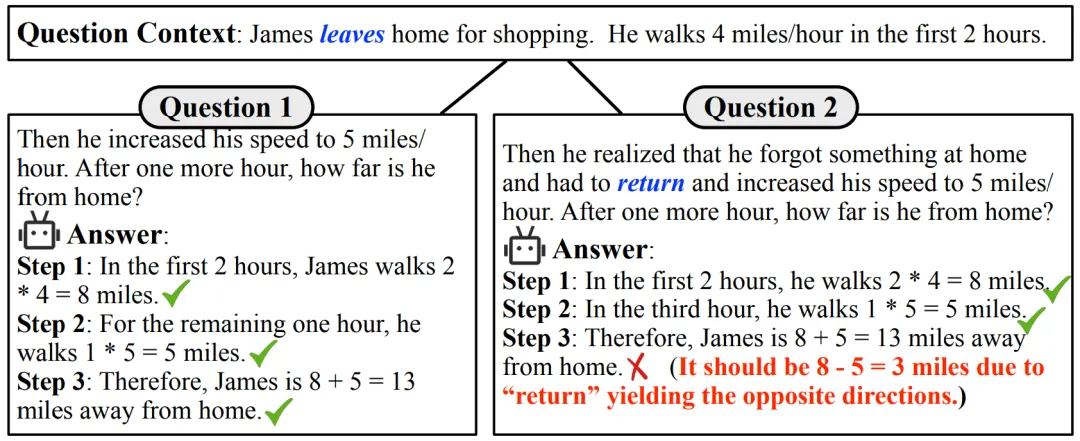

大型语言模型(LLMs)在解决问题方面的非凡能力日益显现。最近,一个值得关注的现象是,这些模型在多项数学推理的基准测试中获得了惊人的成绩。以 GPT-4 为例,在高难度小学应用题测试集 GSM8K [1] 中表现优异,准确率高达 90% 以上。同时,许多开源模型也展现出了不俗的实力,准确率超过 80%。

2022年,Google研究团队发表了名为《思路链提示引发大型语言模型的推理》的开创性论文,引入了思维链(Chain of Thought, CoT)prompting技术。

人会有幻觉,大型语言模型也会有幻觉。近日,OpenAI 安全系统团队负责人 Lilian Weng 更新了博客,介绍了近年来在理解、检测和克服 LLM 幻觉方面的诸多研究成果。