科研也完了,AI暴虐170位人类专家!Nature子刊:大模型精准预测研究结果,准确率高达81%

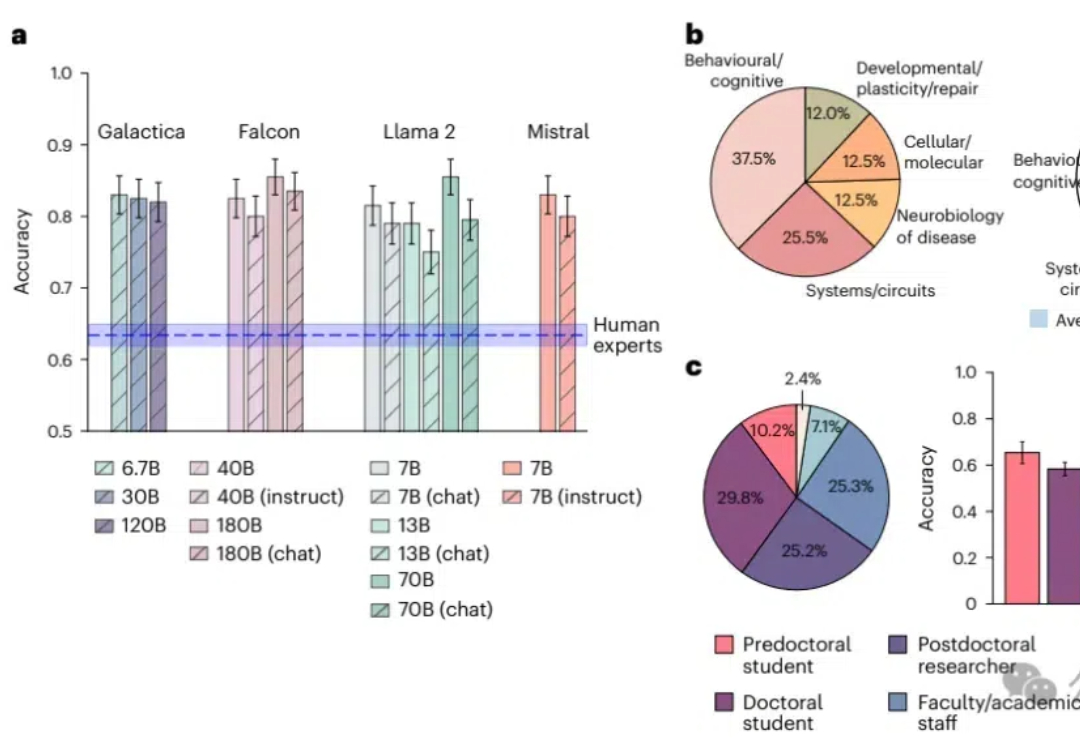

科研也完了,AI暴虐170位人类专家!Nature子刊:大模型精准预测研究结果,准确率高达81%知识密集型工作也败了!大型语言模型在预测神经科学结果方面超越了人类专家,平均准确率达到81%,而人类专家仅为63%;模型通过整合大量文献数据,展现出了惊人的前瞻性预测能力,预示着未来科研工作中人机协作的巨大潜力。

知识密集型工作也败了!大型语言模型在预测神经科学结果方面超越了人类专家,平均准确率达到81%,而人类专家仅为63%;模型通过整合大量文献数据,展现出了惊人的前瞻性预测能力,预示着未来科研工作中人机协作的巨大潜力。

以 GPT4V 为代表的多模态大模型(LMMs)在大语言模型(LLMs)上增加如同视觉的多感官技能,以实现更强的通用智能。虽然 LMMs 让人类更加接近创造智慧,但迄今为止,我们并不能理解自然与人工的多模态智能是如何产生的。

原通义千问大模型技术负责人周畅(花名:钟煌)于 7 月 18 日被曝将离职创业,然而在 10 月 23 日,就有消息称周畅已经低调加入了字节跳动。

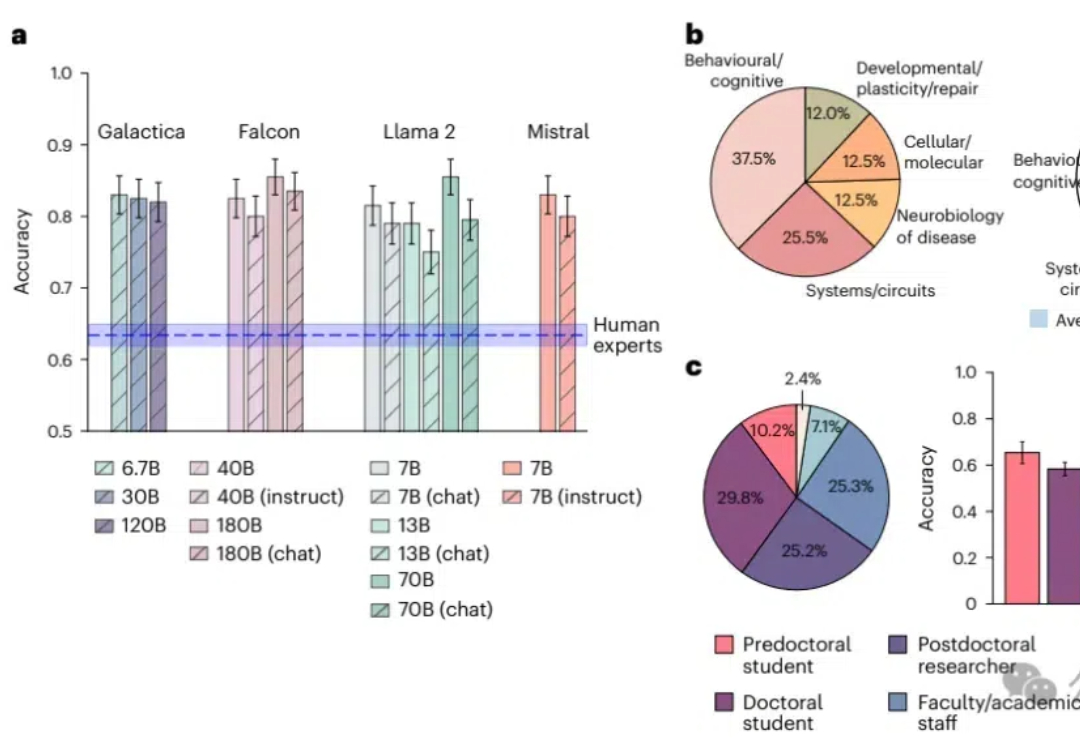

在 Minecraft 中构造一个能完成各种长序列任务的智能体,颇有挑战性。现有的工作利用大语言模型 / 多模态大模型生成行动规划,以提升智能体执行长序列任务的能力。

全国首个零售金融领域大模型天镜,揭晓了过去460多天的成绩单。 目前已实现智能营销交互、数据决策支持、防伪安全等八大应用场景。1.0版本人机交互模型完成100亿交易额,全面服务超2亿用户。

融合物理知识的大型视频语言模型PhysVLM,开源了! 它不仅在 PhysGame 基准上展现出最先进的性能,还在通用视频理解基准上(Video-MME, VCG)表现出领先的性能。

随着“AI妖股”Applovin股价暴涨790%,市值超过1000亿美金,国内大厂正加速发力生成式 AI 营销广告领域。

今天,LiblibAI与千万用户一起揭幕我们的自研图像大模型。 Star-3 Alpha 图像基座模型来了。Star-3 Alpha大模型,基于业界领先的F.1基础算法架构训练而成。 相较于以往的所有模型,Star-3 Alpha在生图效果上实现了显著的飞跃,在图像精准度、色彩表现力、美学捕捉的细腻表达等方面成为新的业界标杆。

Lilian Weng离职OpenAI后首篇博客发布!文章深入讨论了大模型强化学习中的奖励欺骗问题。随着语言模型在许多任务上的泛化能力不断提升,以及RLHF逐渐成为对齐训练的默认方法,奖励欺骗在语言模型的RL训练中已经成为一个关键的实践性难题。

如果说有一类游戏贯穿AI发展的始终,围绕其诞生的Thinking Game至今仍影响着最前沿AI技术的发展,那么答案很显然: 棋类游戏。