从裸机到700亿参数大模型,这里有份教程,还有现成可用的脚本

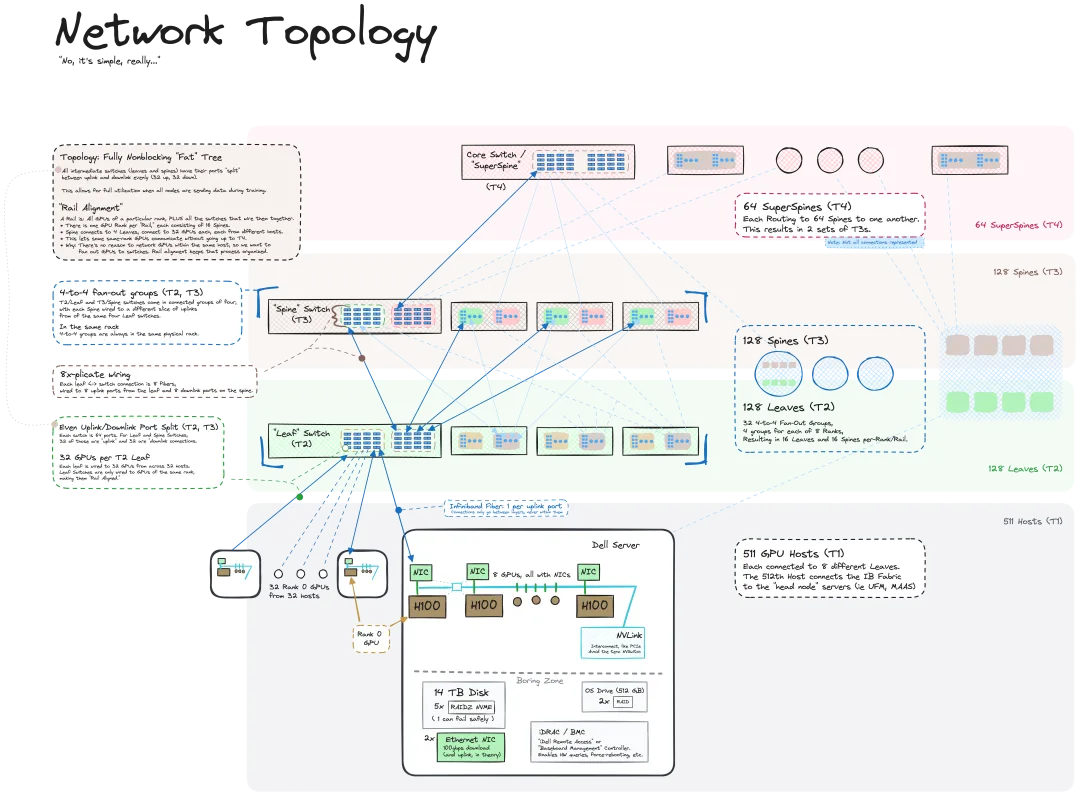

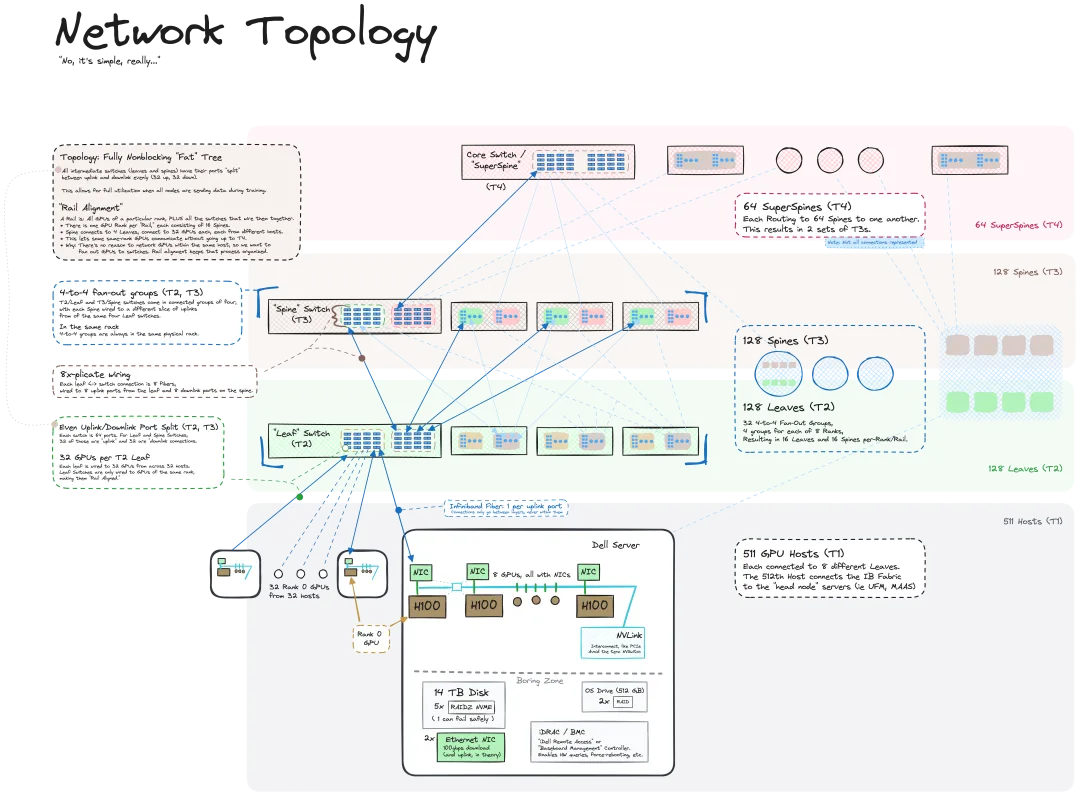

从裸机到700亿参数大模型,这里有份教程,还有现成可用的脚本我们知道 LLM 是在大规模计算机集群上使用海量数据训练得到的,机器之心曾介绍过不少用于辅助和改进 LLM 训练流程的方法和技术。而今天,我们要分享的是一篇深入技术底层的文章,介绍如何将一堆连操作系统也没有的「裸机」变成用于训练 LLM 的计算机集群。

我们知道 LLM 是在大规模计算机集群上使用海量数据训练得到的,机器之心曾介绍过不少用于辅助和改进 LLM 训练流程的方法和技术。而今天,我们要分享的是一篇深入技术底层的文章,介绍如何将一堆连操作系统也没有的「裸机」变成用于训练 LLM 的计算机集群。

开源与闭源的纷争已久,现在或许已经达到了一个新的高潮。

就在刚刚,Meta 如期发布了 Llama 3.1 模型。

很多公司现在都可以说自己是AI行业的,但形成模式≠有长期价值。

大模型迈入“小而强”时代。

基于评测维度,考虑到各评测集关注的评测维度,可以将其划分为通用评测基准和具体评测基准。

随着人工智能技术的快速发展,能够处理多种模态信息的多模态大模型(LMMs)逐渐成为研究的热点。通过整合不同模态的信息,LMMs 展现出一定的推理和理解能力,在诸如视觉问答、图像生成、跨模态检索等任务中表现出色。

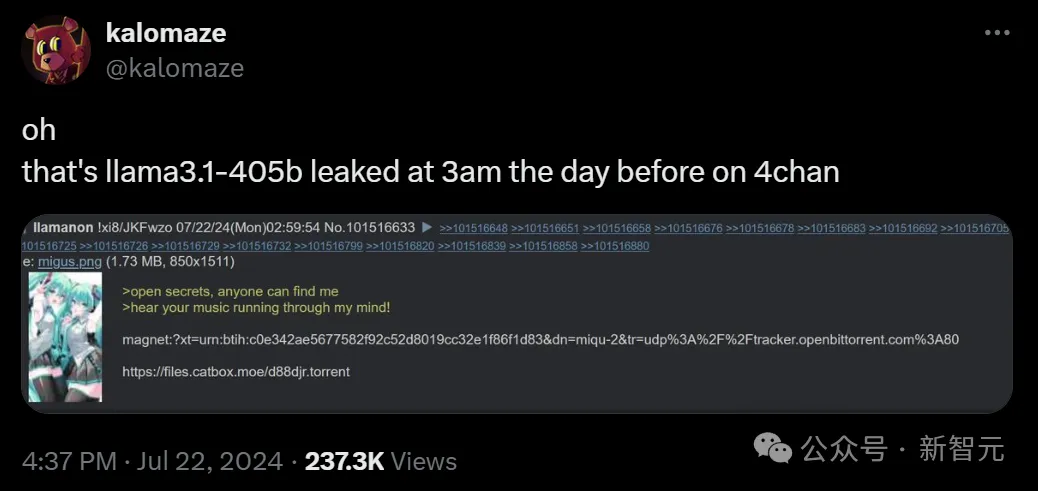

Llama 3.1 终于现身了,不过出处却不是 Meta 官方。

Llama 3.1又被提前泄露了!开发者社区再次陷入狂欢:最大模型是405B,8B和70B模型也同时升级,模型大小约820GB。基准测试结果惊人,磁力链全网疯转。

大模型技术席卷全球科技界,中国也迅速跟进这一浪潮,在诸多领域开始落地,提升了企业运营效率和消费者体验。然而,大模型企业也面临技术成熟度、成本、数据安全、行业差异、用户接受度等挑战,商业化仍然是一个摆在所有厂商面前的问题。