全面超越DPO:陈丹琦团队提出简单偏好优化SimPO,还炼出最强8B开源模型

全面超越DPO:陈丹琦团队提出简单偏好优化SimPO,还炼出最强8B开源模型为了将大型语言模型(LLM)与人类的价值和意图对齐,学习人类反馈至关重要,这能确保它们是有用的、诚实的和无害的。在对齐 LLM 方面,一种有效的方法是根据人类反馈的强化学习(RLHF)。尽管经典 RLHF 方法的结果很出色,但其多阶段的过程依然带来了一些优化难题,其中涉及到训练一个奖励模型,然后优化一个策略模型来最大化该奖励。

为了将大型语言模型(LLM)与人类的价值和意图对齐,学习人类反馈至关重要,这能确保它们是有用的、诚实的和无害的。在对齐 LLM 方面,一种有效的方法是根据人类反馈的强化学习(RLHF)。尽管经典 RLHF 方法的结果很出色,但其多阶段的过程依然带来了一些优化难题,其中涉及到训练一个奖励模型,然后优化一个策略模型来最大化该奖励。

经历为期一年的实地调研,云天励飞为深圳市交通运输局献上的新春礼物,是一套从软件到硬件,再到培养新型产业工人的智能交通巡查系统。

Alexandr Wang创办的Scale AI是一个为AI模型提供训练数据的数据标注平台,近期完成新一轮10亿美元融资,估值飙升至138亿美元。该公司表示将利用新资金生产丰富的前沿数据,为通向AGI铺平道路。

央企通信巨头再次奏响大模型舞台的超强音!刚刚结束的中国移动人工智能生态大会主旨论坛上,中国移动发布了全自研「九天」千亿多模态基座大模型,一举成为国内最值得信赖、最懂行业的全栈大模型。

5月22号,百川智能正式发布了Baichuan 4大模型,并推出成立之后的首款AI搜索助手“百小应”。

一览Beyond Expo 2024上的有趣发现。

甲方要求我一边配音,一边自拍,以此证明我是真人。

马斯克在VivaTech大会上称:只有我能做好AI。

国产大模型最新进展,这次来自“国家队”! 刚刚,全栈国产化生态大模型“九天智能基座”正式发布! 它由中国移动自研。包括万卡算力、千亿模型及百汇平台三部分。 其中模型部分是九天自主研发的从算子到框架全栈国产训练的千亿参数大模型,能力达到GPT-4的90%水平。

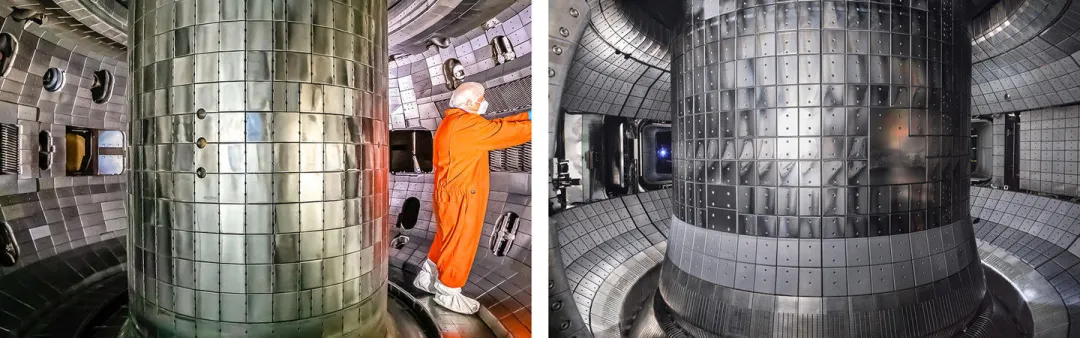

几十年来,核聚变释放能量的「精妙」过程一直吸引着科学家们的研究兴趣。 现在,在普林斯顿等离子体物理实验室(PPPL)中 ,科学家正借助人工智能,来解决人类面临的紧迫挑战:通过聚变等离子体产生清洁、可靠的能源。 与传统的计算机代码不同,机器学习不仅仅是指令列表,它可以分析数据、推断特征之间的关系、从新知识中学习并适应。